Apple 谨慎地推出了 Ferret LLM,这是一种非同寻常的多模式语言模型。 这种无声的发布打破了常规,将语言理解与图像分析融合在一起,重新定义了人工智能功能的范围。

Ferret LLM 在 GitHub 上悄然发布,标志着苹果公司迈向开放的微妙一步,吸引着开发者和研究人员发掘其潜力。 然而,在其推出过程中,将 Ferret 扩展到更大模型的挑战迫在眉睫,带来了基础设施相关的障碍。 尽管如此,Ferret 对 Apple 设备的潜在影响还是相当大的,有望为用户交互带来新的维度,并加深对视觉内容的理解。 想了解更多吗? 我们收集了您需要了解的有关苹果在人工智能领域最新举措的所有信息。

什么是Apple Ferret LLM?

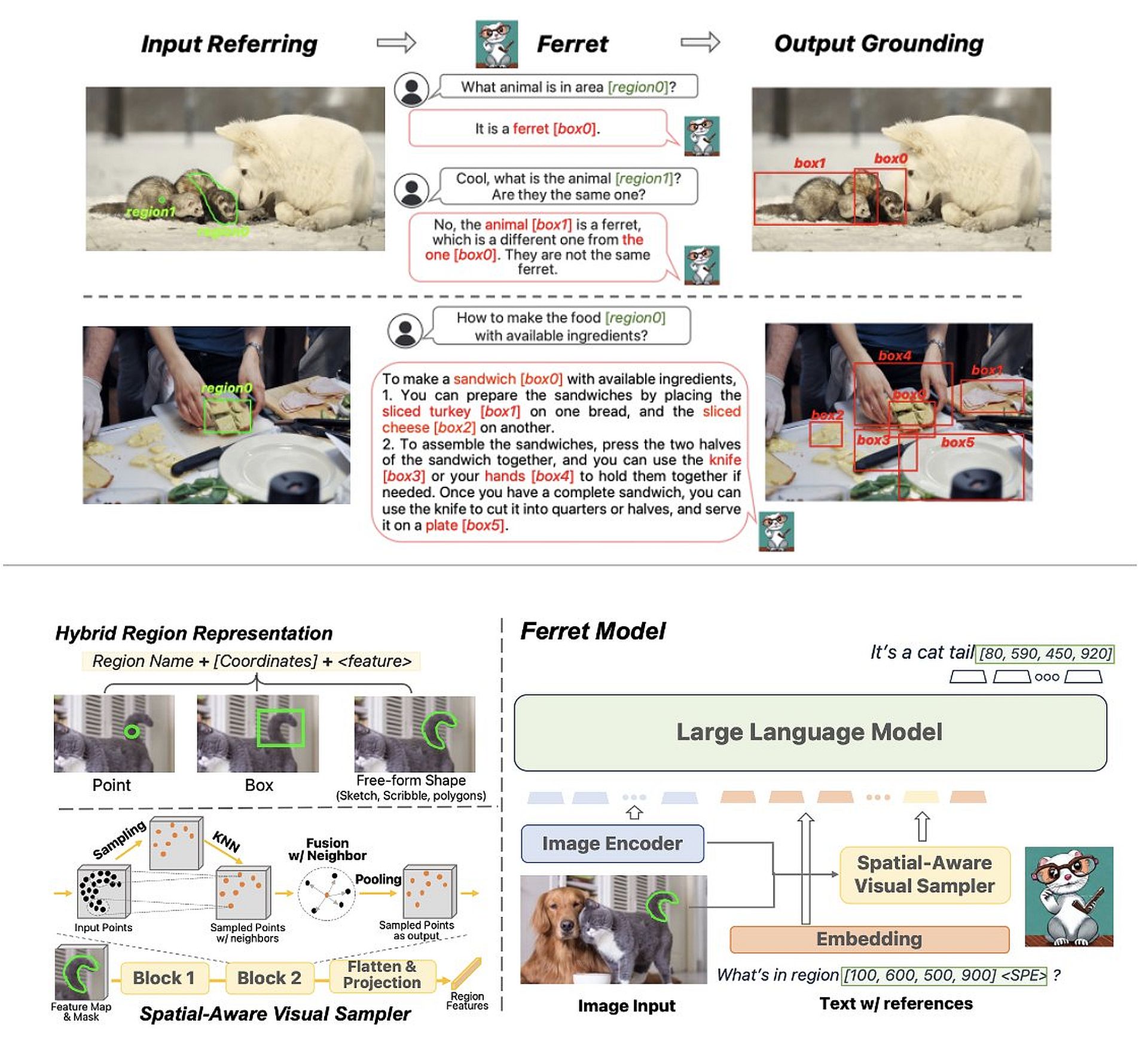

Ferret 是苹果公司与康奈尔大学合作开发的开源多模态大语言模型 (LLM),因其将语言理解与图像分析的独特集成而脱颖而出。 发布于 GitHub,它通过将视觉元素融入其处理中而不同于传统的语言模型。

Apple Ferret LLM 的运作方式如下:

- 视觉整合: Ferret 并不局限于文本理解,而是分析图像的特定区域,识别其中的元素。 然后,这些元素将用作查询的一部分,允许 Ferret 响应涉及文本和图像的提示。

- 上下文响应: 例如,当被要求识别图像中的对象时,Ferret 不仅识别该对象,而且利用周围的元素提供更深入的见解或上下文,而不仅仅是对象识别。

苹果人工智能研究科学家干哲强调了 Ferret 的参考和参考能力 理解图像中不同细节层次的元素。 这种灵活性使 Ferret 能够理解涉及复杂视觉内容的查询。

Ferret 的推出与众不同之处在于其技术实力和苹果公司走向开放的战略举措。 与它典型的保守性质不同,苹果选择将 Ferret 作为一个 开源 模型。 这种向透明度的转变意味着一种协作方法,邀请贡献并培育一个生态系统,让全球的研究人员和开发人员可以增强、完善和探索模型的功能

未来的挑战

Ferret 的出现预示着人工智能的新时代,多模态理解将成为常态而不是例外。 其功能为不同领域的无数应用打开了大门,从增强的内容分析到创新的人机交互。

然而,由于基础设施的限制,苹果在扩展 Ferret 方面面临挑战,引发了人们对其与行业巨头竞争的能力的质疑。 GPT-4 部署大规模语言模型。 这种困境需要战略决策,可能涉及合作伙伴关系或进一步采用开源原则以利用集体专业知识和资源。

有关 Apple Ferret LLM 的更多详细信息,请访问 它的 arXiv 页面。

Apple Ferret LLM 对 iPhone 和其他 Apple 设备的潜在影响

Apple Ferret LLM 的引入可能会对各种 Apple 产品产生重大影响,特别是通过以下方式增强用户体验和功能:

改进的基于图像的交互

Apple Ferret LLM 将图像分析集成到 Siri 中,可以实现更复杂的上下文交互。 用户可以提出有关图像的问题或请求基于视觉内容的操作。

Ferret 的功能可能会为苹果生态系统内的高级视觉搜索功能提供支持。 用户可以在图像中搜索项目或信息,从而获得更直观、更全面的搜索体验。

增强的用户帮助

Ferret 解释图像和提供上下文信息的能力可以极大地有利于有辅助功能需求的用户。 它可以帮助视障用户识别物体或场景,增强他们与苹果设备的日常互动。

Ferret 的集成可能会增强苹果 ARKit 的功能,从而实现基于图像理解和上下文响应的更复杂的交互式增强现实体验。

丰富媒体和内容理解

Ferret 可以通过识别和索引图像和视频中的特定元素来增强照片应用程序中的组织和搜索功能,从而实现更智能的分类和搜索。

利用 Ferret 的图像理解能力,苹果可能会根据用户与整个生态系统中视觉内容的交互来提供更加个性化的内容推荐。

开发商创新

开发人员可以利用 Ferret 的功能,通过将高级图像和语言理解融入到他们的应用程序中,创建跨从教育到医疗保健等各个领域的创新应用程序。

然而,Ferret 的功能在苹果产品中的实施将取决于多种因素,包括技术可行性、用户隐私考虑以及与现有苹果软件和硬件的集成程度。 此外,Apple 关于其产品系列中 Ferret 的可扩展性和部署的战略决策将决定对面向消费者的特性和功能的实际影响。

特色图片来源: 约翰·保罗·德拉·克鲁兹/Unsplash