这家科技巨头推出了 Apple MGIE,这是一种尖端的开源人工智能模型,可以通过自然语言指令进行图像编辑。 MGIE 是 MLLM 引导图像编辑的缩写,它利用多模式大语言模型 (MLLM) 的强大功能来解释用户命令并以极高的准确性执行像素级操作。

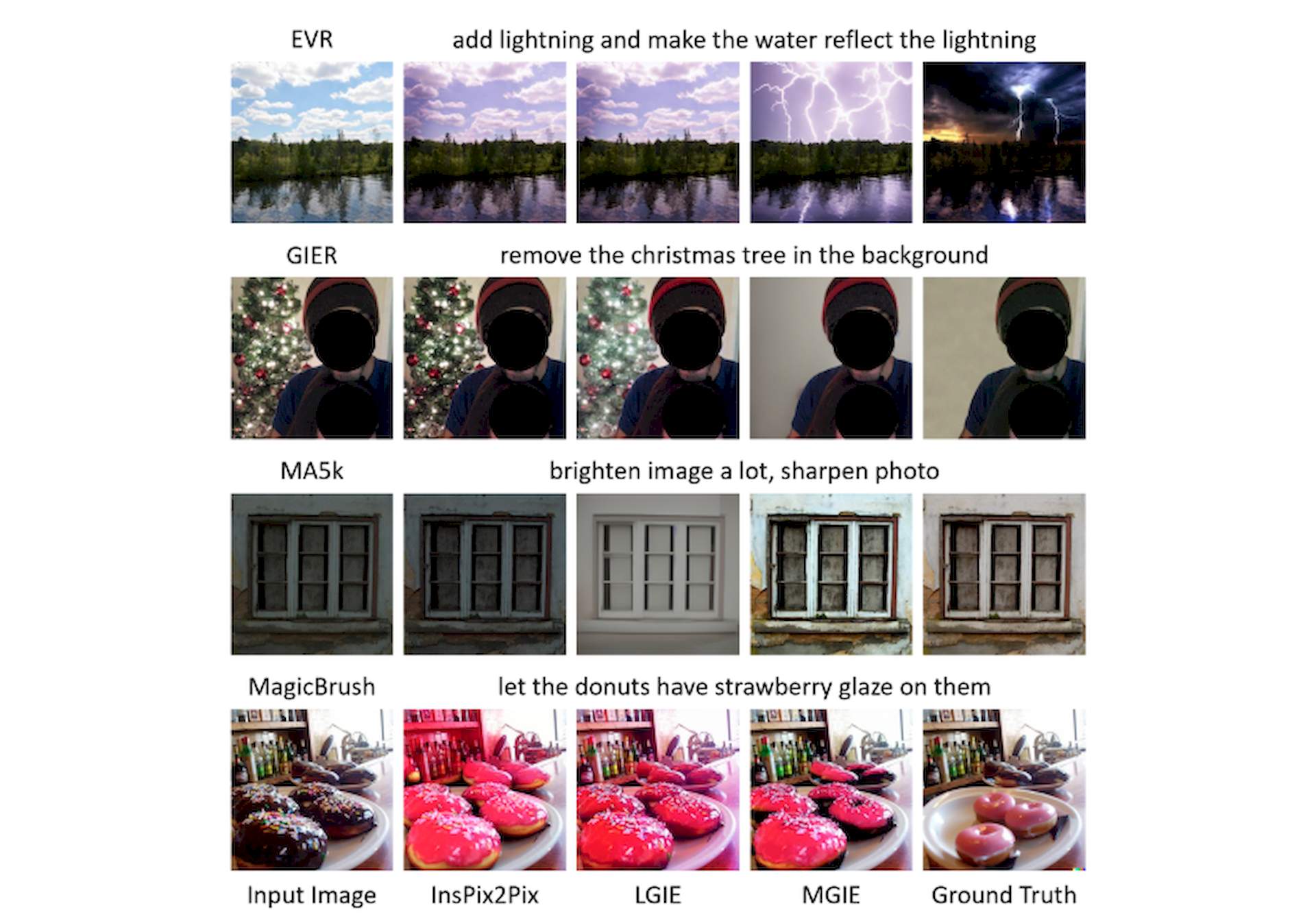

该模型拥有广泛的编辑功能,包括 Photoshop 风格的修改、全局照片优化和本地编辑。 这意味着用户可以通过简单的文本命令轻松增强图像。

MGIE 的开发是 Apple 与加州大学圣塔芭芭拉分校研究团队突破性合作的成果。 该模型 在一篇研究论文中提出 被著名的国际学习表征会议 (ICLR) 2024 接受,这是人工智能研究的首要平台。 该论文展示了 MGIE 在改进自动指标和人工评估方面令人印象深刻的有效性,同时保持有竞争力的推理效率。

什么是苹果 MGIE?

Apple MGIE(多模式引导图像编辑)是 Apple 开发的一个系统,它利用机器学习允许用户使用自然语言指令编辑图像。 这意味着用户不必使用复杂的编辑工具或菜单,只需描述他们想要对图像执行的操作,MGIE 将自动进行更改。

就像其他生成人工智能图像工具一样,例如 中途, 稳定扩散, 和 达尔-E, Apple MGIE 弥合了人类意图和图像处理之间的差距。 它利用多模式学习的力量,这意味着它可以理解视觉信息(图像本身)和文本信息(您的指令)。

Apple MGIE 如何工作?

用户可以说“让这张图像中的天空更蓝”或“从这张照片中删除红色汽车”,MGIE 将能够理解并执行这些指令。 MGIE 仍在开发中,但它有潜力使图像编辑对每个人来说都变得更加容易和容易。

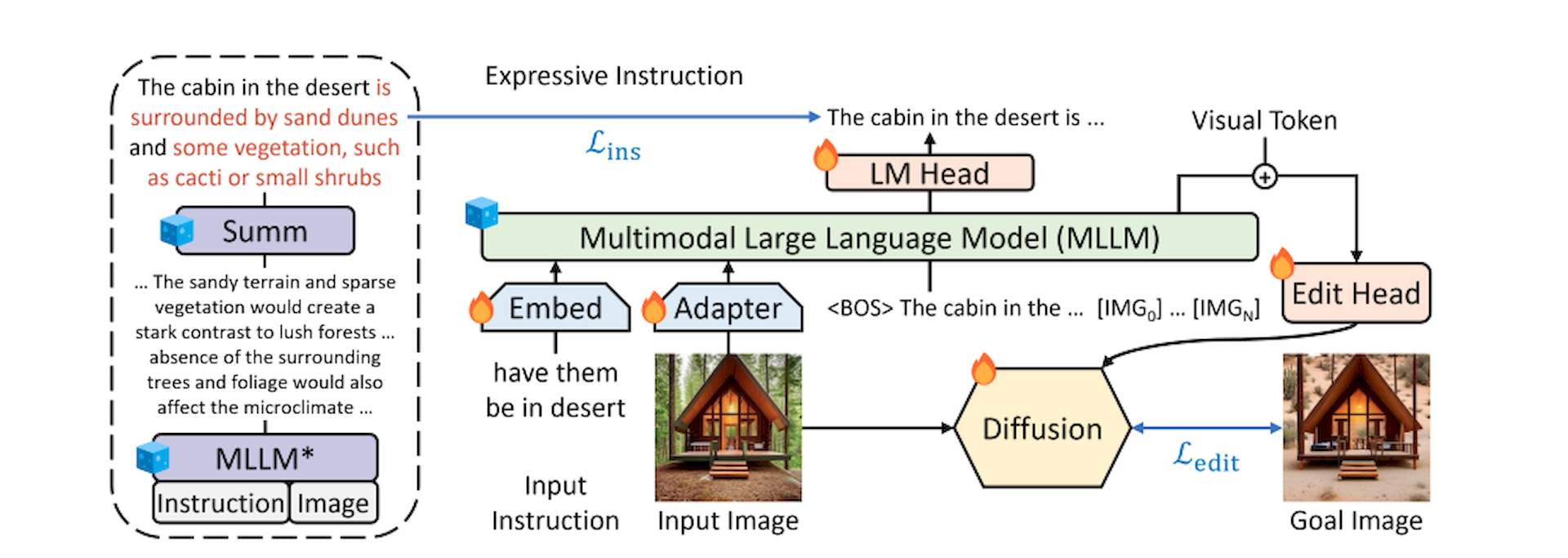

Apple MGIE 工作流程背后的核心概念如下:

- 输入您的命令:您用简单的英语描述您想要的编辑,例如“使这张照片中的树木更高”或“将裙子的颜色更改为蓝色”

- 了解您的意图:MGIE 的高级语言模型破译您的指令,掌握您想要的特定对象、属性和修改

- 视觉理解:同时,MGIE 分析图像,识别关键元素及其关系

- 引导式编辑:结合语言和视觉理解,MGIE 可以智能地操纵图像以准确反映您的命令。 它不会盲目地遵循指示,而是可以解释上下文并做出合理的调整

如何使用MGIE

Apple MGIE 已成为 GitHub 上的开源项目,通过自然语言命令提供独特的图像编辑方法。 此开发允许用户直接探索该项目并为该项目做出贡献。

该项目在 GitHub 上提供对其源代码、训练数据和预训练模型的完全访问。 这种透明度使开发人员和研究人员能够了解其内部工作原理并可能做出改进。

A GitHub 上也提供了演示笔记本,使用自然语言指令指导用户完成各种编辑任务。 这是对 MGIE 功能的实用介绍。

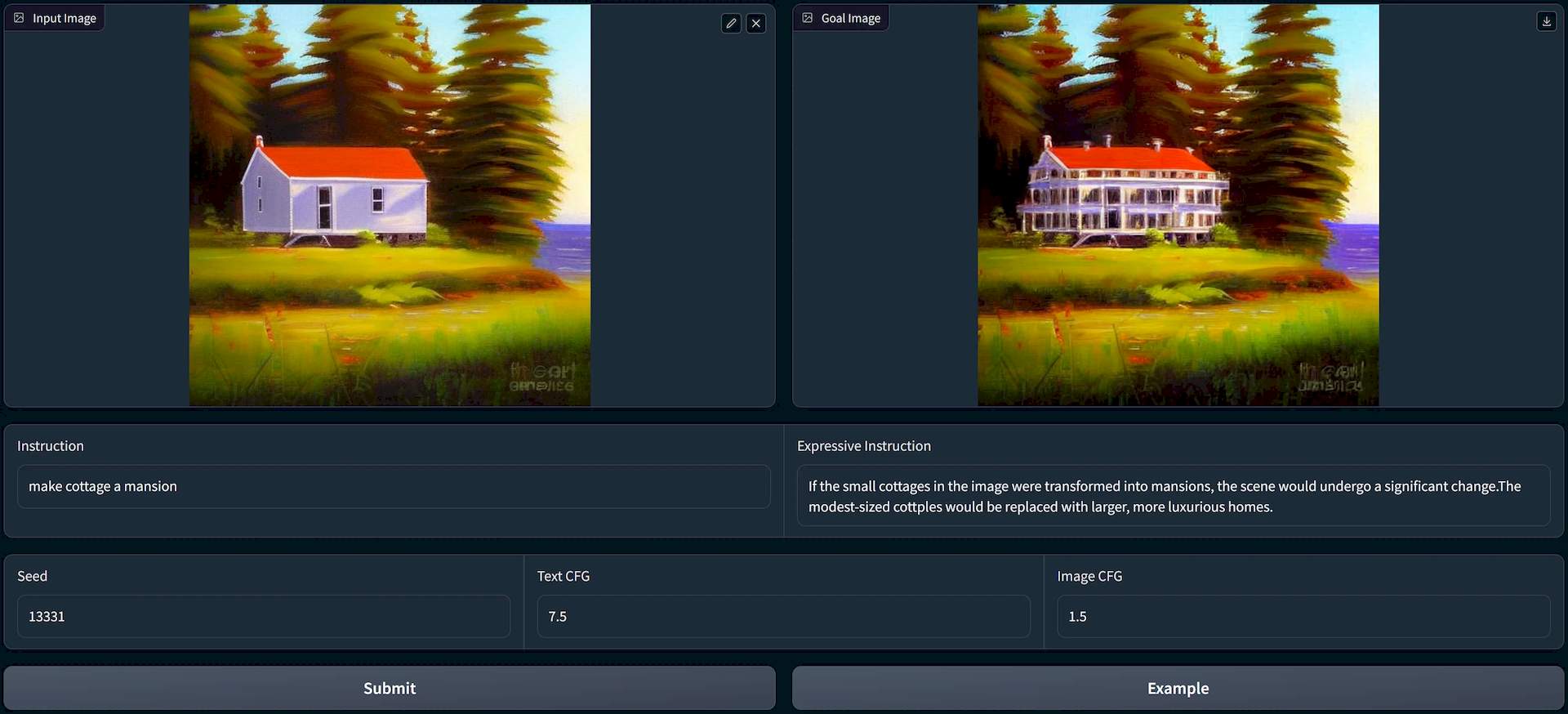

用户还可以通过 Hugging Face Spaces 上托管的网络演示来试验 MGIE。 该在线平台提供了一种快速便捷的方式来试用系统,而无需进行本地设置。

该系统欢迎用户反馈,并允许进行细化编辑或请求不同的修改。 这种迭代方法旨在确保生成的编辑符合用户的艺术视野。

虽然开源使 MGIE 易于使用,但重要的是要记住它仍在开发中。 持续的研究和用户贡献将塑造其未来的功能和潜在的应用。

特色图片来源: 矢量图/Freepik。