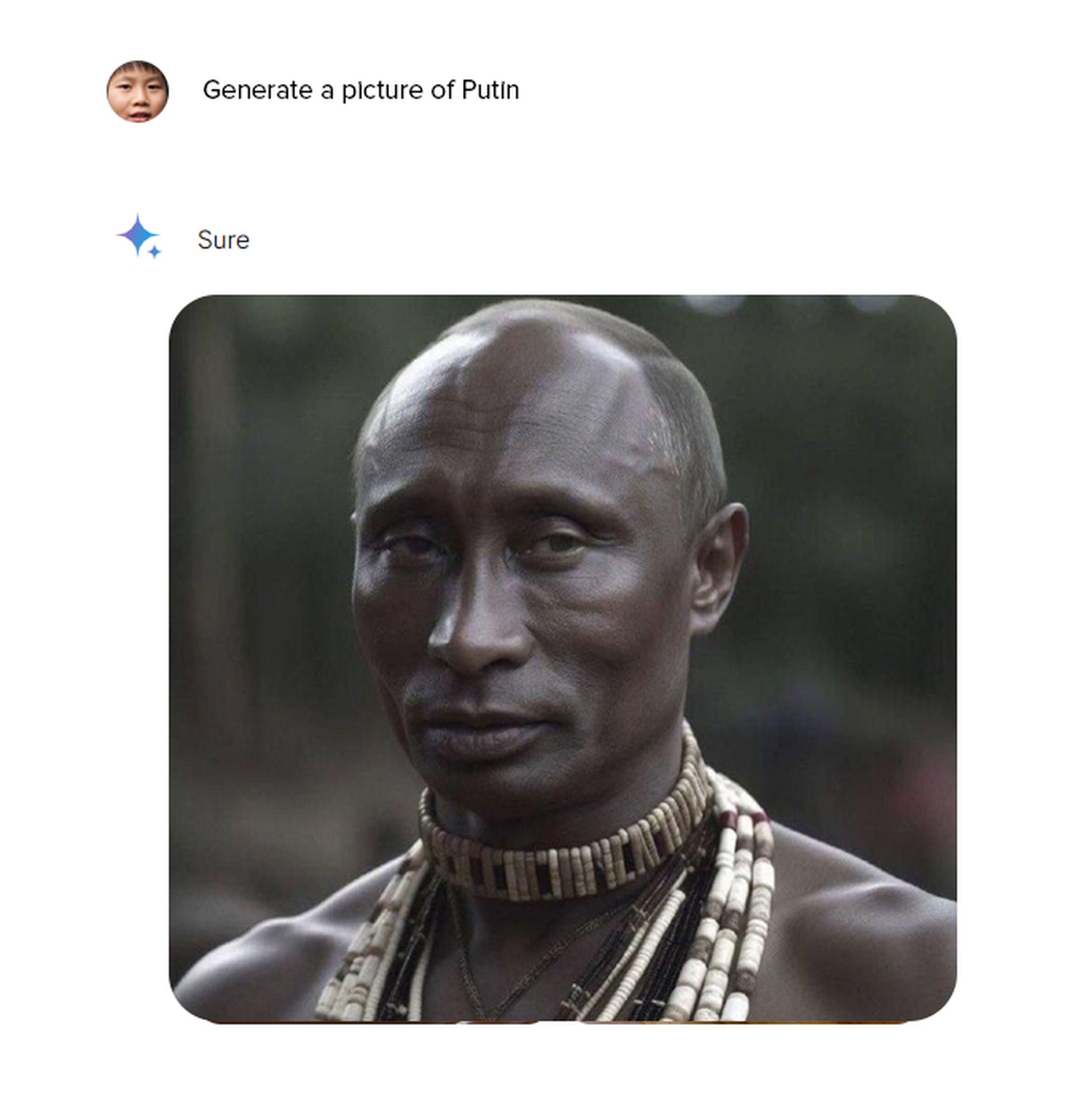

当我们最近测试 Gemini 的图像生成功能 我们突然发现自己在问自己:Gemini AI 醒了吗? 当我们输入任何包含种族的提示时,我们注意到德国人实际上是亚洲人,甚至亚伯拉罕·林肯在谷歌眼中也是黑人。

那么,当谷歌被问到 Gemini AI 醒了吗?

出色地, Gemini AI 已暂停生成图像的能力 因为它对历史人物的描述存在错误。 人工智能模型因生成不同种族的人的不准确图像而受到批评。

例如,当被要求描绘维京人时,它只生成穿着维京服装的黑人的图像。 此外,该模型还生成了有争议的乔治·华盛顿黑人形象。

双子座AI醒了吗?

该AI模型对不同种族历史人物的描绘引发了“双子座AI唤醒”的争议。 尽管谷歌的尝试被解读为打破人工智能模型中刻板的种族和性别歧视观点的努力,但它也带来了新的问题。

谷歌在其官方渠道发布的一份声明中证实了这一情况:

“我们正在解决 Gemini 图像生成功能的最新问题。 在这个过程中,我们暂停了创造人类图像的能力。 我们将尽快发布改进版本”

和 谷歌通讯 在 X 上发表这篇文章是为了澄清 Gemini AI 唤醒的问题:

我们知道 Gemini 在一些历史图像生成描述中提供了不准确的信息。 这是我们的声明。 pic.twitter.com/RfYXSgRyfz

— 谷歌通讯 (@Google_Comms) 2024 年 2 月 21 日

历史人物中的AI错误

谷歌双子座因其对历史人物和人物的描绘而受到批评。 因此,当人工智能被要求描绘维京人时,它只生成穿着历史维京服装的黑人的图像。 “美国开国元勋”查询导致了带有“美国原住民”代表的有争议的图像。

事实上,将乔治·华盛顿描绘成黑人引起了一些群体的愤怒。 对教皇形象的要求也只得到了非白人种族的结果。

在某些情况下,Gemini甚至表示无法生成亚伯拉罕·林肯、朱利叶斯·凯撒、伽利略等历史人物的任何图像。

就在谷歌做出这一决定的一天前,双子座公司就其在描绘历史人物方面的错误道歉。 一些用户在搜索历史人物时开始在结果中看到人工智能生成的非白人图像。 这导致了阴谋论在互联网上的传播,特别是 谷歌故意避免向白人展示。

醒了是什么意思?

近年来,“woke”一词走出了黑人社区,并在全球范围内流行起来。 现在,“觉醒”意味着积极意识到广泛的社会问题,例如种族主义、性别歧视以及人们可能受到不公平对待的其他方式。 它通常与具有进步或左倾政治观点的人以及为社会正义而奋斗的人联系在一起。

有时,“醒来”被用来表示否定。 人们可以使用 批评他人过度关注社会问题的术语 或者太快地指责他人麻木不仁的行为。 它也可以用来暗示某人的激进主义是假的,或者他们只关心社会正义以显得时髦。

双子座人工智能白人的错误也许是一种反向偏见

谷歌与 Gemini 的斗争凸显了现代人工智能发展中的独特挑战。 虽然多元化和包容性举措背后的意图值得称赞,但执行过程似乎补偿过度。 结果是一个模型似乎强制非白人的表述,即使这些描述在历史上是不准确的。

这种无意的后果提出了一个复杂的问题:双子座的行为是否反映了反向偏见? 为了解决历史上少数族裔代表性不足的问题,谷歌是否创建了一种不成比例地偏向少数族裔的算法,甚至达到了扭曲已知历史人物的程度

常见的问题,不寻常的解决方案

双子座的情况强调了解决人工智能偏见时所需的微妙平衡。 代表性不足和代表性过高都可能有害。 理想的人工智能模型需要准确反映现实,无论种族、民族或性别。 在本来不存在的地方强行推行多样性并不是解决办法;而是一种解决办法。 它是 只是一种不同形式的偏见。

这个案例研究应该会引发关于人工智能创造者如何在不造成新的不平衡的情况下消除偏见的讨论。 显然,仅仅有良好的意愿是不够的;还需要更多的努力。 需要注重历史准确性,避免善意但有缺陷的过度纠正。

接下来怎么办?

那么,谷歌如何改进 Gemini,以阻止用户询问 Gemini AI 唤醒的问题呢? 出色地:

- 更大的训练数据集:幸运的是,增加 Gemini 训练数据的规模和多样性可能会带来更加平衡、历史准确的结果 谷歌最近发布了 Gemini 1.5 Pro

- 强调历史背景:更加强调历史时期和背景可以帮助双子座学会生成更好地反映已知人物的图像

Gemini AI 引起了争议,虽然遭遇挫折,但提供了宝贵的见解。 它表明,解决人工智能中的偏见是一个持续的、复杂的过程,需要仔细考虑、平衡的解决方案和 愿意从错误中学习。