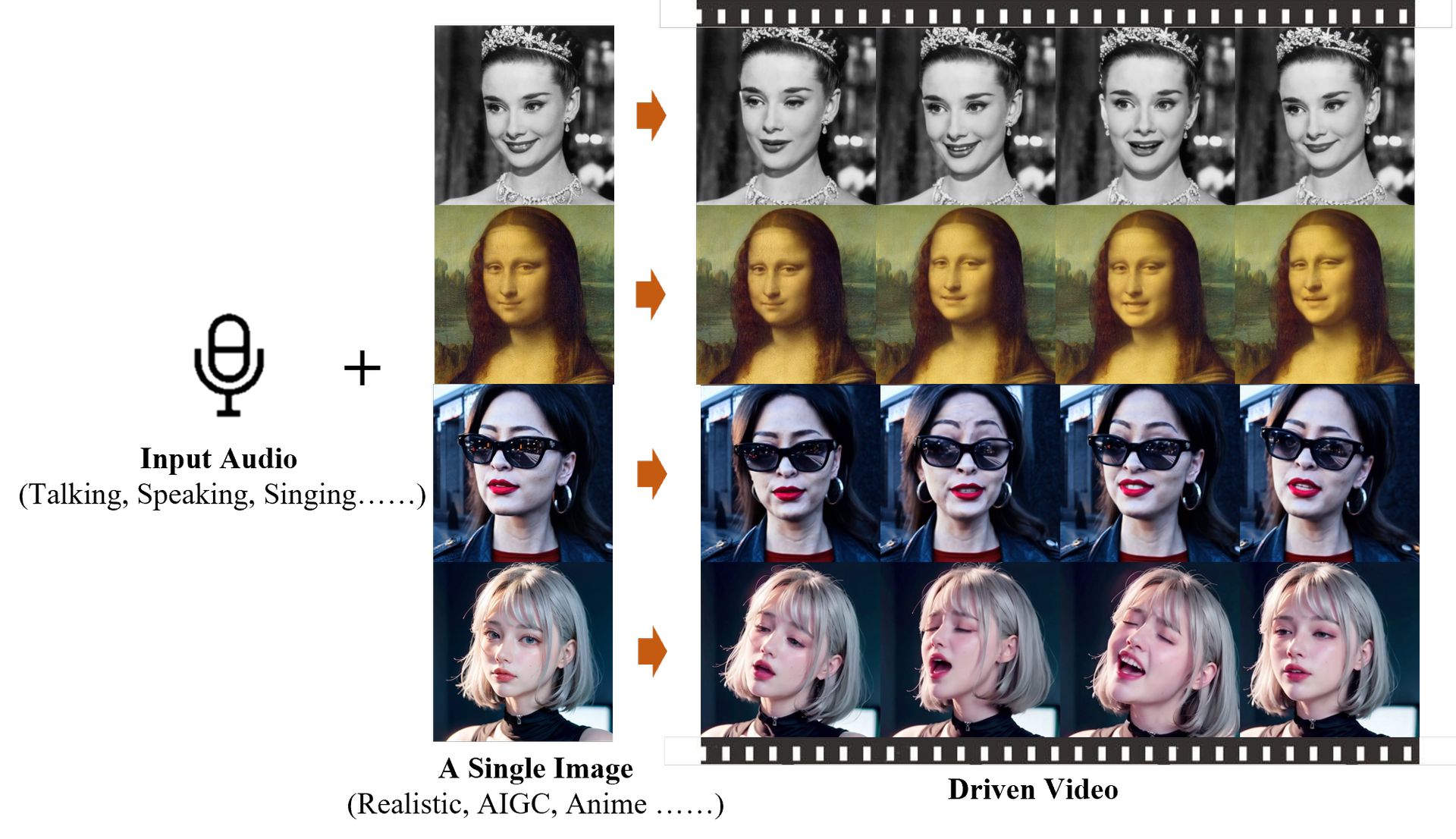

您是否曾经希望您的静态照片能够说话或唱歌? EMO 是 Emote Portrait Alive 的缩写。 EMO 由阿里巴巴智能计算研究院的研究人员开发,是一个旨在实现这一目标的人工智能系统。

EMO 采用独特的动画方法,通过直接将音频转换为视频帧来绕过复杂的 3D 模型。 这意味着您的动画视频保留了语音或歌曲的自然动作和表达,所有这些都来自单个照片和音频剪辑。

阿里巴巴AI:什么是EMO(Emote Portrait Alive)?

EMO,即Emote Portrait Alive,是阿里巴巴智能计算研究院研究人员开发的人工智能系统。 其主要功能是 将静态肖像照片动画化,制作视频,其中主题看起来很真实地说话或唱歌。

EMO 的与众不同之处在于它生成这些动画的方法。 EMO 不依赖通常难以捕捉人类表达细微差别的传统方法,而是直接将音频波形转换为视频帧。 这意味着它不需要中间 3D 模型或面部标志来生成动画。 相反,它专注于捕捉与自然语音相关的微妙面部动作和个人面部风格。

就在

这是我见过的最令人惊叹的音频视频。

它被称为 EMO:表情肖像活着 pic.twitter.com/3b1AQMzPYu— 时间旅行者 Stelfie (@StelfieTT) 2024 年 2 月 28 日

EMO 的技术基于扩散模型,该模型以其生成逼真的合成图像的能力而闻名。 为了训练该系统,研究人员使用了来自各种来源的大型头部说话视频数据集,包括演讲、电影、电视节目和音乐表演。 这种广泛的培训使 EMO 能够制作高质量的视频,同时保留主题的身份并传达表现力。

除了生成对话视频外,EMO 还可以将歌唱肖像制作成动画。 将嘴形和面部表情与声音同步可以创建不同风格和持续时间的歌唱视频。

虽然 EMO 的发展为个性化视频内容创作提供了令人兴奋的可能性,但它也引起了道德问题。 存在误用的风险,例如 冒充 或传播 误传。 因此,必须谨慎部署此类技术,并确保采取适当的保障措施来解决这些道德问题。

皮卡口型同步 让人工智能生成的视频也能说话

EMO 如何运作?

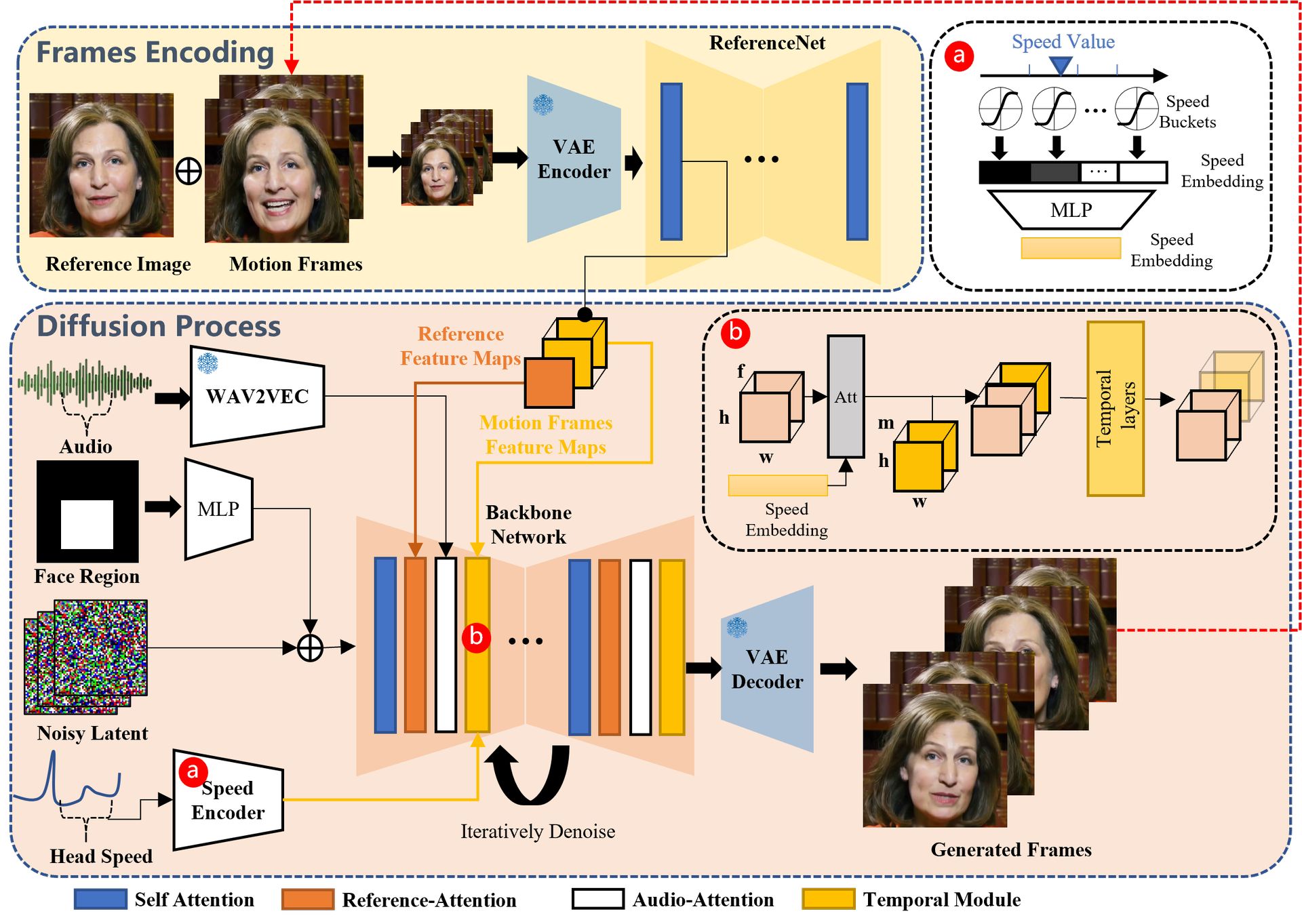

EMO 系统分两个主要阶段运行:帧编码和扩散过程。

- 帧编码:从参考图像和运动帧中提取特征,为动画奠定基础。

- 扩散过程:利用预训练的音频编码器来处理音频输入。 它将面部区域蒙版与多帧噪声集成在一起以生成动画。 主干网络在参考注意和音频注意机制的帮助下对动画进行降噪。 时间模块调整运动速度。

你可以用 EMO 做什么?

EMO 提供了一个多功能工具,用于创建逼真的动画视频,扩展了个性化和富有表现力的内容创建的可能性,例如:

- 唱歌:生成声音头像视频,具有与歌唱音频输入同步的富有表现力的面部表情。

- 语言与风格:支持多种语言和肖像风格,捕捉动态头像动画的色调变化。

- 节奏快:确保角色动画与快节奏节奏同步。

- 说:响应各种语言和风格的语音输入,制作肖像动画。

- 跨演员表演:在多语言和多文化背景下描绘电影或其他媒体中的角色。

综上所述,EMO,也称为“Emote Portrait Alive”,是动画技术的重大进步。 它可以将静态图片变成生动的视频,让拍摄对象看起来很逼真地说话或唱歌。 EMO 通过直接将音频转换为视频帧、准确捕捉面部表情和动作来实现这一目标。 虽然 EMO 为创建动态视觉内容提供了令人兴奋的可能性,但必须解决对其潜在滥用的道德担忧。 尽管如此,EMO 提供了一个宝贵的工具,可以让静态图像变得栩栩如生,并有可能改变我们未来与视觉媒体互动的方式。

欲了解更多详细信息, 这里 是它的研究论文。

特色图片来源: EMO:动态肖像研究研究