凭借其新的 1 位 LLM 技术,微软可能刚刚破解了在聊天机器人和语言工具背后创建强大人工智能的代码,这些人工智能和语言工具可以放在你的口袋里,运行速度快如闪电,并帮助拯救地球。

好吧,放弃行星部分,但这确实是一件大事!

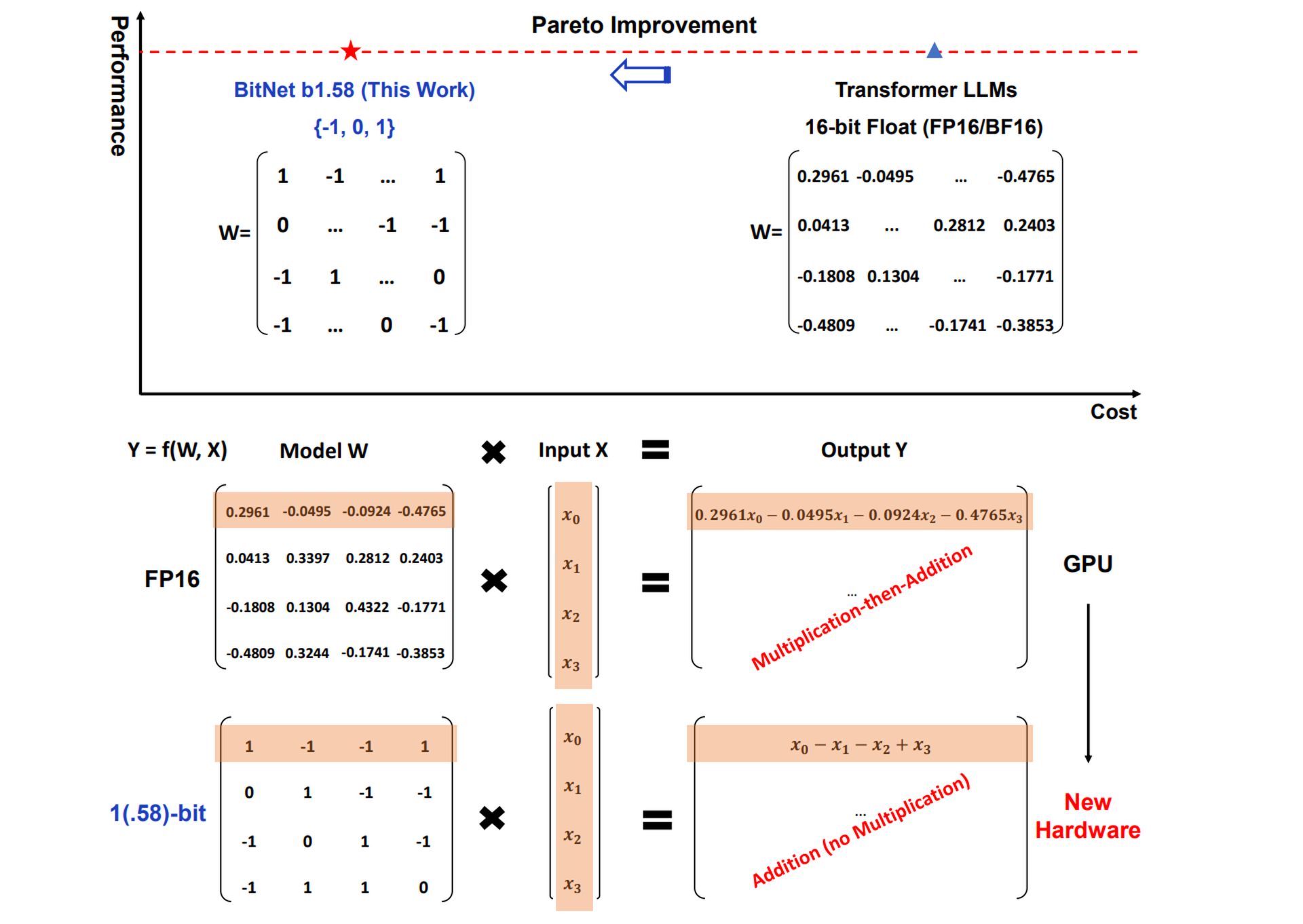

传统的法学硕士,工具背后强大的人工智能模型 聊天GPT 和 双子座,通常使用 16 位甚至 32 位浮点数 来表示模型的参数或权重。 这些权重决定了模型如何处理信息。 微软的 1 位 LLM 采用了一种完全不同的方法,将这些权重量化(降低精度)至 仅 1.58 位。

对于 1 位 LLM,每个权重只能采用三个值之一:-1、0 或 1。

这 可能看起来受到很大限制,但它导致 显着优势。

1 位法学硕士有什么大惊小怪的?

1 位法学硕士资源需求的减少可以使人工智能应用程序能够在更广泛的设备上运行,甚至是那些内存或计算能力有限的设备。 这可能会导致人工智能在各个行业得到更广泛的采用。

较小的大脑 意思是 人工智能可以在更小的设备上运行:您的手机、智能手表,应有尽有。

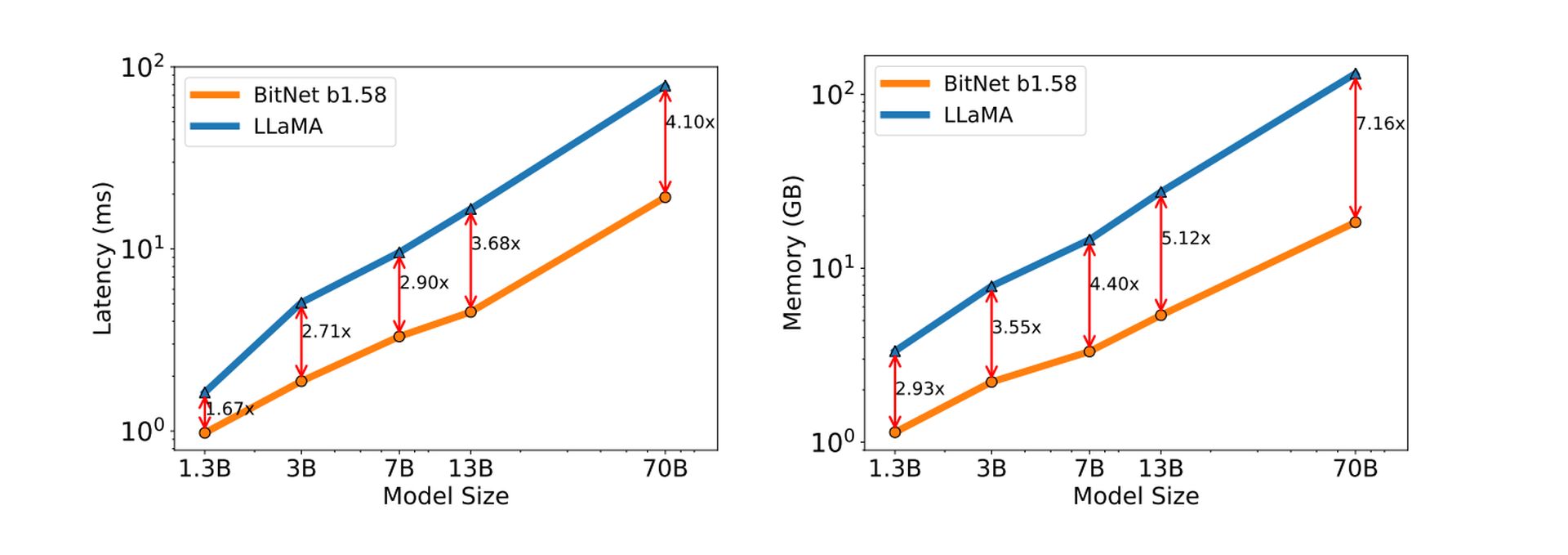

1 位 LLM 中权重的简化表示可转化为更快的推理速度——生成文本、翻译语言或执行其他语言相关任务的过程。

更简单的计算意味着 人工智能思考和响应速度更快。

1 位 LLM 的计算效率还可以降低能耗,使其运行起来更加环保且更具成本效益。

更少的计算能力等于更少的能源消耗。 这是环保技术的重大胜利,是实现这一目标的最终一步 让人工智能变得绿色。

除此之外,1 位 LLM 的独特计算特性为设计针对其操作进行优化的专用硬件提供了可能性,从而有可能进一步提高性能和效率。

认识 Microsoft 的 BitNet LLM

微软对该技术的实现称为 比特网b1.58。 额外的 0 值(与真正的 1 位实现相比)是增强模型性能的关键元素。

BitNet b1.58 展示了显着的结果,即使在严格量化的情况下,在某些情况下也接近传统 LLM 的性能。

突破16位障碍

如前所述,传统法学硕士利用 16 位浮点值 (FP16) 来表示模型中的权重。 虽然提供高精度,但这种方法可能会占用大量内存且计算成本较高。 BitNet b1.58 通过采用 1.58 位三进制权重表示来打破这种范式。

这意味着每个权重只能采用三个不同的值:

- -1:表示对模型的输出有负面影响

- 0:表示对输出没有影响

- +1:代表对输出有积极影响

有效映射权重

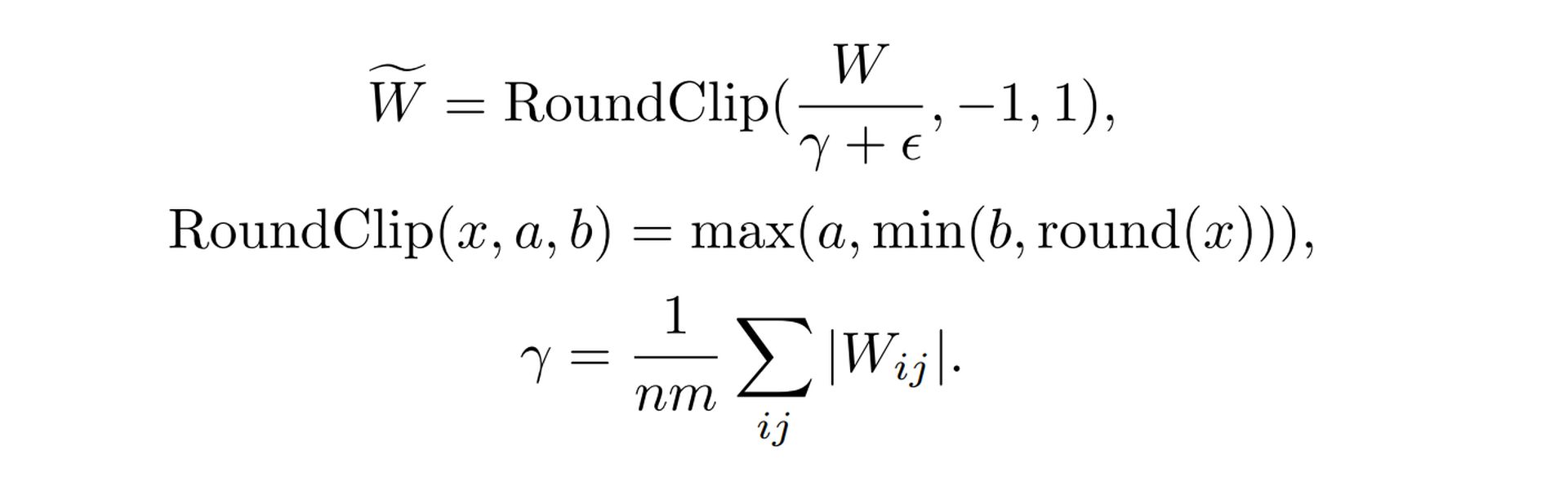

从连续(FP16)权重空间过渡到离散(三元)权重空间需要仔细考虑。 BitNet b1.58 采用 特殊量化函数 有效地实现这种映射。 该函数采用原始 FP16 权重值并应用特定算法来确定最接近的对应三元值(-1、0 或 +1)。 这里的关键是尽量减少这种转换造成的性能下降。

这是该功能的简化分解

- 缩放:该函数首先按其平均绝对值缩放整个权重矩阵。 这确保权重以零为中心

- 四舍五入:然后将每个权重值舍入为 -1、0 和 +1 中最接近的整数值。 这会将缩放后的权重转换为离散三元系统

详细公式见 微软的 1-Bit LLM 研究论文。

激活缩放

激活是 LLM 的另一个重要组成部分,在 BitNet b1.58 中也经历了扩展过程。 在训练和推理期间,激活被缩放到特定范围(例如,-0.5 到+0.5)。

这种缩放有两个目的:

- 表现 优化:缩放激活有助于在 BitNet b1.58 降低精度的环境中保持最佳性能

- 简化:所选的扩展范围简化了实施和系统级优化,而不会带来明显的性能缺陷

开源兼容性

这 法学硕士研究 社区因开源协作而蓬勃发展。 为了便于与现有框架集成,BitNet b1.58 采用了与流行的 LLaMA 模型架构中类似的组件。 这包括以下元素:

- 均方根标准值:稳定训练过程的标准化技术

- 斯维格鲁:具有效率优势的激活函数

- 旋转嵌入:表示模型中单词和位置的方法

- 消除偏见:简化模型架构

通过合并这些 骆驼与组件类似,BitNet b1.58 可以轻松地与流行的开源 LLM 软件库集成,从而最大限度地减少研究社区采用所需的工作量。

特色图片来源: 手绘。