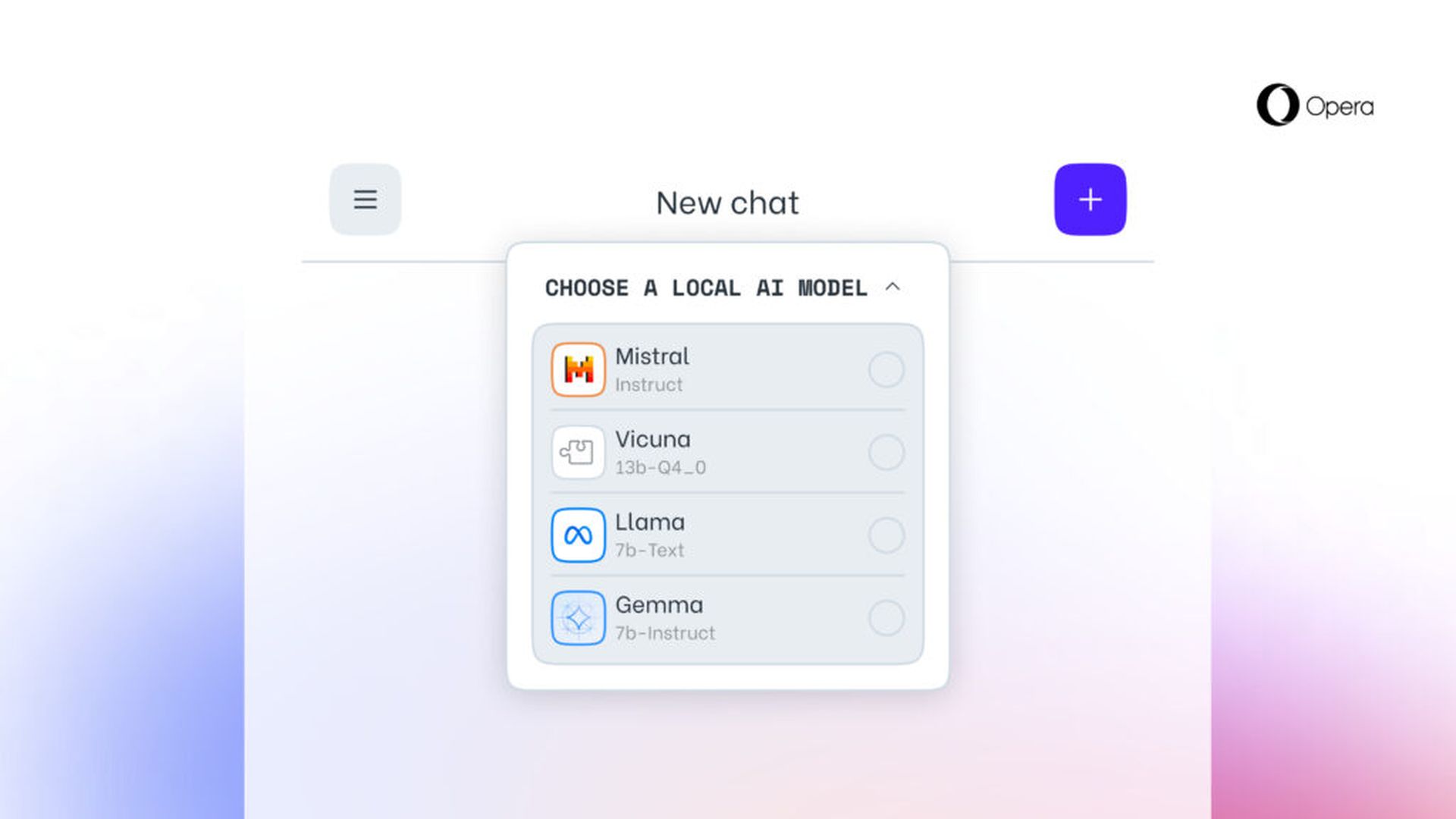

歌剧 透露 今天,它计划整合对 150 个本地大型语言模型 (LLM) 变体的实验性支持,这些变体源自大约 50 个不同的模型系列。 该功能将首先在开发者流中进入 Opera One,带来 50多个系列的150款车型 供用户选择。

这些包括 骆驼毛 和 骆驼 分别来自 Google 和 Meta。 这意味着该功能将通过 Opera 的 AI 功能投放计划向消费者提供,并将让消费者尽早获得一些此类 AI 功能。 这些模型通过浏览器在您的计算机上运行,并使用 Ollama 开源框架运行。 目前提供的所有模型均选自 Ollama 库,但该公司希望将来能够包含其他来源的一些模型。

其中每一个都需要本地 PC 上超过 2GB 的空间据该公司称。 因此,为了避免空间不足,请明智地使用可用空间。 有趣的是,如果以模型形式下载数据,Opera 不会尝试保存数据。

您还可以在 HuggingFace 和 Quora 上的 PoE 等网站上在线查看其他模型,因此它确实适合您本地的模型测试需求。

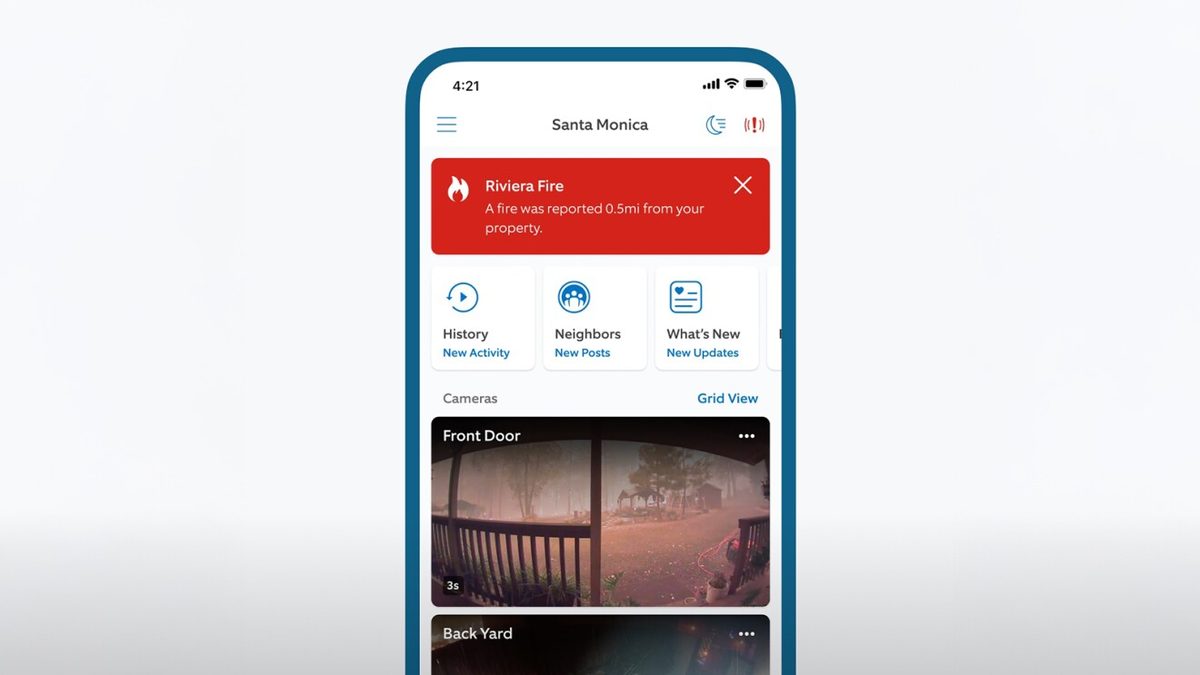

大型语言模型现在支持直接在用户设备上处理数据,从而能够使用生成式人工智能,同时保持信息的私密性并远离任何外部服务器。 Opera 宣布计划通过 Opera One 开发者渠道向当地法学硕士引入这一创新方法,作为其新的 AI 功能下降计划的一部分。 这一举措为早期用户提供了及时、定期尝试浏览器人工智能功能尖端版本的机会。 从今天开始,Opera One Developer 的用户将可以自由选择处理数据的首选模型。

如何尝试 Opera 中的内置法学硕士?

要使用这些模型,用户应该 升级到最新的 Opera Developer 版本 和 执行一系列步骤 要启用这个令人兴奋的功能:

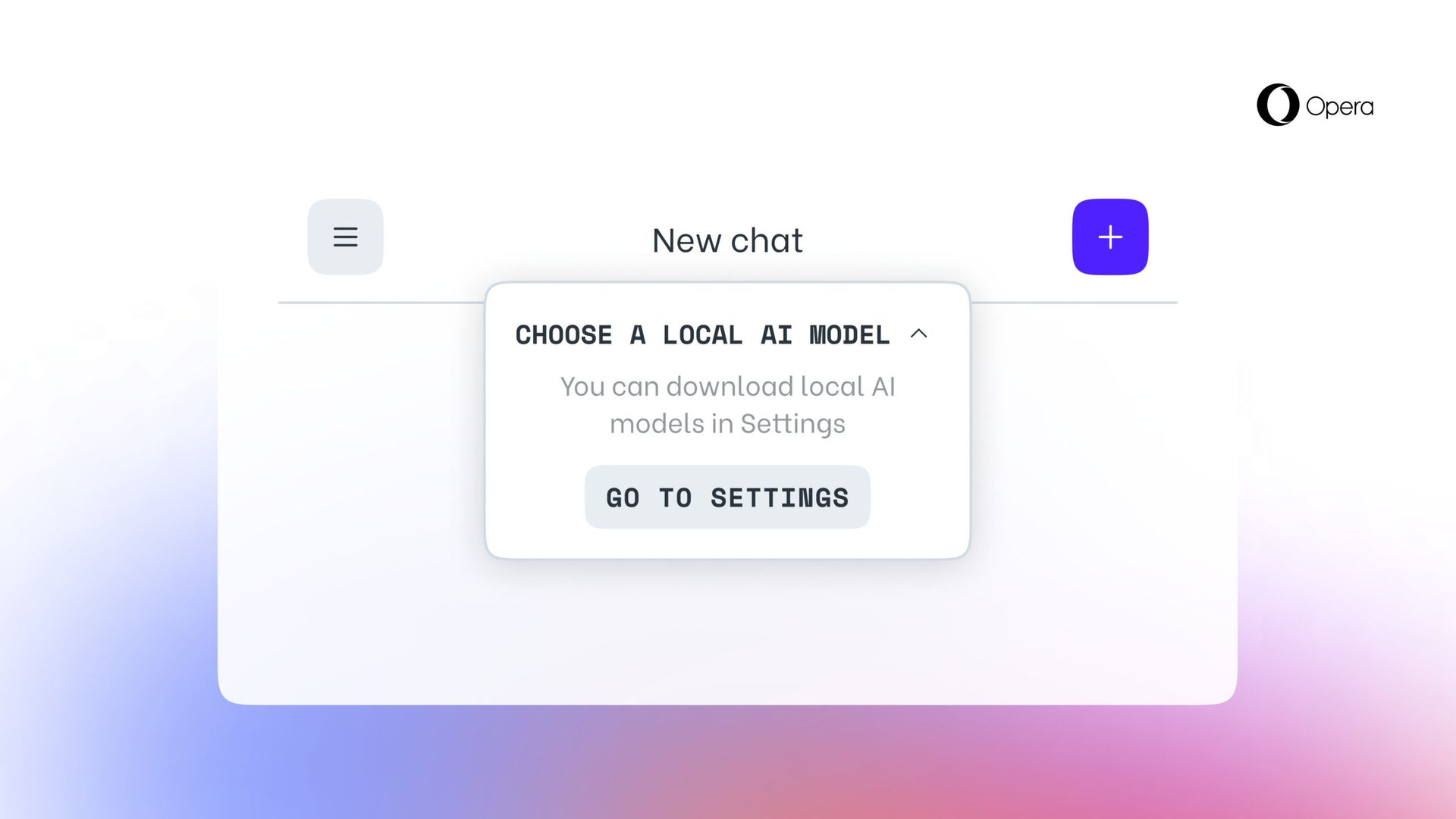

- 像之前一样访问 Aria Chat 侧边栏。 在聊天顶部,有一个标记为“的下拉菜单”选择本地模式。”

- 选择 ”前往设置”从此菜单中。

- 该区域允许您 探索并决定您要下载的模型。

- 对于更小更快的选项,请考虑下载名为 宝石:2B-指令-Q4_K_M 单击右侧的下载图标。

- 下载完成后, 单击左上角的菜单按钮启动新的聊天会话。

- 同样,您将在聊天顶部看到一个下拉菜单“选择本地模式”,您可以在其中选择刚刚安装的型号。

- 在聊天中输入您的提示,本地托管模型将做出响应。

参与者将选择本地法学硕士下载到他们的设备上。 这种方法需要在 2 至 10 GB 存储空间 对于每个版本,都提供了使用 Opera 内置浏览器 AI Aria 的替代方案。 此设置将保持不变,直到用户发起与 AI 的新交互或选择重新激活 Aria。

特色图片来源: 歌剧