你还记得 Google 的 Bard(现在称为 Gemini)吗? 无法回答有关詹姆斯·韦伯太空望远镜的问题 在其发布广告中? 让我来唤起你对这个著名案例的回忆——这是我们见过的人工智能幻觉的最大例子之一。

发生了什么? 在广告中,Google Bard 演示者被问到:“我可以与我 9 岁的孩子分享詹姆斯·韦伯太空望远镜的哪些新发现?” 短暂停顿后,Google Bard 演示给出了两个正确答案。 然而,它的最终答案是错误的。 根据谷歌巴德演示,该望远镜捕获了太阳系外行星的第一张图像。 然而,实际上,欧洲南方天文台的甚大望远镜已经拍摄了这些“系外行星”的图像,并将其存储在美国宇航局的档案中。

不是一个~好吧,实际上~混蛋,我相信巴德会令人印象深刻,但郑重声明:JWST 没有采取 "太阳系外行星的第一张图像"。

第一张图像是由 Chauvin 等人完成的。 (2004) 与使用自适应光学器件的 VLT/NACO。 https://t.co/bSBb5TOeUW pic.twitter.com/KnrZ1SSz7h

— 格兰特·特伦布莱 (@astrogrant) 2023 年 2 月 7 日

为什么像谷歌这样的科技巨头就不能阻止这样的错误呢? 让我们来看看吧!

什么是AI幻觉?

当通常由人工智能 (AI) 驱动的计算机程序产生不正确、无意义或误导性的输出时,就会出现人工智能幻觉。 该术语通常用于描述人工智能模型生成完全偏离轨道或与输入无关的响应的情况。 这就像提出一个问题并得到一个没有任何意义或根本不是你所期望的答案。

要了解 为什么人工智能会产生幻觉 发生这种情况,让我们看看 AI 是如何工作的。 聊天机器人或图像识别系统等人工智能模型在大型数据集上进行训练,以学习模式并做出预测。 然而,如果训练数据有缺陷、不完整或有偏差,人工智能模型可能会学习到不正确的模式或关联。 这可能会导致幻觉输出,其中人工智能会根据错误或误解的信息生成响应。 即使您可能没有注意到,这种情况也经常发生。

人工智能幻觉可以以多种形式表现出来,每种形式都强调人工智能系统中的不同挑战和复杂性。 以下是一些常见的人工智能幻觉类型:

- 句子AI幻觉:

- 在这种情况下,人工智能模型生成的句子与同一上下文中的先前陈述相冲突。 例如:

- 提示:“用三个词的句子描述一个人物的旅程。”

- 输出:“她走得很慢。 突然,她跑了。 然后,她就走了。”

- 在这种情况下,人工智能模型生成的句子与同一上下文中的先前陈述相冲突。 例如:

最后一句与之前的跑步动作相矛盾,破坏了叙述的连贯性。

- 提示AI幻觉:

- 当 AI 生成的响应与预期的提示或查询发生冲突时,就会发生这种类型。 例如:

- 提示:“写一个巧克力蛋糕的食谱。”

- 输出:“这是一首关于星星的诗。”

- 当 AI 生成的响应与预期的提示或查询发生冲突时,就会发生这种类型。 例如:

生成的内容不符合烹饪相关的提示,表明未能掌握上下文。

- 真实的人工智能幻觉:

- 当人工智能模型将虚假信息呈现为准确时,就会出现事实矛盾。 例如:

- 提示:“列出元素周期表中的三种元素。”

- 输出:“氢、氧、碳酸盐。”

- 当人工智能模型将虚假信息呈现为准确时,就会出现事实矛盾。 例如:

“碳酸盐”不是一个元素,导致响应中出现错误信息。

- 不相关或随机的人工智能幻觉:

- 这些幻觉涉及生成与输入无关的无关或无意义的信息。 例如:

- 提示:“描述一下在海滩的一天。”

- 输出:“沙子很温暖。 海鸥唱着爵士乐。 企鹅跳芭蕾舞。”

- 这些幻觉涉及生成与输入无关的无关或无意义的信息。 例如:

提及企鹅和芭蕾舞与典型的海滩场景并不相符,表明所生成的叙述缺乏连贯性。

这些类型的幻觉凸显了人工智能系统在准确理解和背景化信息方面面临的挑战。 解决这些问题需要提高训练数据的质量,完善语言模型对上下文的理解,并实施强大的验证机制以确保人工智能生成的输出的连贯性和准确性。

人工智能幻觉可能会产生严重后果,特别是在人工智能用于做出重要决策的应用中,例如医疗诊断或金融交易。 如果人工智能系统在这些情况下产生幻觉并提供不准确的信息,则可能会导致有害的结果。

对于人工智能幻觉你能做什么?

减少人工智能幻觉涉及几个关键步骤,以使人工智能系统更加准确和可靠:

首先,使用高质量的数据来训练人工智能至关重要。 这意味着确保人工智能学习的信息多样化、准确且没有偏见。

简化人工智能模型也有帮助。 复杂的模型有时会导致意想不到的错误。 通过保持简单,我们可以减少出错的机会。

清晰易懂的说明也很重要。 当人工智能获得清晰的输入时,它就不太可能感到困惑和犯错误。

定期测试有助于及早发现任何错误。 通过检查人工智能的表现如何,我们可以解决任何问题并进行改进。

在人工智能系统中添加检查也会有所帮助。 这些检查会查找错误并在错误引起问题之前进行纠正。

最重要的是,人类的监督至关重要。 让人们仔细检查人工智能生成的输出可确保准确性和可靠性。

最后,训练人工智能防御攻击可以使其更具弹性。 这有助于人工智能识别并处理操纵或欺骗它的企图。

通过遵循这些步骤,我们可以使人工智能系统更加可靠,并减少出现幻觉输出的机会。

如何让人工智能产生幻觉?

如果你想利用这个缺陷并获得一些乐趣,你可以做一些事情:

- 更改输入:您可以调整提供给人工智能的信息。 即使很小的变化也会使它产生奇怪或不正确的答案。

- 欺骗模型:制作特殊的输入,欺骗人工智能给出错误的答案。 这些技巧利用模型的弱点来创建幻觉的输出。

- 数据混乱:通过在人工智能的训练数据或提示中添加误导性或不正确的信息,你可以让它学到错误的东西并产生幻觉。

- 调整模型:修改人工智能的设置或结构以引入缺陷或偏见。 这些变化可能会导致它生成奇怪或无意义的输出。

- 提供令人困惑的输入:向 AI 提供不明确或矛盾的指令。 这可能会让人工智能感到困惑,并导致错误或无意义的响应。

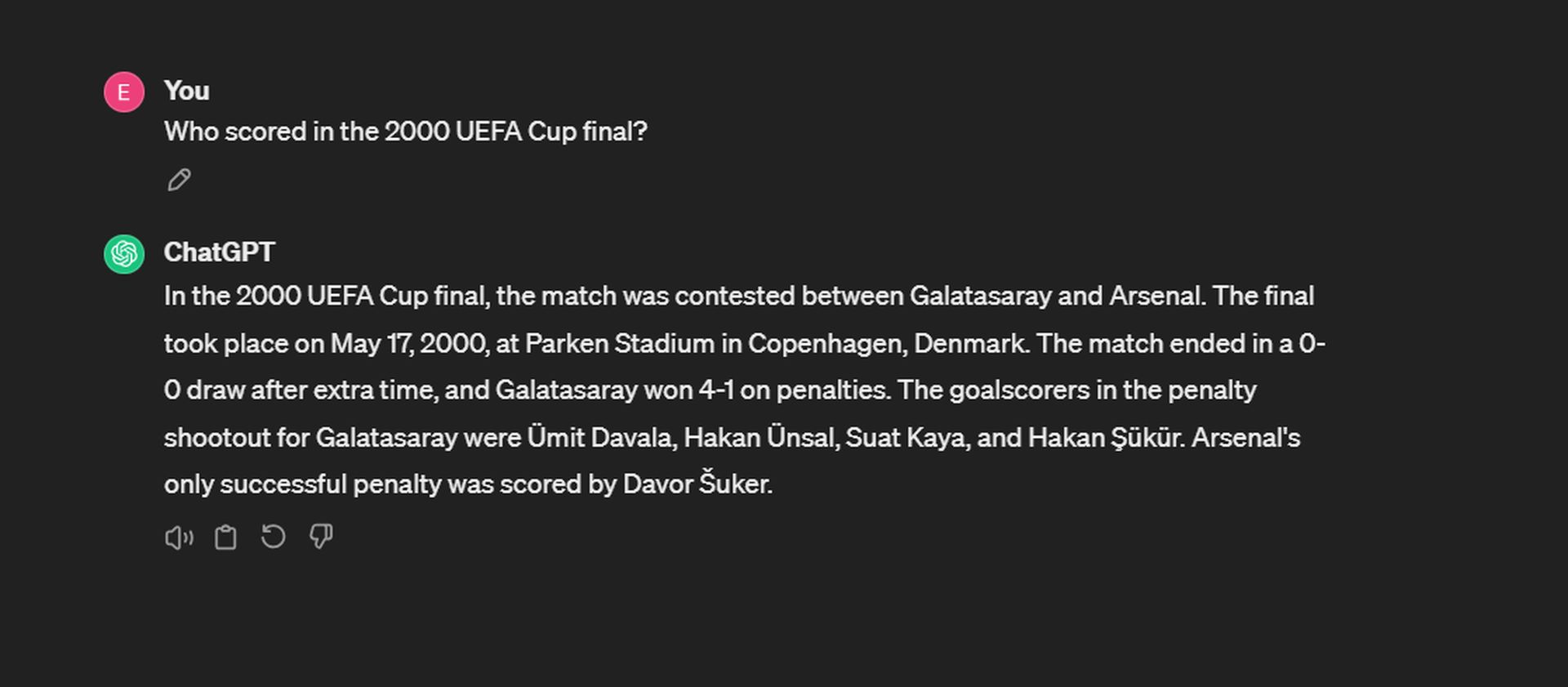

或者您也可以直接提问并试试运气! 例如,我们尝试让 ChatGPT 产生幻觉:

虽然 ChatGPT 能够准确记住日期和得分,但它在回忆点球大战的得分手方面却表现不佳。 加拉塔萨雷队的进球由埃尔古恩·彭贝、哈坎·苏克、于米特·达瓦拉和波佩斯库打进。 在阿森纳方面,雷·帕洛尔是唯一成功点球的球员。

虽然让人工智能产生幻觉可以帮助我们了解其局限性,但负责任地使用这些知识并确保人工智能系统保持可靠和值得信赖也很重要。

GPT 4 产生幻觉的几率会减少吗?

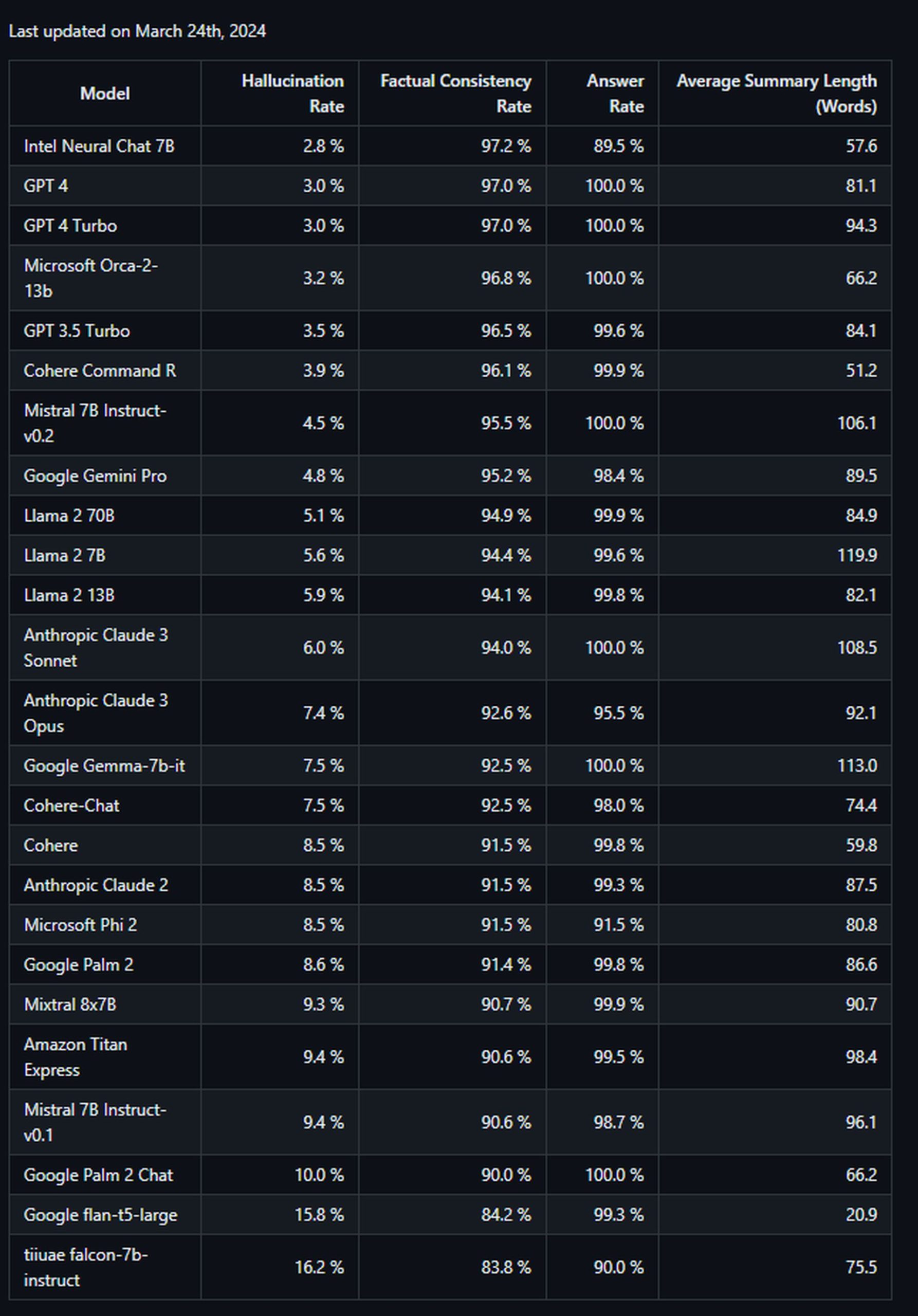

是的,根据 评估 由帕洛阿尔托的公司使用他们的幻觉评估模型进行, GPT-4 与其他大型语言模型相比,除了 Intel Neural Chat 7B (97.2%) 之外,它的幻觉率较低。 GPT-4 的准确率为 97%,幻觉率为 3%,在总结文档时表现出较高的准确度和相对较低的引入幻觉的倾向。 这表明与评估中测试的其他模型相比,GPT-4 不太容易生成不正确或无意义的输出。

另一方面,效率最低的模型很少来自谷歌。 谷歌掌上电脑2 表现出90%的准确率和10%的幻觉率。 其聊天改进版本的表现更差,准确率仅为 84.2%,幻觉得分为排行榜上所有模型中最高的,达到 16.2%。 这是列表:

总之,人工智能幻觉是人工智能系统所犯的错误,由于训练数据或处理信息的方式存在缺陷,它们产生了无意义或不正确的输出。 这是人工智能的一个令人着迷但又具有挑战性的方面,研究人员和开发人员正在努力解决这一问题。