大型语言模型 (LLM) 是经过大量文本数据训练的计算机程序。 这使他们能够生成文本、翻译语言、编写不同类型的创意内容,并以翔实的方式回答您的问题。

然而,LLM 也有其局限性:它们一次只能处理特定数量的信息。 这就像与一个只能记住你说的最后几句话的人交谈一样。

谷歌研究人员开发了一种新技术,称为 无限注意力 这使得法学硕士能够在对话中掌握并使用更多信息。 这意味着您可以为您的问题提供更多背景信息并获得更全面的答案。 想象一下,要求法学硕士总结一个复杂的历史事件,或者根据您提供的详细背景故事编写一个虚构的故事。 有了无限注意力,这些类型的交互就成为可能。

无限注意力是如何运作的?

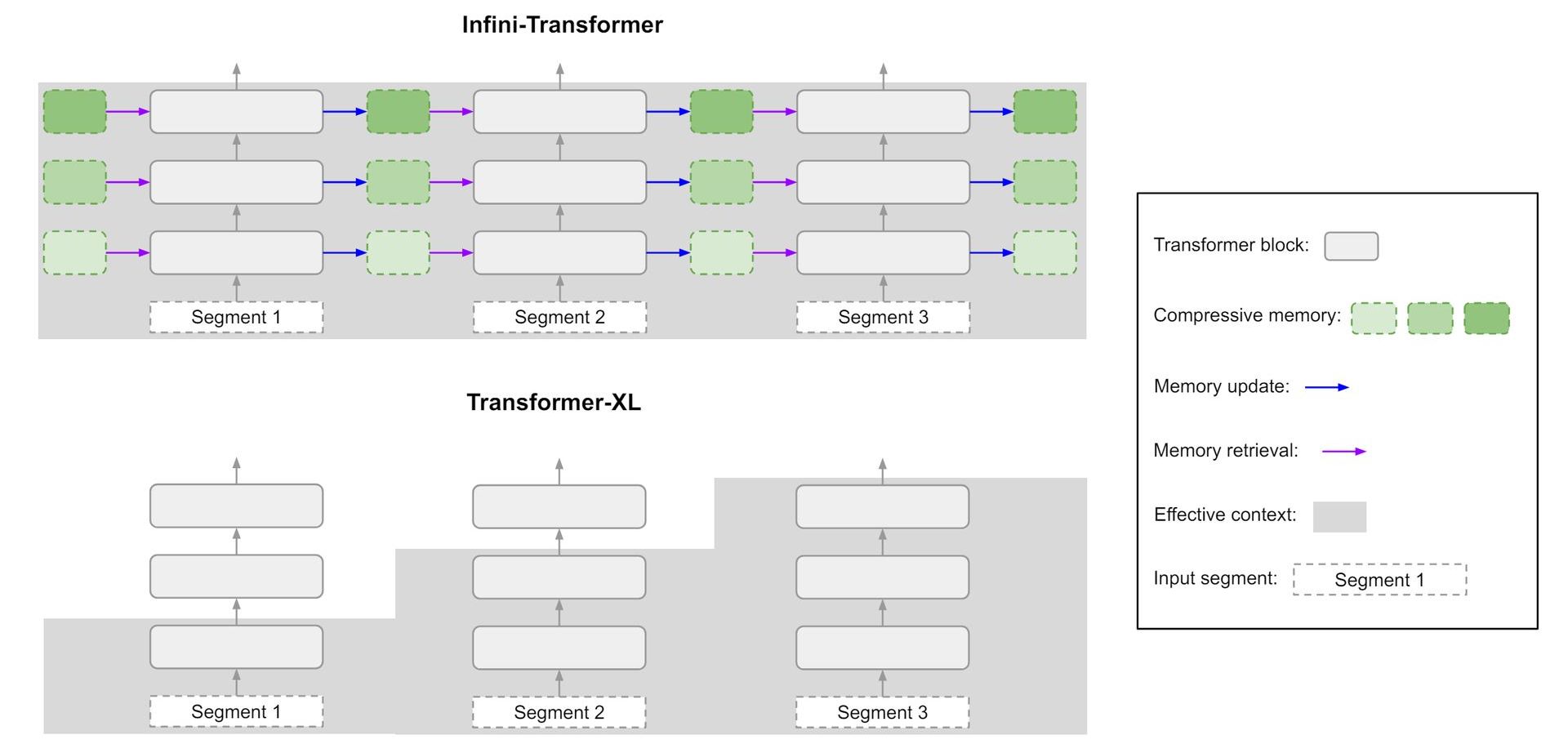

传统的 LLM 以固定大小的块处理信息,重点关注当前块并丢弃或压缩较旧的块。 这种方法阻碍了他们捕获远程依赖关系并保留对于需要更广泛理解的任务至关重要的上下文信息的能力。

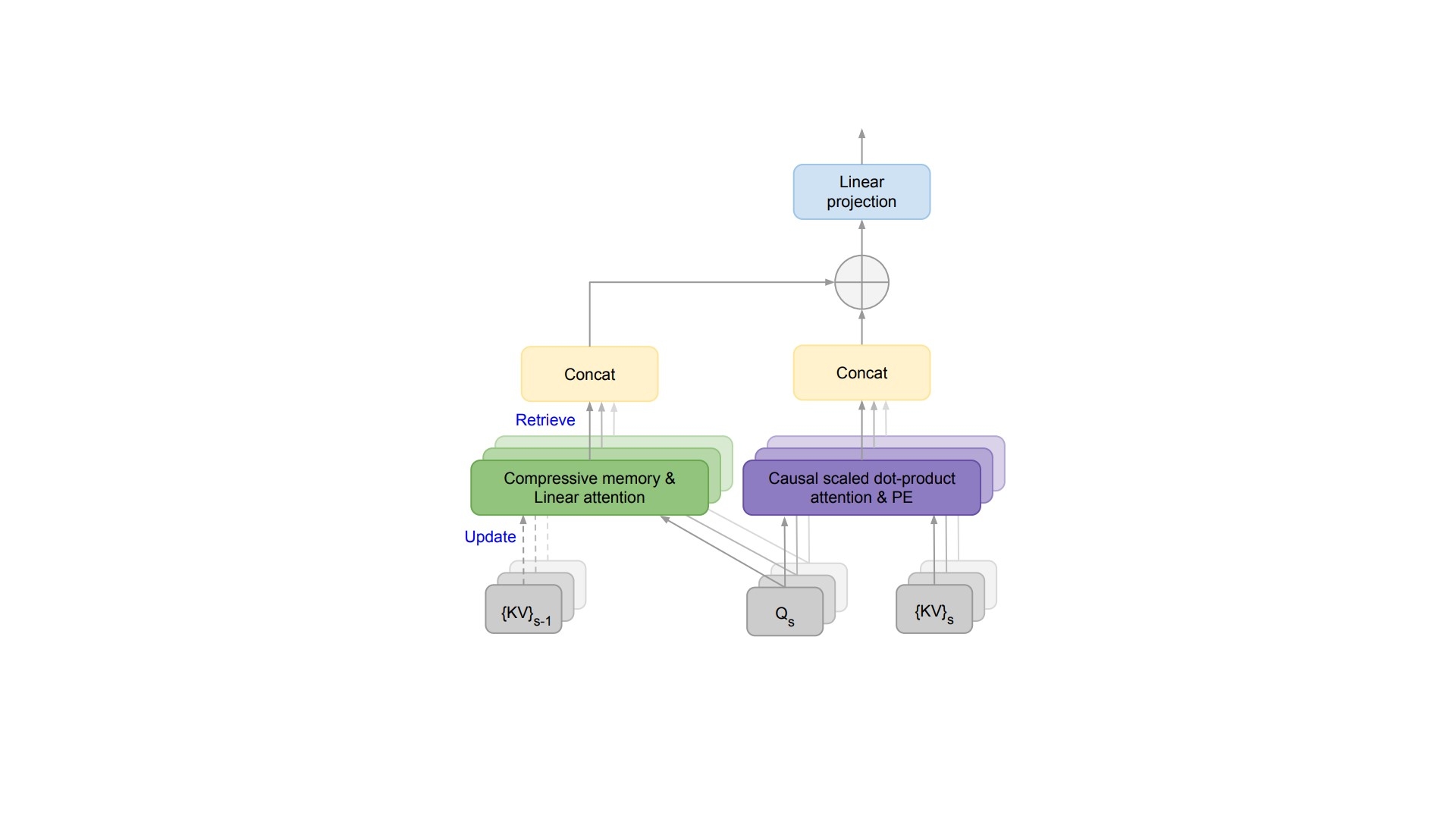

无限注意力通过使法学硕士能够有效利用过去交互中的信息来解决这一限制。 它通过结合现有的注意力机制和高效的内存管理技术来实现这一点。

以下是其核心功能的细分:

分块和注意力

与传统的 LLM 类似,Infini-attention 首先将输入序列划分为更小的片段。 在处理过程中,模型采用注意机制来识别每个块中与当前任务最相关的部分。 这种注意力机制为块中的不同元素分配权重,表明它们对当前上下文的重要性。

记忆创造

与丢弃或严重压缩过去块的传统模型不同,无限注意力利用注意力权重来创建压缩的内存表示。 这种压缩表示对注意力机制认为重要的信息进行优先级排序,捕获已处理块的本质。 本质上,它提取已处理信息的重要摘要。

内存存储

然后,这些压缩的内存表示被存储在 LLM 内的专用内存空间中。 该内存空间专为高效检索和利用而设计。 虽然具体的实现细节尚未公开,但它可能涉及键值存储或分层结构等技术,以促进基于相关性的高效访问。

情境整合

在处理新信息时,LLM 不仅仅依赖于当前的块。 它现在可以从专用存储空间检索相关的压缩内存。 该检索过程利用与压缩记忆相关的注意力权重,确保检索到的信息与当前上下文保持一致。 通过整合当前块和相关过去上下文的信息,法学硕士可以更全面地了解整个输入序列。

因此,无限注意力使法学硕士能够在交互过程中考虑更广泛的信息。 这种增强的情境意识可以带来几个潜在的好处:

- 通过整合更广泛的相关信息, 法学硕士可以生成更准确、信息更丰富的回复 到复杂的查询。

- 无限注意力允许 法学硕士通过记住过去的元素来遵循复杂的论点 的交互作用。 这使他们能够执行需要逻辑推理和推理的任务。

- 通过接触更广阔的背景, 法学硕士可以生成更具创意和连贯的文本格式 例如根据具体情况量身定制的脚本、诗歌或电子邮件。

越大并不总是越好

想象一下您正在与朋友交谈。 他们首先提到他们刚刚看过的一部电影,然后开始详细解释他们正在尝试的新食谱,然后再回到电影来分析特定的情节点。 虽然这听起来像是一次正常的对话,但对于人工智能聊天机器人来说,这可能会造成混乱。

最近的进步(例如谷歌的 Infini-attention)使聊天机器人能够在交互过程中保留并利用更多信息。 这在纸面上听起来很棒——更多的背景意味着人工智能可以更好地理解我们,对吧? 嗯,不完全是。 就像那位无法直奔主题的朋友一样, 让人工智能超载上下文可能会带来一些令人惊讶的缺点。

面对现实吧, 信息过载是一个真正的问题,人工智能聊天机器人也不能幸免。 让他们陷入不相关的细节会让他们很难识别关键点并做出连贯的回应。 可以把它想象成试图在一本充满杂货清单和餐厅评论的烹饪书中找到特定的食谱——效率不高。

还有 需要考虑的计算成本。 存储和处理大量上下文需要强大的力量。 这会减慢聊天机器人的速度并使其不太用户友好。 想象一下,由于人工智能正忙于理清一堆不相关的信息,所以需要等待几分钟才能得到答复。 这并不完全是我们所希望的无缝交互。

那么,甜蜜点在哪里?

事实是,理想的上下文大小 完全取决于情况。 对于回答问题或创意写作等复杂任务,更广泛的背景可能会有所帮助。 但对于更简单的交互来说,它可能会很混乱。

关键是找到平衡点——为人工智能提供足够的背景信息来理解情况,但又不能太多,以免它迷失在杂草中。 可以把它想象成为戏剧设置场景——你想要提供足够的细节来设置舞台,但又不想让观众陷入不必要的背景故事。

随着人工智能聊天机器人的不断发展,理解上下文和清晰度之间的微妙之舞将至关重要。 通过取得适当的平衡,我们可以确保这些人工智能伴侣不仅仅是行走的百科全书,而且 聪明且有吸引力的对话伙伴。

特色图片来源: 手绘