NVIDIA NIM 通过提供将生成式 AI 嵌入应用程序的标准化方式来提高开发人员的工作效率。

什么是 NVIDIA NIM?

NVIDIA NIM(NVIDIA 推理微服务)是一个旨在增强生成式 AI 模型部署和集成的平台。它提供了一种将生成式 AI 嵌入到各种应用程序中的标准化方法,从而显著提高开发人员的生产力并优化基础设施投资。

NVIDIA NIM 的功能

NVIDIA NIM 的主要特性和功能包括:

- 精简部署:NVIDIA NIM 容器预先构建了 NVIDIA CUDA、NVIDIA Triton 推理服务器和 NVIDIA TensorRT-LLM 等基本软件,可实现高效的 GPU 加速推理。

- 支持多种模型:该平台支持多种 AI 模型,包括 Databricks DBRX、Google 的 Gemma、Meta Llama 3、Microsoft Phi-3 和 Mistral Large,使它们可以作为端点在 ai.nvidia.com 上访问。

- 与流行平台集成:NVIDIA NIM 可以与 Hugging Face 等平台集成,让开发人员能够使用 NVIDIA 支持的推理端点轻松访问和运行模型。

- 广泛的生态系统支持:它得到了众多平台提供商(Canonical、Red Hat、Nutanix、VMware)的支持,并集成到主要的云平台(Amazon Web Services、Google Cloud、Azure、Oracle Cloud Infrastructure)中。

- 行业采用:富士康、和硕、Amdocs 和 ServiceNow 等各行各业的领先公司正在利用 NVIDIA NIM 开发 AI 工厂、智慧城市、电动汽车、客户计费和多模式 AI 模型等应用。

- 开发人员访问:NVIDIA 开发者计划的成员可以免费访问 NIM 进行研究、开发和测试,促进 AI 应用的实验和创新。

几乎 包括 Cadence、Cloudera、Cohesity、DataStax、NetApp、Scale AI 和 Synopsys 在内的 200 家技术合作伙伴正在采用 NVIDIA NIM,以加速针对特定应用(如副驾驶、编码助手和数字人类化身)量身定制的生成式 AI 部署。 此外, Hugging Face 推出 NVIDIA NIM,从 Meta Llama 3 开始。

NVIDIA 创始人兼首席执行官黄仁勋强调了 NVIDIA NIM 的可及性和重要性,他表示: “每家企业都希望将生成式 AI 融入其运营,但并非所有企业都拥有一支专门的 AI 研究团队。”NVIDIA NIM 使几乎所有组织都能利用生成式 AI。

企业可以通过 NVIDIA AI Enterprise 软件平台使用 NVIDIA NIM 实施 AI 应用程序。从下个月开始, NVIDIA 开发者计划成员可以免费使用 NVIDIA NIM 来研究、开发和测试他们所选的基础设施。

NVIDIA NIM 容器旨在简化 GPU 加速推理的模型部署,并配备了 NVIDIA CUDA 软件、NVIDIA Triton 推理服务器和 NVIDIA TensorRT-LLM 软件。 超过 40 个模型(例如 Databricks DBRX、Google 的 Gemma、Meta Llama 3、Microsoft Phi-3 和 Mistral Large)可作为 NIM 端点在 ai.nvidia.com 上访问。

通过 拥抱Face AI平台,开发者可轻松为Meta Llama 3模型接入NVIDIA NIM微服务.这种整合使他们能够 使用由 NVIDIA GPU 提供支持的 Hugging Face 推理端点高效运行 Llama 3 NIM。

众多平台提供商,包括 Canonical、Red Hat、Nutanix 和 VMware, 在开源 KServe 和企业解决方案上均支持 NVIDIA NIM。AI 应用公司如 Hippocratic AI、Glean、Kinetica 和 Redis 利用 NIM 推动生成式 AI 推理。领先的 AI 工具和 MLOps 合作伙伴,例如 Amazon SageMaker、Microsoft Azure AI、Dataiku、DataRobot 等, 已将 NIM 集成到他们的平台中,使开发人员能够创建和部署具有优化推理能力的特定领域生成式 AI 应用程序。

获取免费 NVIDIA Game Pass 立即提供

全球系统集成商和服务交付合作伙伴,包括 埃森哲、德勤、印孚瑟斯、Latentview、Quantiphi、SoftServe、TCS 和 Wipro, 已在 NIM 方面积累了专业知识,可帮助企业快速开发和实施生产 AI 战略。企业可以在来自以下制造商的 NVIDIA 认证系统上运行支持 NIM 的应用程序: 思科、戴尔科技、惠普企业、联想和超微, 以及来自的服务器 ASRock Rack、ASUS、GIGABYTE、Ingrasys、Inventec、Pegatron、QCT、Wistron 和 Wiwynn。此外,NIM 微服务已集成到主要云平台中,包括 亚马逊网络服务, 谷歌云, Azure以及 Oracle 云基础设施。

领先的公司正在利用 NIM 实现各个行业的多样化应用。 富士康 使用 NIM 进行人工智能工厂、智能城市和电动汽车领域特定 LLM 的学习。 和硕 利用 NIM 开展 TaME 项目,推动本地各个行业的法学硕士 (LLM) 发展。 安多克斯 使用 NIM 为客户计费 LLM,显著降低成本和延迟,同时提高准确性。 立即服务 在其 Now AI 多模式模型中集成 NIM 微服务,为客户提供快速且可扩展的 LLM 开发和部署。

如何试用 NVIDIA NIM?

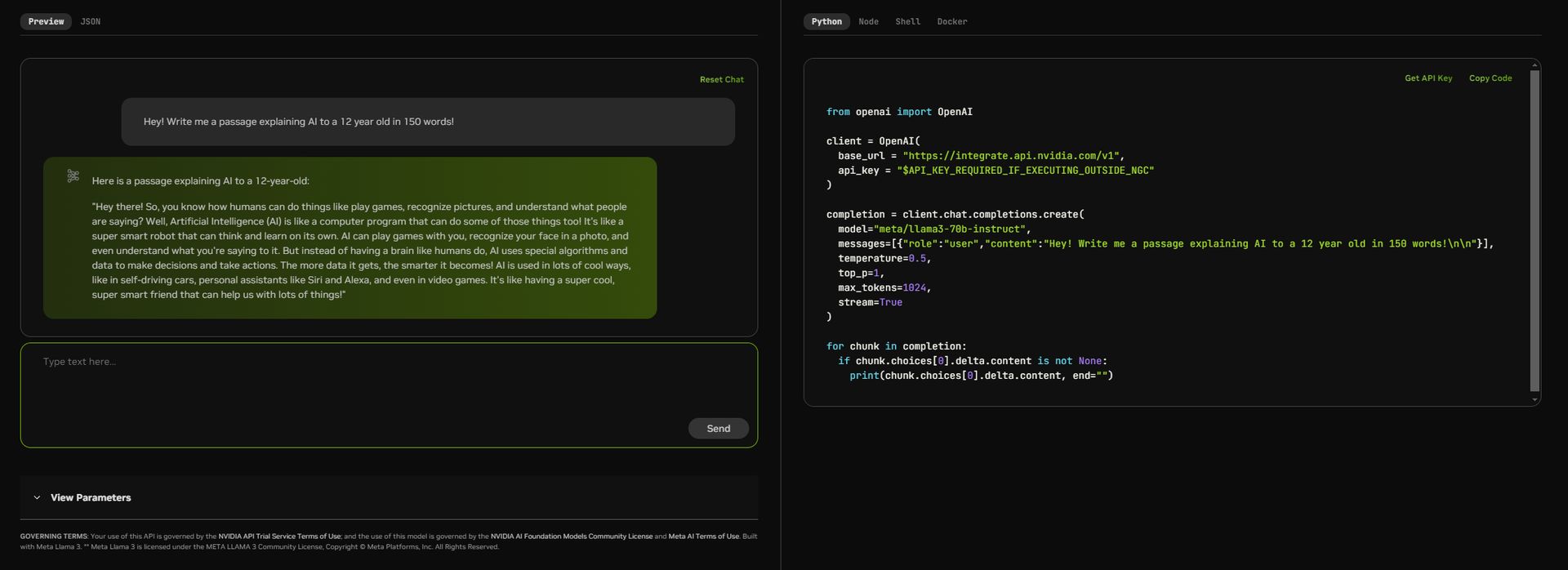

使用 NVIDIA NIM 部署和试验生成式 AI 模型非常简单。以下是帮助您入门的分步指南:

- 访问 NVIDIA NIM 网站:

- 打开你的网络浏览器并导航至 ai.nvidia.com。

- 开始探索:

- 在主页上,你会看到“立即尝试”选项。单击此按钮即可开始。

- 选择型号:

- 您将被引导至一个展示各种模型的页面。在本示例中,请选择 Meta 的“llama3-70b-instruct”模型。此模型专为语言生成任务而设计。

- 部署模型:

- 选择模型后,您将看到一个界面,其中有部署模型的选项。单击“Run Anywhere”继续。

- 使用推理端点:

- 部署后,您将可以访问由 NVIDIA GPU 提供支持的 Hugging Face 推理端点。这使您能够高效运行模型。

- 输入您的提示:

- 在界面中,你会看到一个文本框,你可以在其中输入提示。例如,你可以输入“嘿!用 150 个字写一篇文章向 12 岁的孩子解释人工智能!”

- 执行提示:

- 点击“发送”按钮执行提示。模型将根据您的输入生成响应。

- 查看输出:

- 生成的响应将显示在输出部分。您可以查看模型生成的文本并根据需要使用它。

- 探索其他功能:

- NVIDIA NIM 还允许您调整参数并查看 JSON 代码以实现更高级的用法。探索这些选项以进一步自定义输出。

- 开发人员免费访问:

- 如果您是开发人员,您可以通过 NVIDIA 开发人员计划注册,免费访问 NVIDIA NIM 微服务以进行研究、开发和测试。

交互示例

以下是使用该模型的一个示例:

- 迅速的:“嘿!用 150 个字写一篇文章向 12 岁的孩子解释人工智能!”

- 回复: “嘿!你知道人类如何玩游戏、识别图片和理解人们所说的话吗?人工智能 (AI) 就像一个可以做这些事情的计算机程序!它就像一个可以独立思考和学习的超级智能机器人。AI 可以和你一起玩游戏、在照片中识别你的脸,甚至理解你对它说的话。但 AI 不像人类那样拥有大脑,而是使用特殊算法和数据来做出决策并采取行动。它获得的数据越多,它就越聪明!AI 有很多很酷的用途,比如自动驾驶汽车、Siri 和 Alexa 等个人助理,甚至视频游戏。这就像有一个超级酷、超级聪明的朋友可以帮助我们做很多事情!”

特色图片来源: 凯雷姆·葛兰/Midjourney