Colossus 是伊隆·马斯克的团队开发的一款突破性的人工智能 (AI) 训练系统 xAI 公司. 这台超级计算机被马斯克描述为“全球最强大的人工智能训练系统”是 xAI 引领快速发展的人工智能领域战略的关键组成部分。

本周末, @xAI 团队将我们的 Colossus 100k H100 训练集群上线。从开始到结束,一共花了 122 天。

Colossus 是世界上最强大的 AI 训练系统。此外,它的规模将在几个月内翻倍至 20 万台(5 万台 H200)。

出色的…

— 伊隆·马斯克(@elonmusk) 2024 年 9 月 2 日

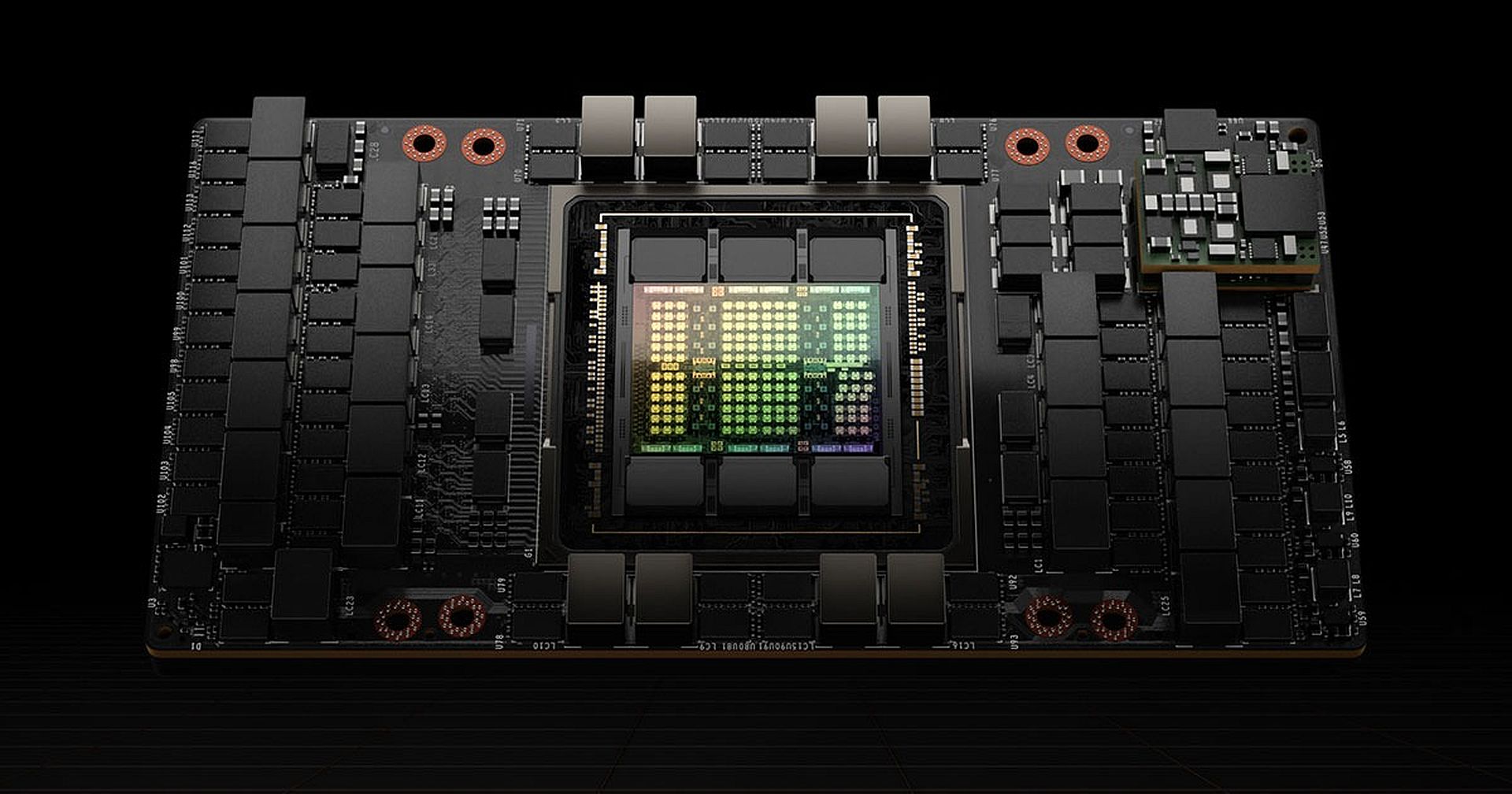

Nvidia 将为 Colossus 提供动力

Colossus 的核心是 100,000 NVIDIA H100 显卡。 这些 GPU(图形处理单元)专门设计用于处理 AI 训练的苛刻计算要求,以下是这些 GPU 如此重要的原因:

- 原始处理能力: 这 H100 是 Nvidia 的旗舰 AI 处理器,旨在加速 AI 模型的训练和推理,特别是基于深度学习和神经网络的模型。与上一代相比,H100 可以运行高达 速度快 30 倍。

- 变压器发动机:H100 的一个关键特性是其 Transformer Engine,这是一组专门针对运行基于 Transformer 神经网络架构的 AI 模型而优化的电路。该架构是一些最先进语言模型的支柱,例如 GPT-4 和 梅塔的骆驼 3.1 405BTransformer Engine 使这些 GPU 能够更有效地处理大规模模型,使其成为训练复杂 AI 系统的理想选择。

下一个级别:H200 加倍投入

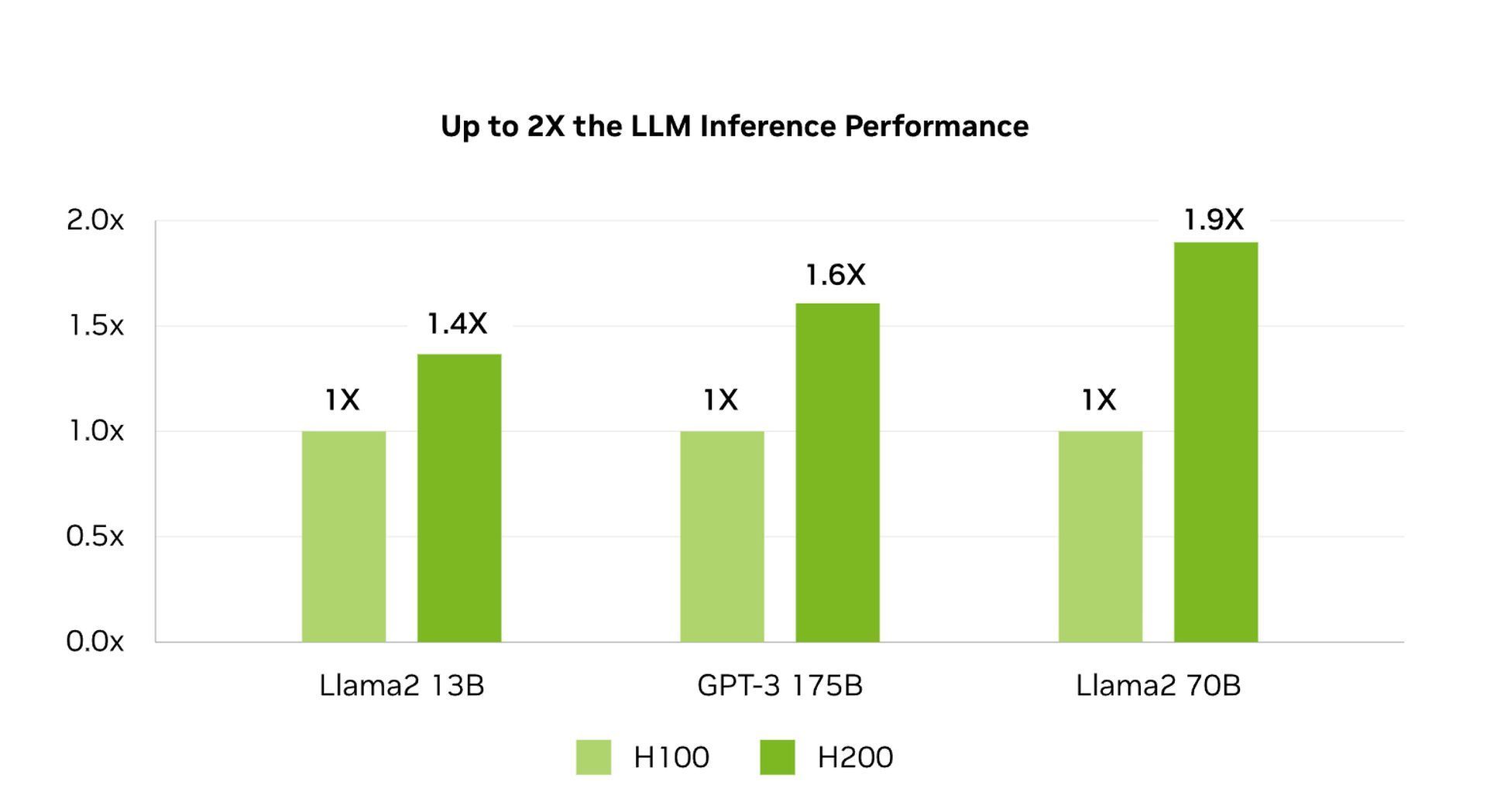

马斯克有雄心勃勃的计划进一步扩大 Colossus 的规模,目标是将系统的 GPU 数量增加一倍,以 20万 在不久的将来。此次扩建将包括 50,000 台 Nvidia 的 H200是 H100 的更强大的继任者。H200 提供了几项重大升级:

- HBM3e 内存:H200 使用高带宽内存 3e (HBM3e),速度比 H100 中使用的 HBM3 更快。这种类型的内存提高了内存和芯片逻辑电路之间数据传输的速度。对于在处理和内存之间不断移动大量数据的 AI 模型来说,这种速度至关重要。

- 增加内存容量:H200 的板载内存容量几乎增加了一倍, 141千兆字节。这使得 GPU 能够将更多 AI 模型数据存储在更靠近其逻辑电路的位置,从而减少从较慢存储源获取数据的需要。结果是处理时间更快,模型训练更高效。

Colossus 在人工智能训练中的作用

Colossus 专为训练而设计 大型语言模型 (LLM),这是先进人工智能应用的基础。

Colossus 中 GPU 的数量之多,使得 xAI 能够以其他系统无法比拟的规模和速度训练 AI 模型。例如,xAI 目前的旗舰 LLM, Grok-2, 在 15,000 个 GPU 上进行了训练。现在有 100,000 个 GPU 可用,xAI 可以训练更大、更复杂的模型,从而有可能显著提高 AI 能力。

H100 和 H200 GPU 的先进架构确保模型训练速度更快,精度更高。高内存容量和快速数据传输能力意味着即使是最复杂的 AI 模型也可以更高效地进行训练,从而实现更好的性能和准确性。

下一步是什么?

Colossus 不仅仅是一项技术成就,更是 xAI 主宰 AI 行业的战略资产。通过构建世界上最强大的 AI 训练系统,xAI 成为开发尖端 AI 模型的领导者。该系统使 xAI 比其他 AI 公司更具竞争优势,包括马斯克目前参与的 OpenAI 法律冲突 和。

此外,Colossus 的建设也体现了马斯克对 AI 的更广阔愿景。通过将资源从特斯拉转移到 xAI,包括重新规划价值超过 5 亿美元的 12,000 个 H100 GPU,马斯克展示了他对 AI 的承诺,将其作为其商业帝国的核心重点。

他能成功吗?我们只能等待答案了!