微软找到了与之竞争的方法 英伟达,Maia 100 AI加速器。这款新芯片代表了挑战 NVIDIA 的主导地位 通过提供专为高性能云计算而设计的先进功能,微软在 AI 硬件领域取得了重大进展。借助 Maia 100,微软旨在为管理大规模 AI 工作负载提供更具成本效益和效率的解决方案。

目前有关微软 Maia 100 的所有信息

微软的 Maia 100 是一款功能强大的新型 AI 加速器,旨在处理云端的大型 AI 任务。 2024 年热门芯片, 这款芯片在提高 AI 基础设施的成本效益方面迈出了一大步,具体方法如下:

芯片设计与技术

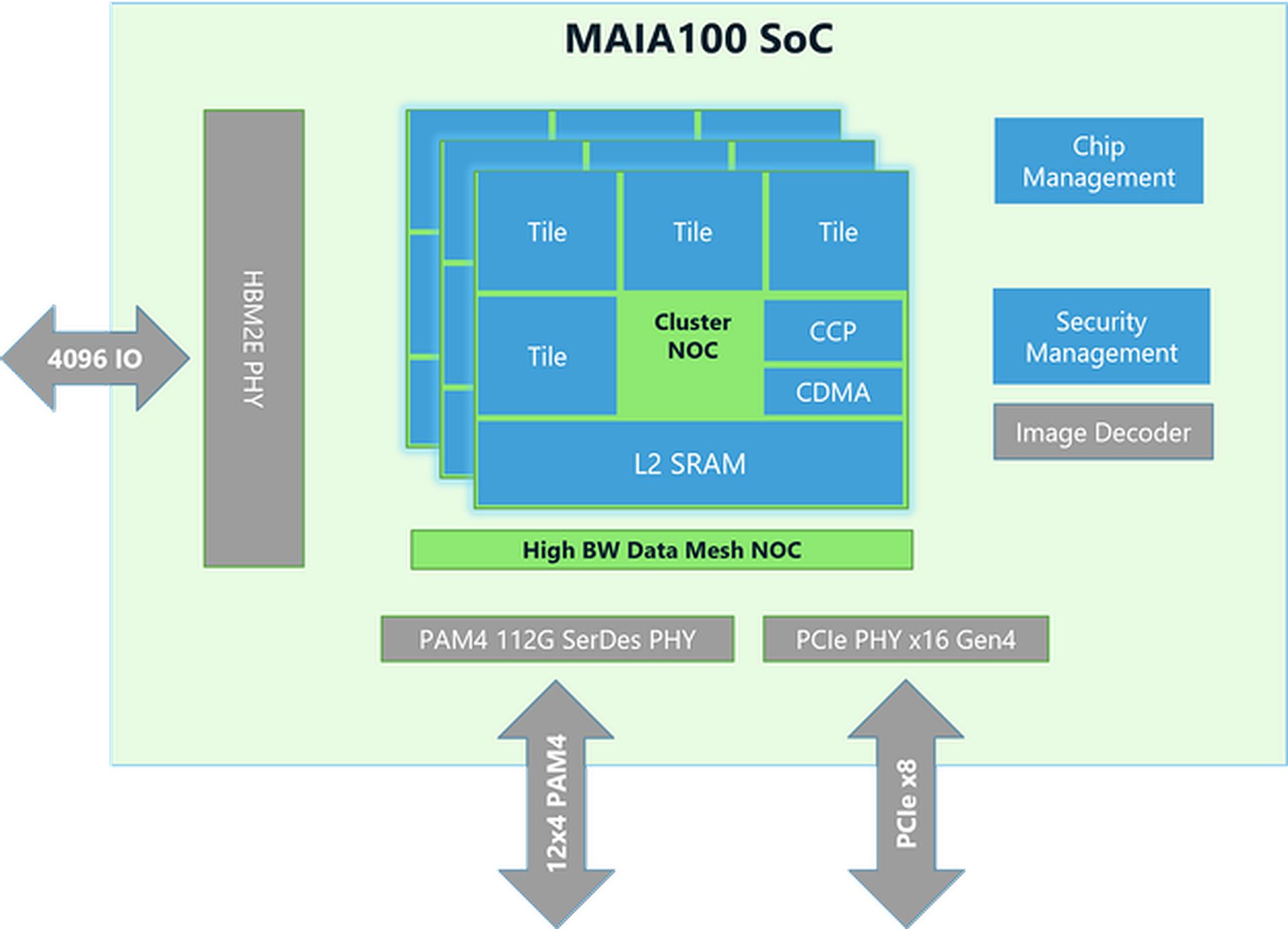

- 尺寸和制造:Maia 100芯片尺寸约为820mm²,采用台积电先进的N5工艺制造,采用COWOS-S技术,可有效将芯片与其他组件集成。

- 内存和带宽:该芯片拥有大量内存,可以处理大量数据。它拥有大型片上 SRAM(一种快速内存)和四个 HBM2E 内存芯片。它们共同提供每秒 1.8 TB 的数据传输速度和 64 GB 的内存容量。这种设置对于快速处理大型 AI 数据集至关重要。

性能和电源效率

- 用电量:Maia 100 可处理高达 700 瓦的功率,但为了提高效率,设置为使用 500 瓦。这样,它既能发挥良好性能,又能控制功耗。

- 张量单元:该芯片包含一个高速张量单元,用于处理复杂的 AI 任务,例如训练模型和进行预测。它可以处理不同类型的数据,包括微软于 2023 年推出的一种名为 MX 的新格式。该单元旨在高效地同时处理许多计算。

- 矢量处理器:Maia 100 具有矢量处理器,支持各种数据类型,例如 FP32(32 位浮点)和 BF16(16 位浮点)。这有助于执行各种机器学习任务。

- DMA 引擎:直接内存访问 (DMA) 引擎有助于快速移动数据,并支持拆分张量(数据块)的不同方式,从而提高效率。

数据处理和效率

- 数据存储与压缩:Maia 100 使用低精度数据存储和压缩引擎来减少需要移动的数据量。这有助于更有效地处理大型 AI 任务。

- 便笺簿:它具有由软件管理的大型 L1 和 L2 暂存器(临时存储区域),以确保高效使用数据并节省电力。

- 联网:该芯片支持高速以太网连接,在某些方面可处理高达 4800 Gbps 的数据,在其他方面可处理 1200 Gbps 的数据。这种自定义网络协议可确保可靠、快速的数据传输,并且还通过 AES-GCM 加密确保安全。

软件工具和集成

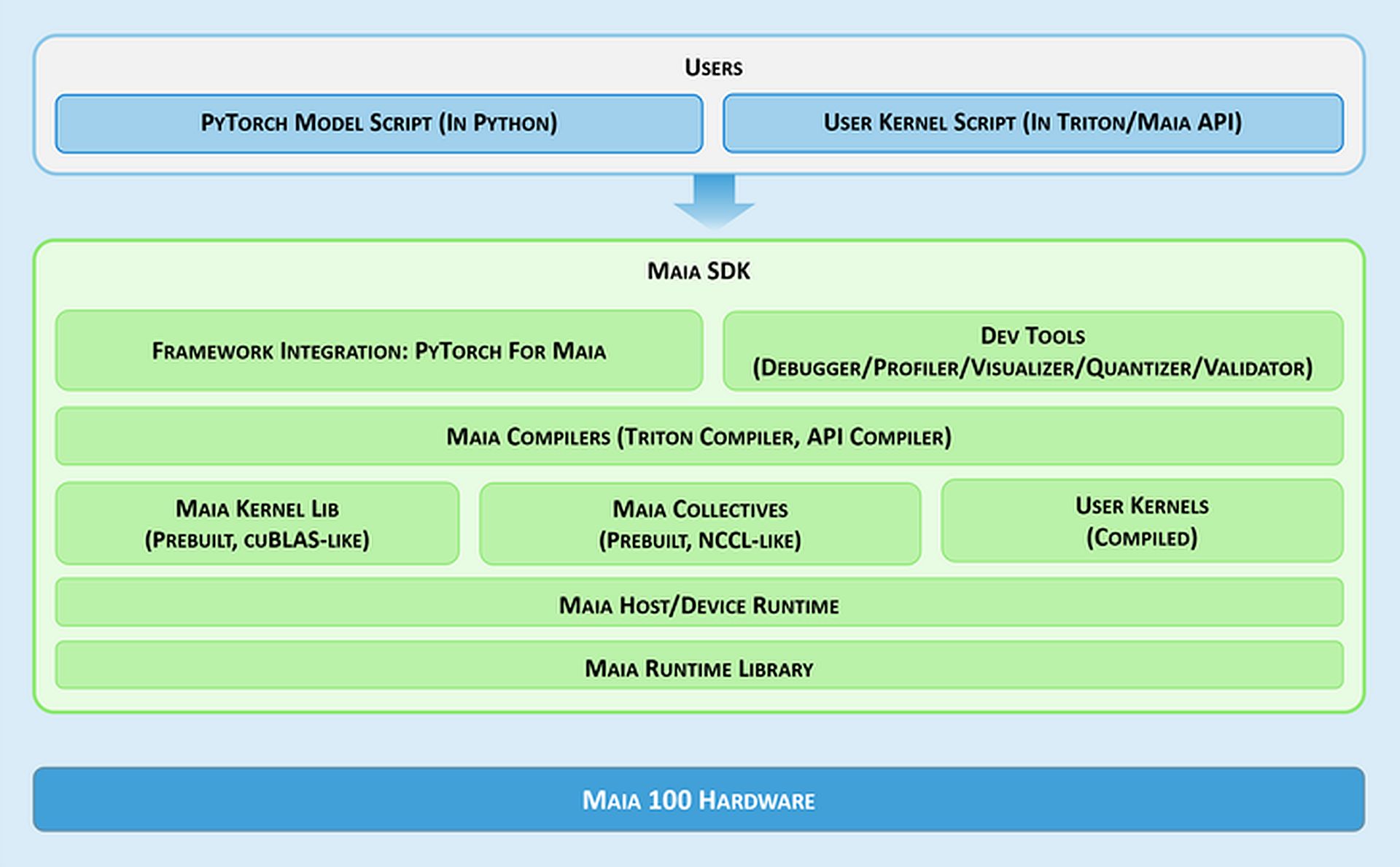

- Maia 软件开发工具包:微软提供了一套名为 Maia SDK 的工具,以便更轻松地使用 Maia 100。这些工具包括:

- 框架集成:一个支持 Eager 模式(用于快速开发)和图形模式(以获得更好的性能)的 PyTorch 后端。

- 开发人员工具:用于调试、性能调整和验证模型的工具,有助于提高AI任务的效率。

- 编译器:Maia 支持两种编程模型:Triton(一种易于使用的深度学习语言)和 Maia API(一种高性能的自定义模型)。

- 内核和集合库:为机器学习提供优化的计算和通信内核,并提供创建自定义内核的选项。

- 主机/设备运行时:管理内存分配、运行程序、调度任务和设备管理。

编程模型和数据处理

- 异步编程:Maia 支持使用信号量进行异步编程,这有助于将计算与数据传输重叠以提高效率。

- 编程模型:开发人员可以选择:

- 海卫一:一种适用于 GPU 和 Maia 的简单深度学习计划工具。它可自动处理内存和同步。

- Maia API:针对需要对性能进行精细控制、需要更多代码和管理的用户提供更详细的编程模型。

- 数据流优化:Maia 使用基于 Gather 的方法进行矩阵乘法 (GEMM),而不是传统的 All-Reduce 方法。通过直接在 SRAM(快速内存)中组合结果,可以加快处理速度,从而减少延迟并提高性能。

- SRAM 使用情况:该芯片使用 SRAM 来临时存储数据和结果,从而减少了对较慢内存访问的需求并提高了整体性能。

灵活性和可移植性

Maia 100 只需进行少量更改即可运行 PyTorch 模型。PyTorch 后端支持开发(eager 模式)和高性能(图形模式),因此可以轻松地在不同的硬件设置之间移动模型。

需要回顾一下 Maia 100 的规格吗?

| 规格 | 细节 |

| 芯片尺寸 | ~820平方毫米 |

| 制造技术 | 采用 COWOS-S 中介层的台积电 N5 工艺 |

| 片上 SRAM | 大容量,快速访问数据 |

| 记忆 | 64 GB HBM2E(高带宽内存) |

| 总带宽 | 每秒 1.8 TB |

| 热设计功率(TDP) | 最高支持 700W,预配置 500W |

| 张量单元 | 高速,支持MX格式,16xRx16 |

| 矢量处理器 | 定制超标量引擎,支持FP32和BF16 |

| DMA 引擎 | 支持各种张量分片方案 |

| 数据压缩 | 包括提高效率的压缩引擎 |

| 以太网带宽 | 高达 4800 Gbps 全收集,1200 Gbps 全到全 |

| 网络协议 | 自定义 RoCE 类 AES-GCM 加密 |

| 编程模型 | Triton(领域特定语言)、Maia API(自定义模型) |

| 便笺簿 | 大型 L1 和 L2,软件管理 |

| SRAM 使用情况 | 用于缓冲激活和结果 |

| 软件开发工具包 | 包括 PyTorch 后端、调试工具、编译器和运行时管理 |

| 数据流优化 | 基于聚集的矩阵乘法 (GEMM) |

就这些!总而言之,微软的 Maia 100 AI 加速器将自己定位为 NVIDIA 在 AI 硬件市场上的直接竞争对手。凭借其先进的架构和性能特点,Maia 100 致力于为处理大规模 AI 任务提供可行的替代方案。

特色图片来源:微软