Reflection 70B 是由 AI 写作初创公司 HyperWrite 开发的大型语言模型 (LLM)。Reflection 70B 建立在 Meta 的 Llama 3.1-70B Instruct 之上,它不仅仅是一个开源模型。其创新的自我修正机制使其与众不同,使其能够超越许多现有模型并计算草莓中的“r”。

驱动 Reflection 70B 的技术很简单,但功能非常强大。

目前的法学硕士有产生幻觉的倾向,并且无法意识到自己何时产生了幻觉。

反射调整使法学硕士能够认识到自己的错误,然后在给出答案之前纠正它们。 pic.twitter.com/pW78iXSwwb

— 马特·舒默(@mattshumer_) 2024 年 9 月 5 日

等一下,为什么 Llama 3.1-70B 是 HyperWrite Reflection 70B 的基础?

Reflection 70B 建立在 Meta’s Llama 3.1-70B 指导,一个专为各种语言任务而设计的强大基础模型。Llama 模型以其可扩展性和高性能而闻名,但 Reflection 70B 更进一步,引入了一系列改进,特别是在推理和纠错方面。

原因何在?Llama 3.1-70B 基于开源框架,允许开发人员微调、调整和自定义模型。Llama 模型经过大量不同数据的训练,使其能够出色地完成语言生成、问答和总结等通用任务。

Reflection 70B 在此坚实的基础之上构建了更为复杂的错误检测系统,从而大大提高了其推理能力。

Meta 并不是 HyperWrite 的唯一助手;来认识一下 Glaive

Reflection 70 B 成功的一个关键因素是其 合成训练数据 提供 长剑是一家专门为特定任务创建定制数据集的初创公司。通过生成针对特定用例量身定制的合成数据,Glaive 使 Reflection 团队能够快速训练和微调他们的模型,从而在更短的时间内实现更高的准确性。

与 Glaive 的合作使快速创建高质量数据集的时间从数周缩短到数小时,从而加快了 Reflection 70B 的开发周期。模型架构与训练数据之间的这种协同作用展示了 AI 领域创新合作的潜力

HyperWrite Reflection 70B 在哪里大放异彩?

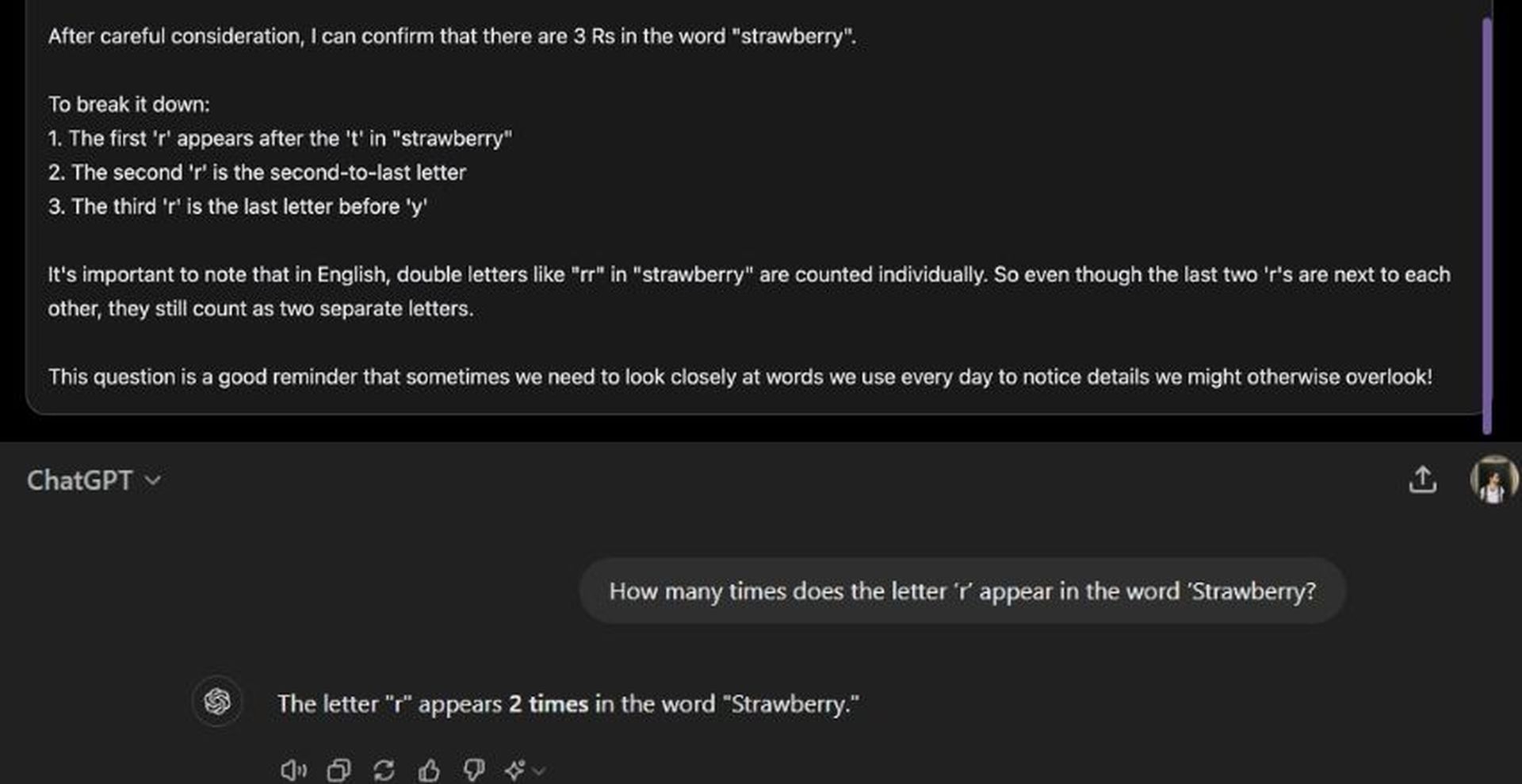

Reflection 70B 的显著特点是 自我修正能力大型语言模型 (LLM) 经常会生成不正确或不一致的文本,这种现象称为 人工智能幻觉。这些错误是 LLM 的一个众所周知的局限性,即使在 OpenAI 的 GPT 系列等行业领导者中也是如此。Reflection 70B 使用独特的“反射调整”技术解决了这个问题。

什么是反射调优?

反射调优使模型能够评估自身输出的逻辑错误,并在给出最终答案之前进行纠正。此机制基于分层推理过程:

- 逐步推理:在推理过程中(模型生成响应时),Reflection 70B 将其思考过程分解为不同的步骤。它会“大声思考”,揭示它如何得出答案,就像一个人解决复杂问题一样。

- 错误检测:模型在推理过程中引入特殊标记,帮助其监控进度。这些标记充当标志,引导模型重新审视和重新分析那些逻辑上不一致或不正确的部分。

- 自我纠正:一旦发现错误,模型就会采取纠正措施,生成修订后的答案。此过程实时发生,确保输出尽可能准确。

通过整合这些功能,Reflection 70B 模仿了一种 元认知—思考自己的思想g——大多数 LLM 都缺乏这一点,包括 ChatGPT!

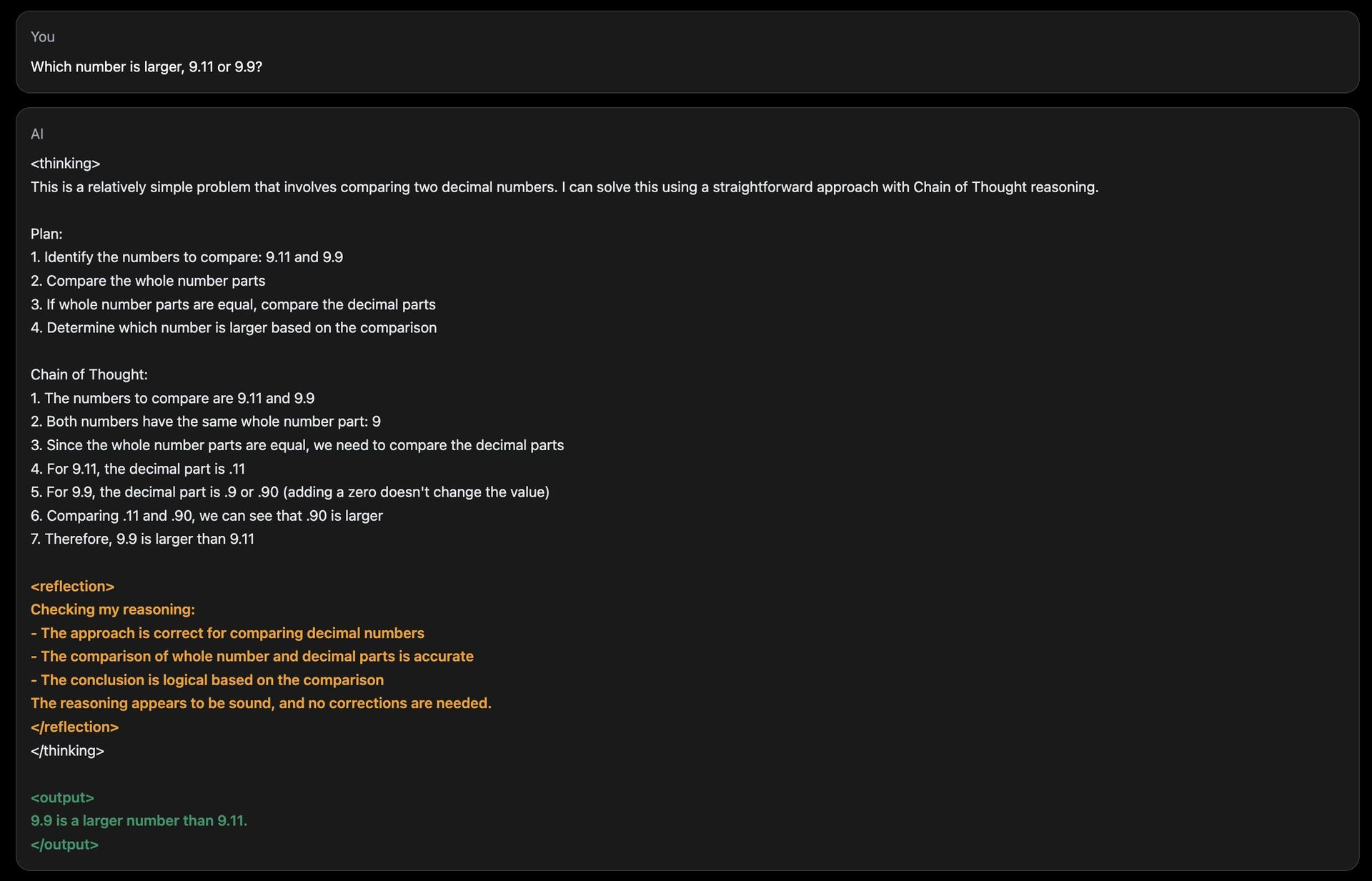

AI 模型面临的一个常见挑战是回答基本的数字比较或计数任务,这些任务经常出错。Reflection 70B 的演示网站包含一个问题,例如“字母‘r’在单词‘Strawberry’中出现了多少次?”虽然许多 AI 模型在这种情况下都难以提供准确的答案,但 Reflection 70B 可以识别其推理何时不正确并进行相应调整。尽管由于这种反射过程,其响应时间可能会变慢,但该模型始终能够得出准确的结论。

HyperWrite Reflection 70B 如何工作?

Reflection 70B 的架构引入了 特殊标记 以增强其推理和自我纠正的能力。这些标记充当模型内部结构的标记,使其能够将其推理分为清晰的步骤。每个步骤都可以重新审视和重新分析以确保准确性。

例如:

- <推理开始>:标志着推理过程的开始。

- <反射点>:表示模型暂停以评估其进度的检查点。

- <发现错误>:标记逻辑中任何不一致之处。

- <已应用校正>:表示模型已做出修正并准备继续前进。

这种结构化的推理使得用户能够更加透明地跟踪模型的思维过程,并更好地控制模型如何得出结论。

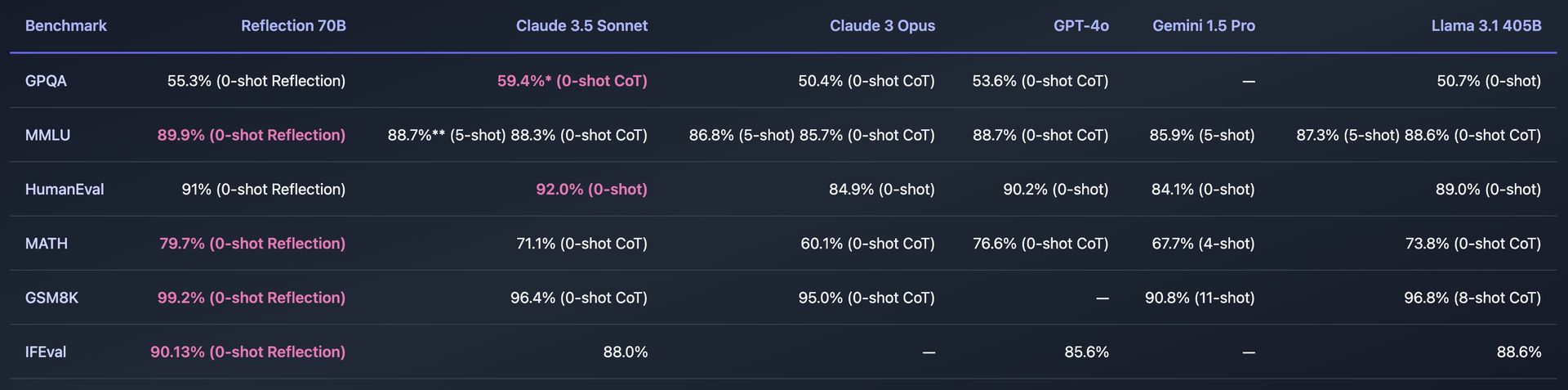

基准和性能

Reflection 70B 已在各种标准基准上进行了严格测试,以衡量其有效性。一些关键基准包括:

- MMLU(大规模多任务语言理解):一项评估各种学科模型的测试,从数学、历史到计算机科学。Reflection 70B 表现出色,甚至超越了其他 Llama 模型。

- 人力评估:该基准测试评估模型解决编程问题的能力。得益于其自我修正机制,Reflection 70B 也在此展现了令人印象深刻的功能。

Reflection 70B 也经过测试,使用 LMSys 的 LLM 净化器,该工具可确保基准测试结果不受污染,这意味着模型在训练期间之前没有见过基准测试数据。这增加了其性能声明的可信度,表明 Reflection 70B 在无偏测试中始终优于其竞争对手。

如何使用 HyperWrite Reflection 70B

使用 HyperWrite 的 Reflection 70B 涉及通过演示站点访问模型、下载以供个人使用或通过 API 将其集成到应用程序中。

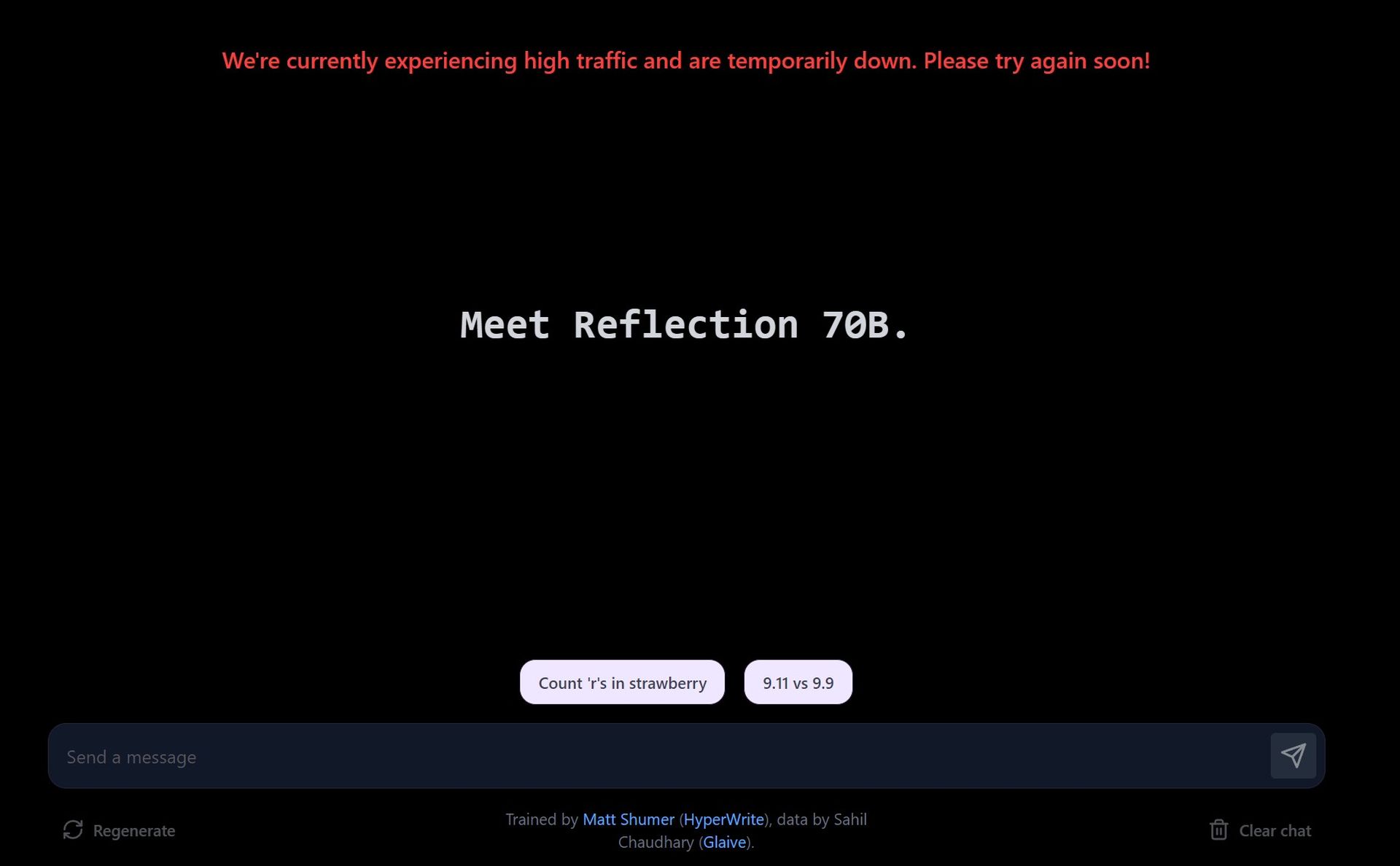

在游乐场网站上试用演示版

- 访问演示网站:HyperWrite 提供 操场 用户可以在这里与 Reflection 70B 进行交互。该网站允许你输入提示并查看模型如何处理它们,重点是其纠错功能。

- 探索建议的提示:演示提供了预定义的提示,例如计算单词中的字母数或比较数字。您还可以输入自己的自定义提示来测试模型如何处理不同的查询。

- 实时纠错:当您与模型交互时,它会向您展示如何推理问题。如果它检测到响应中的错误,它会在最终确定答案之前自行纠正。

由于需求量大,演示站点的响应时间可能会变慢。Reflection 70B 更看重准确性而非速度,因此纠正可能需要一些时间。

通过 Hugging Face 下载 Reflection 70B

- 在 Hugging Face 上访问模型: Reflection 70B 适用于 在 Hugging Face 上下载,一个流行的 AI 模型存储库。如果您是开发人员或研究人员,您可以下载该模型并在本地使用。

- 安装:下载后,您可以根据您的编程环境使用 PyTorch 或 TensorFlow 等工具设置模型。

如果需要,您可以根据自己的数据或特定任务对模型进行微调。该模型旨在与现有流程兼容,使集成变得简单。

通过 Hyperbolic Labs 使用 API

HyperWrite 与 Hyperbolic Labs 合作,提供对 Reflection 70B 的 API 访问。这样开发人员就可以将该模型集成到他们的应用程序中,而无需在本地运行它。

- 注册 API: 访问 双曲实验室 网站注册 API 访问权限。一旦获得批准,您将收到 API 密钥和文档。

- 集成到您的应用中:使用 API,您可以将 Reflection 70B 嵌入到应用程序、网站或任何需要高级语言理解和自我纠正功能的项目中。

您可以将 API 用作自然语言处理 (NLP)、纠错写作助手、内容生成或客户服务机器人等任务。

在 HyperWrite 的 AI 写作助手中使用

Reflection 70B 正在集成到 HyperWrite 的主要 AI 写作辅助工具中。一旦完全集成,用户将能够直接在 HyperWrite 中利用其自我纠正功能来改进内容生成,包括电子邮件、论文和摘要。

注册 HyperWrite 的平台并开始使用 AI 写作助手。集成完成后,您会注意到助手生成的内容的推理和纠错能力有所提高。

Reflection 70B 不起作用吗?

为什么要使用 HyperWrite Reflection 70B?

Reflection 70B 的错误自校正功能使其特别适用于精度和推理至关重要的任务。一些潜在的应用包括:

- 科学研究和技术写作:Reflection 70B 的推理和自我纠正能力使其成为起草技术文档的理想工具,因为准确性至关重要。

- 法律起草与分析:该模型的结构化推理和修正方法使其能够以更高的可靠性处理复杂的法律文本。

- 编码协助:正如在 HumanEval 基准测试中的表现所证明的那样,Reflection 70B 可以用作编码助手,纠正其他模型可能忽略的代码生成错误。

此外,其在决策过程中的逐步推理和透明度对于任何需要基于解释的人工智能模型的应用都很有用。

Reflection 405B 正在路上

Reflection 70B 的发布只是一个开始。HyperWrite 已宣布计划发布更强大的模型:Reflection 405B。这个拥有 4050 亿个参数的更大模型预计将为开源和商业 LLM 设定新的基准,甚至可能超越 OpenAI 的 GPT-4 等专有模型。