该公司的下一代人工智能模型 OpenAI Orion 正在突破性能瓶颈,暴露出传统扩展方法的局限性。知情人士透露,Orion 的性能提升比前代产品要小,这促使 OpenAI 重新考虑其发展战略。

早期测试显示出稳定的改进

初步员工测试表明 OpenAI Orion 仅完成 20% 的训练后就达到了 GPT-4 级别的性能。虽然这听起来可能令人印象深刻,但值得注意的是,人工智能训练的早期阶段通常会产生最显着的改进。剩下的 80% 的训练不太可能产生显着的进步,这表明 OpenAI Orion 可能不会大幅超越 GPT-4。

据报道,“该公司的一些研究人员认为,Orion 在处理某些任务方面并不比其前身更好” 信息。 “据 OpenAI 员工称,Orion 在语言任务上表现更好,但在编码等任务上可能无法超越以前的模型。”

数据稀缺的困境

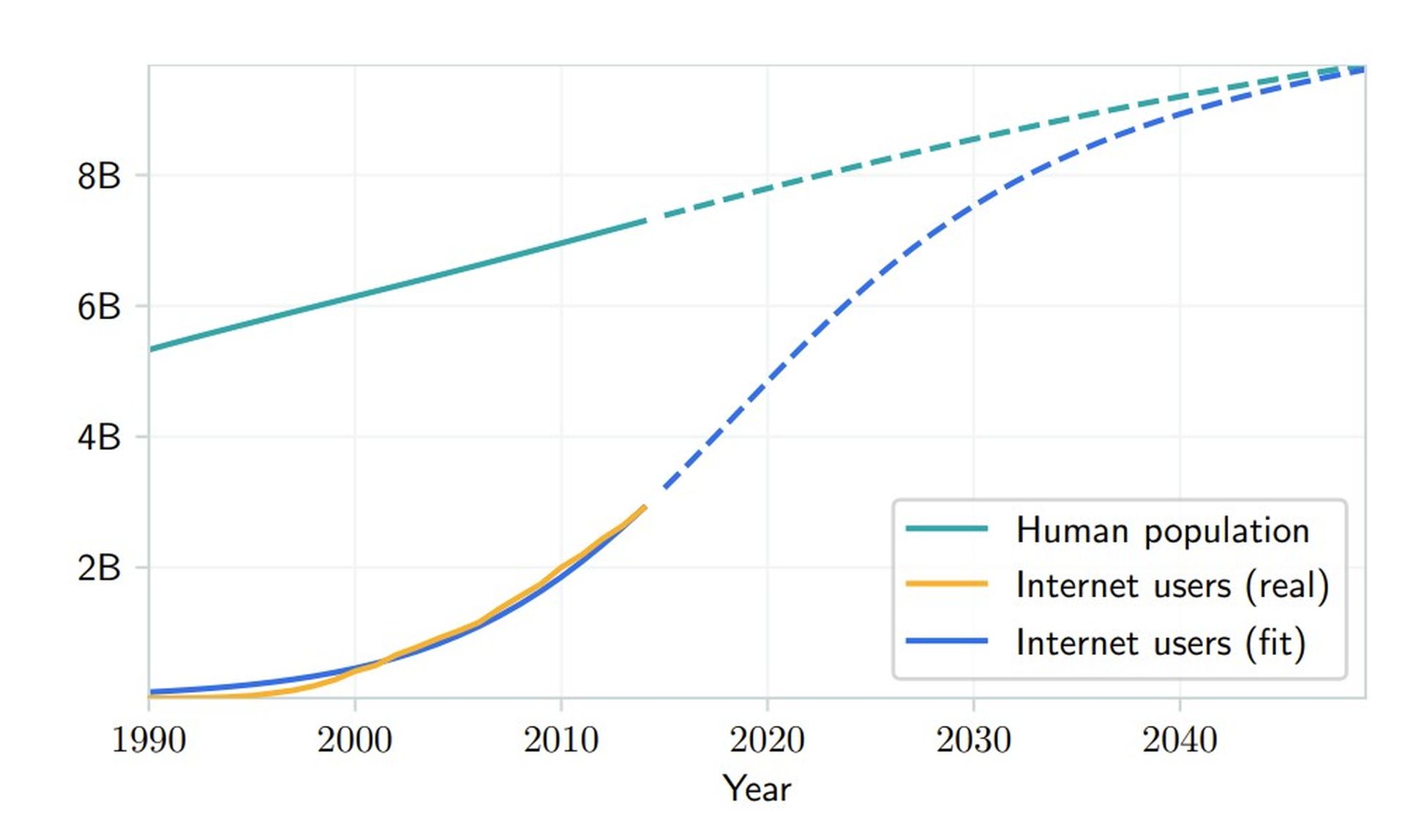

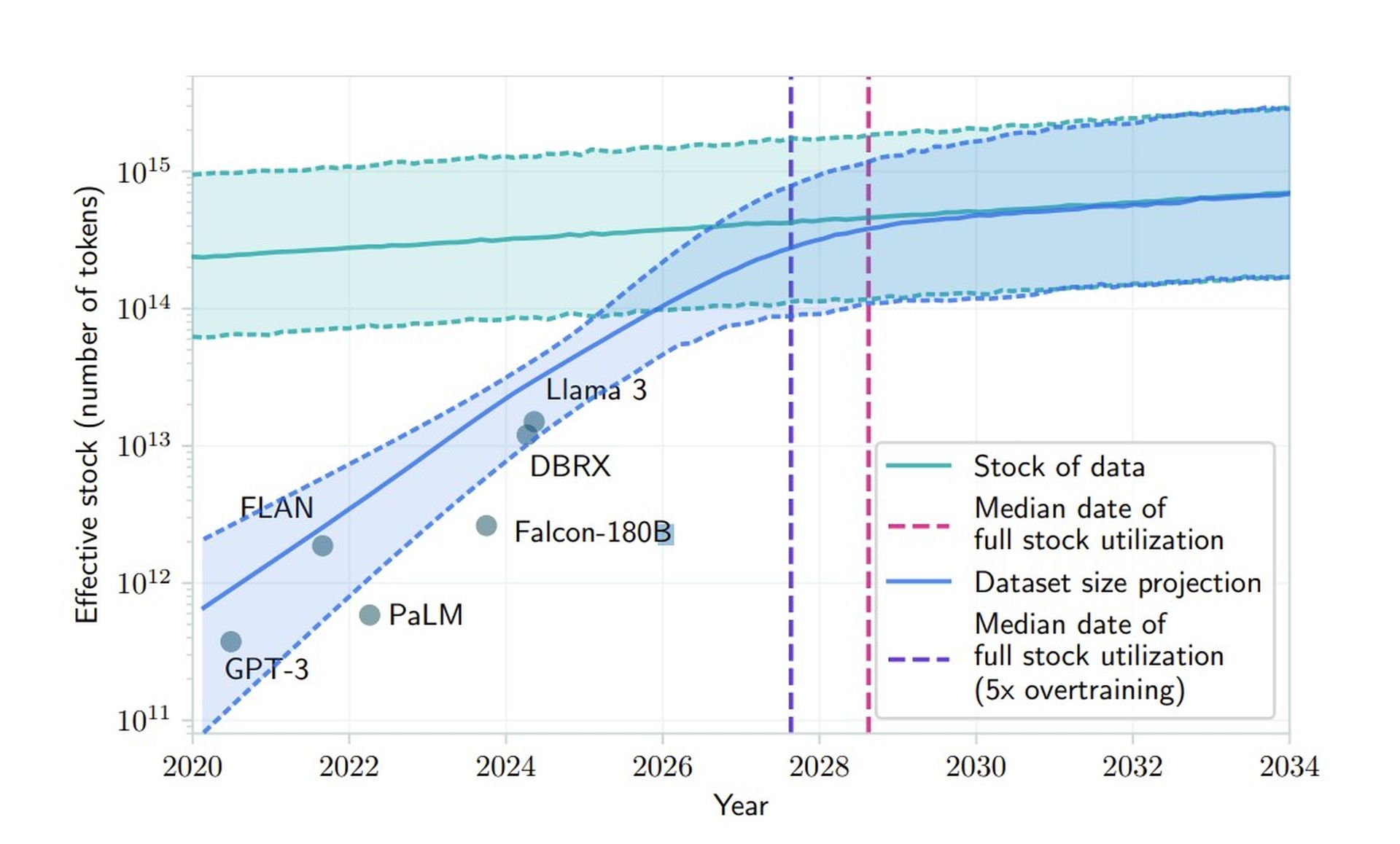

OpenAI 与 Orion 的挑战凸显了人工智能行业的一个基本问题:高质量训练数据的供应不断减少。 6 月发布的研究预测,人工智能公司将在 2026 年至 2032 年间耗尽可用的公共人类生成文本数据。这种稀缺标志着传统开发方法的关键拐点,迫使 OpenAI 等公司探索替代方法。

“我们的研究结果表明,当前的法学硕士发展趋势无法仅通过传统的数据扩展来维持,”该研究 纸质状态。这强调了合成数据生成、迁移学习和使用非公开数据来增强模型性能的必要性。

OpenAI双轨发展战略

为了应对这些挑战,OpenAI 正在重组其方法,将模型开发分为两个不同的轨道。 O系列代号草莓,专注于推理能力,代表了模型架构的新方向。这些模型的计算强度显着提高,并且专门为复杂的问题解决任务而设计。

与此同时,Orion 模型(或 GPT 系列)继续发展,专注于一般语言处理和通信任务。 OpenAI 的首席产品官 Kevin Weil 在 AMA 中证实了这一策略,他表示:“这不是一个或一个,而是两者兼而有之——更好的基础模型加上更多的草莓缩放/推理时间计算。”

综合数据:一把双刃剑

OpenAI 正在探索合成数据生成,以解决 OpenAI Orion 的数据稀缺问题。然而,该解决方案在维持模型质量和可靠性方面引入了新的复杂性。对人工智能生成的内容进行训练模型可能会导致反馈循环,从而放大细微的缺陷,从而产生越来越难以检测和纠正的复合效应。

研究人员发现,严重依赖合成数据可能会导致模型随着时间的推移而退化。 OpenAI 的基础团队正在开发新的过滤机制来维护数据质量,实施验证技术来区分高质量和可能有问题的合成内容。他们还在探索混合训练方法,将人类和人工智能生成的内容结合起来,以最大限度地提高效益,同时最大限度地减少缺点。

OpenAI Orion 仍处于早期阶段,未来还有大量的开发工作。首席执行官萨姆·奥尔特曼表示,它不会在今年或明年做好部署准备。这种延长的时间表可能被证明是有利的,使研究人员能够解决当前的限制并发现模型增强的新方法。

在最近一轮 66 亿美元融资后,OpenAI 面临着更高的期望,它旨在通过创新其发展战略来克服这些挑战。通过正面解决数据稀缺的困境,该公司希望确保 OpenAI Orion 对其最终发布产生重大影响。

特色图片来源: 乔纳森·肯珀/Unsplash