- 并非所有法学硕士都是平等的: GPT-3.5-turbo-instruct 脱颖而出,成为测试中最强大的国际象棋模型。

- 微调至关重要: 指令调整和目标数据集公开显着提高了特定领域的性能。

- 以国际象棋为基准: 该实验强调国际象棋是评估法学硕士能力和完善人工智能系统的宝贵基准。

AI语言模型能下棋吗?这个问题引发了最近对大型语言模型 (LLM) 处理国际象棋任务的效果的调查,揭示了关于其优势、劣势和训练方法的意外见解。

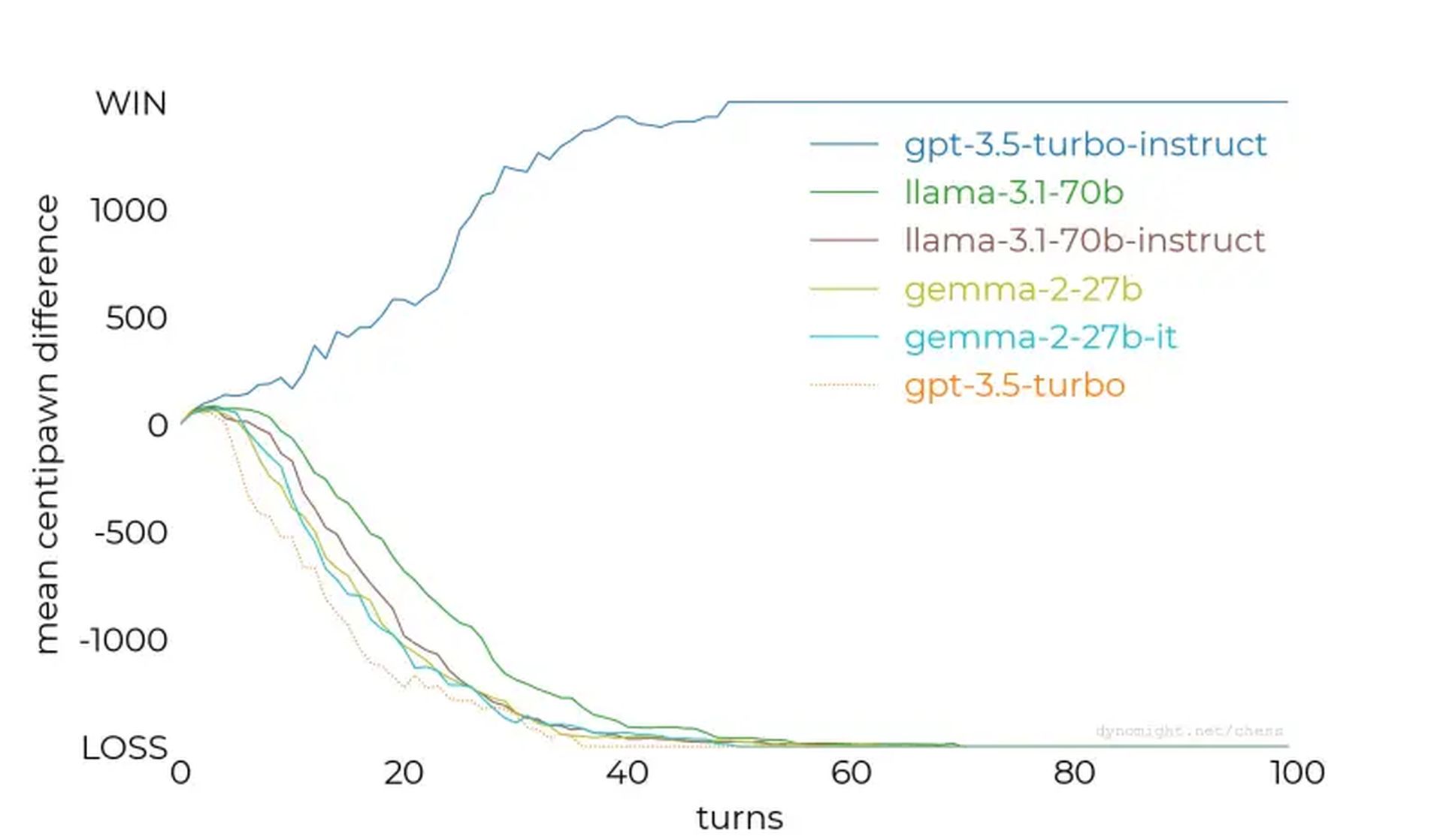

虽然有些模型甚至在最简单的国际象棋引擎上也表现不佳,但其他模型(例如 OpenAI 的 GPT-3.5-turbo-instruct)却显示出令人惊讶的潜力,指出了对人工智能开发的有趣影响。

针对国际象棋引擎测试法学硕士

研究人员测试了各种法学硕士,要求他们以特级大师的身份下棋,并以代数符号提供游戏状态。最初的兴奋集中在法学硕士在大量文本语料库上训练后是否可以利用嵌入的国际象棋知识来有效地预测动作。

然而,结果表明 并非所有法学硕士生来平等。

这 学习 从较小的模型开始,例如 美洲驼-3.2-3b,有 30 亿个参数。在与 Stockfish 的最低难度设置进行 50 场比赛后,该模型输掉了每一场比赛,未能保护其棋子或保持有利的棋盘位置。

测试升级到更大的模型,例如 美洲驼-3.1-70b 及其指令调整的变体,但它们也很挣扎,只显示出轻微的改进。其他型号,包括 Qwen-2.5-72b 和 命令-r-v01,延续了这一趋势,表明人们普遍无法掌握基本的国际象棋策略。

GPT-3.5-turbo-instruct 是意外的赢家

转折点来了 GPT-3.5-turbo-指令,即使在引擎的难度级别增加的情况下,它也能在对抗 Stockfish 时表现出色。与面向聊天的同行不同 GPT-3.5-涡轮 和 GPT-4O,经过指令调整的模型始终能够产生获胜的动作。

为什么有些模型表现出色,而另一些则失败?

该研究的主要发现提供了宝贵的见解:

- 指令调整很重要: 像 GPT-3.5-turbo-instruct 这样的模型受益于人类反馈微调,这提高了它们处理国际象棋等结构化任务的能力。

- 数据集曝光: 有人猜测,指导模型可能接触过更丰富的国际象棋游戏数据集,从而赋予它们卓越的战略推理能力。

- 代币化挑战: 一些细微的差别,例如提示中的空格不正确,性能受到干扰,突显了法学硕士对输入格式的敏感性。

- 竞争数据影响: 在不同的数据集上训练法学硕士可能会削弱他们擅长专业任务(例如国际象棋)的能力,除非通过有针对性的微调来平衡。

随着人工智能的不断改进,这些经验教训将为提高跨学科模型性能的策略提供参考。无论是国际象棋、自然语言理解还是其他复杂的任务,了解如何训练和调整人工智能对于释放其全部潜力至关重要。