抱脸有 释放 两款新的 AI 模型 SmolVLM-256M 和 SmolVLM-500M 声称它们是同类产品中最小的,能够在 RAM 有限的设备(例如笔记本电脑)上分析图像、视频和文本。

Hugging Face 推出用于图像和文本分析的紧凑型 AI 模型

一个 小语言模型 (SLM)是一种旨在生成自然语言文本的神经网络。 “小”这个描述符不仅适用于模型的物理尺寸,还适用于其参数数量、神经结构和训练期间使用的数据量。

SmolVLM-256M和SmolVLM-500M分别包含2.56亿个参数和5亿个参数。这些模型可以执行各种任务,包括描述图像和视频剪辑,以及回答有关 PDF 及其内容(例如扫描文本和图表)的问题。

为了训练这些模型,Hugging Face 使用了 The Cauldron(一个包含 50 个高质量图像和文本数据集的精选集合)以及 Docmatix(一个包含带有详细说明的文件扫描的数据集)。这两个数据集均由 Hugging Face 的 M4 团队创建,专注于多模态 AI 技术。

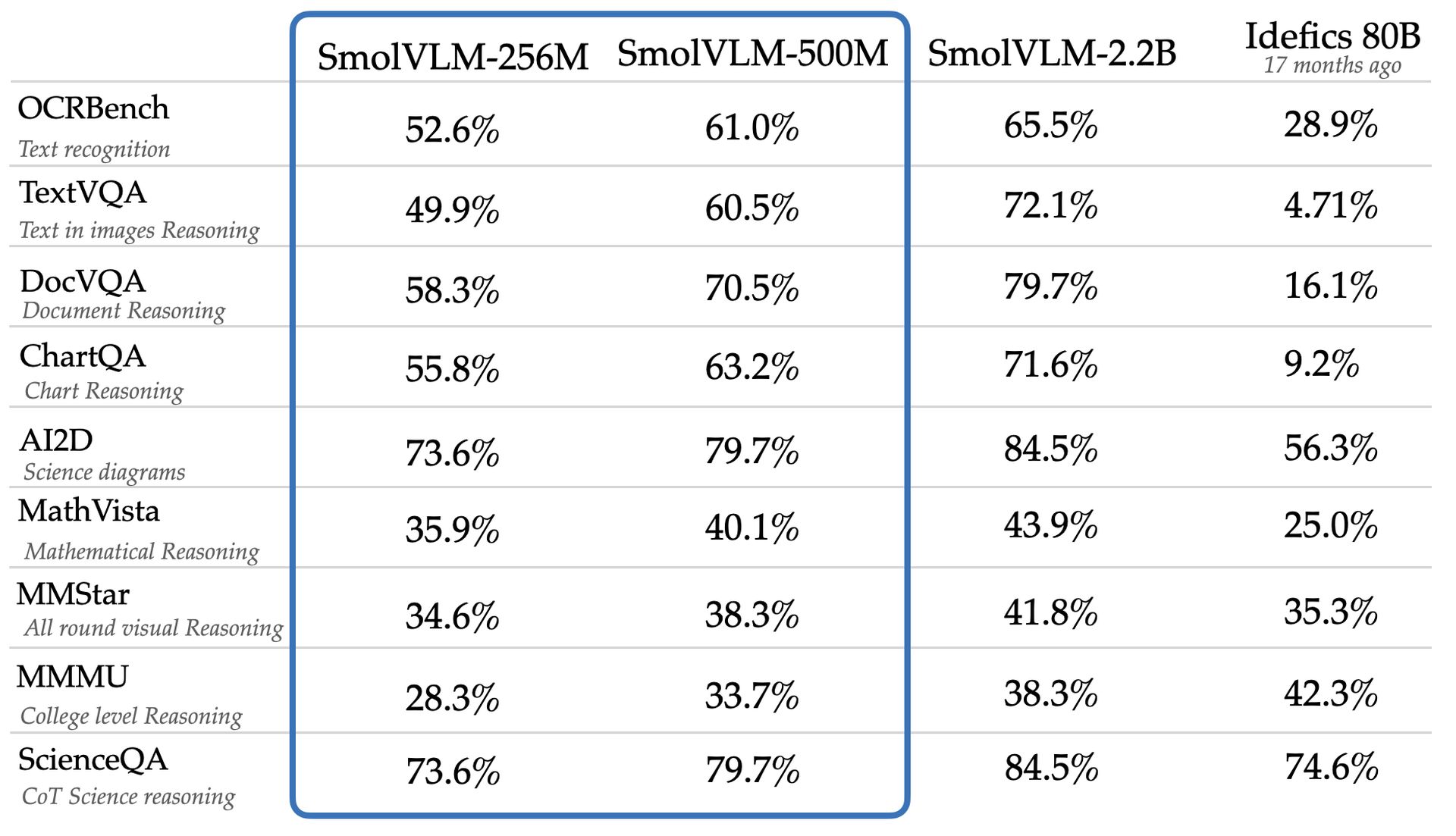

该团队声称,在 AI2D 等基准测试中,SmolVLM-256M 和 SmolVLM-500M 的表现优于更大的模型 Idefics 80B,该基准评估模型分析小学水平科学图表的能力。新模型可通过 Apache 2.0 许可证进行网络访问和下载,从而可以不受限制地使用。

尽管具有多功能性和成本效益,但 SmolVLM-256M 和 SmolVLM-500M 等较小型号可能会表现出较大型号中未观察到的局限性。谷歌 DeepMind、微软研究院和 Mila 研究所的一项研究强调,较小的模型在复杂的推理任务上通常表现不佳,这可能是因为它们倾向于识别表面模式,而不是在新的环境中应用知识。

Hugging Face 的 SmolVLM-256M 模型运行时的 GPU 内存不到 1 GB,性能优于 Idefics 80B 模型(系统大 300 倍),在 17 个月内实现了这一减少和增强。 Hugging Face 的机器学习研究工程师 Andrés Marafioti 指出,这一成就反映了视觉语言模型的重大突破。

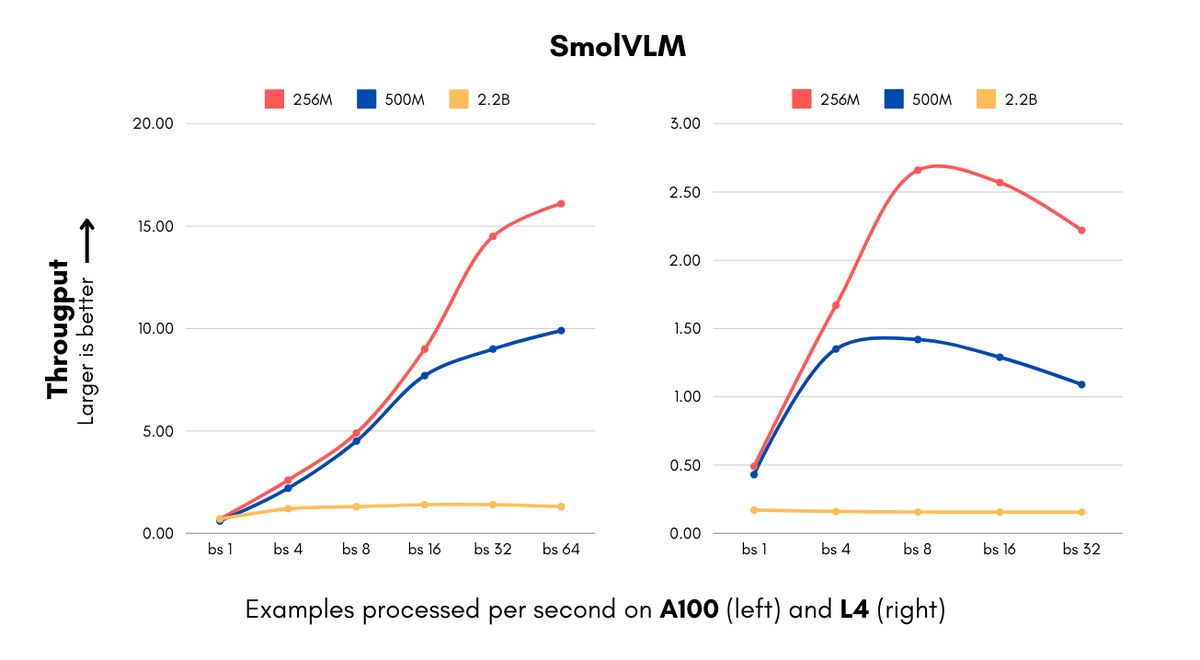

对于面临与人工智能实施相关的高计算成本的企业来说,这些模型的引入是及时的。 SmolVLM 模型能够以前所未有的速度处理图像并理解视觉内容,对于其尺寸的模型而言。 256M 版本每秒可以处理 16 个示例,而批量大小为 64 时仅消耗 15GB RAM,为处理大量视觉数据的企业节省大量成本。

IBM 已与 Hugging Face 建立合作伙伴关系,将 256M 模型纳入其文档处理软件 Docling 中。正如 Marafioti 解释的那样,即使是拥有大量计算资源的组织也可以从使用较小的模型以降低的成本高效处理数百万个文档中受益。

Hugging Face 通过视觉处理和语言组件的进步实现了尺寸减小,同时保持了性能,包括从 400M 参数视觉编码器切换到 93M 参数版本以及使用积极的令牌压缩技术。这种效率为初创公司和小型企业开辟了新的可能性,使他们能够更快地开发复杂的计算机视觉产品并降低基础设施成本。

SmolVLM 模型增强的功能不仅仅是节省成本,还通过名为 ColiPali 的算法促进高级文档搜索等新应用,该算法从文档档案创建可搜索数据库。 Marafioti 表示,这些模型的性能几乎与 10 倍于其大小的模型相匹配,同时显着提高了数据库创建和搜索的速度,使企业范围内的视觉搜索对于各种业务来说都是可行的。

SmolVLM 模型挑战了高级视觉语言任务需要更大模型的传统观念,500M 参数版本在关键基准测试中实现了 2.2B 参数版本的 90% 的性能。 Marafioti 强调,这一发展证明了小型模型的实用性,表明它们可以为企业发挥至关重要的作用。

特色图片来源: 抱脸