DeepSeek-R1在Reddit,X和开发人员论坛上进行了统治技术讨论,用户称其为“ People’s AI”,因为它的不可思议的能力可以竞争Google Gemini和OpenAI的GPT-4O等模型,而无需花费任何成本。

DeepSeek-R1, 免费和开源推理AI,提供了OpenAI每月200美元O1型号的私密性优点替代方案,在编码,数学和逻辑解决问题方面具有可比的性能。本指南提供了分步说明,用于在本地安装DeepSeek-R1并将其集成到项目中,从而每月节省数百美元。

为什么DeepSeek-R1趋势?

与将用户锁定在订阅和数据共享协议中的封闭模型不同,DeepSeek-R1在本地部署时完全离线运行。社交媒体基准表明它解决了列表问题的速度比 Openai的O1 仅使用30%的系统资源模型。 Tiktok演示在90秒内编码基于Python的费用跟踪器的编码增长了270万次观看次数,诸如“双子座永远不可能”之类的评论淹没了该线程。它的吸引力?没有API费用,没有用法上限,也没有强制性的互联网连接。

什么是DeepSeek-R1,与OpenAi-O1相比如何?

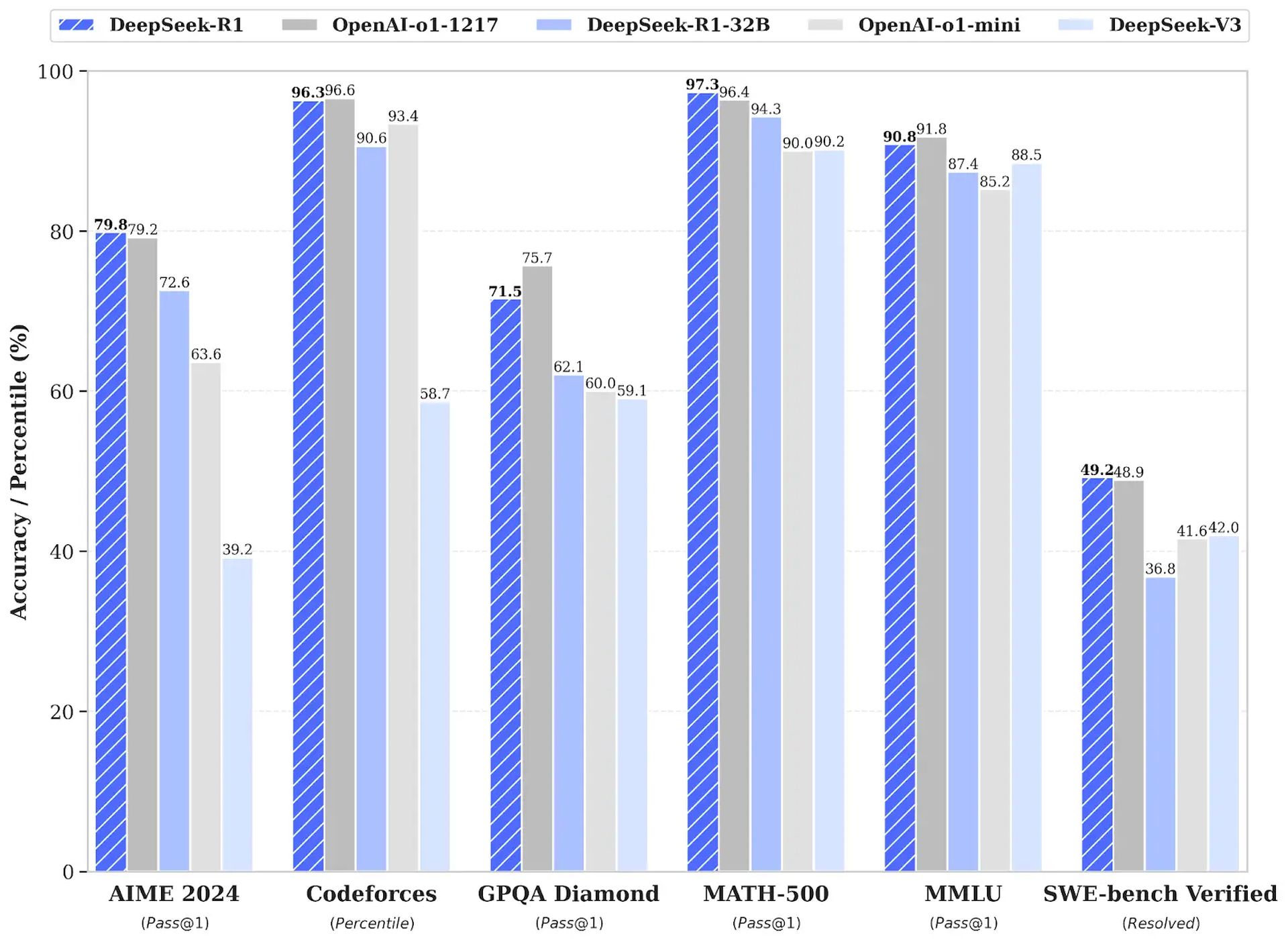

DeepSeek-R1是一种革命性的推理AI,它使用增强学习(RL)而不是监督微调,在AIME 2024 MATH基准上获得了79.8%的通过@1分。它的成本效率优于OpenAI-O1,API便宜96.4%(0.55美元,每百万个输入令牌15美元),并且能够在消费者硬件上本地运行。 DeepSeek-R1是开源的,提供了六种蒸馏型,范围从1.5B到671b参数,用于不同的应用。

DeepSeek-R1(本地)的分步安装指南

要使用Ollama在本地安装DeepSeek-R1并打开Web UI,请按照以下步骤:

1。安装 霍拉马 通过终端(MacOS/Linux):

curl -fsSL https://ollama.com/install.sh | sh ollama -v #check Ollama version2。通过Ollama下载DeepSeek-R1蒸馏型:

# Default 7B model (4.7GB - ideal for consumer GPUs)

ollama run deepseek-r1

# Larger 70B model (requires 24GB+ VRAM)

ollama run deepseek-r1:70b

# Full DeepSeek-R1 (requires 336GB+ VRAM for 4-bit quantization)

ollama run deepseek-r1:671b3。为私人接口设置打开的Web UI:

docker run -d -p 3000:8080

--add-host=host.docker.internal:host-gateway

-v open-webui:/app/backend/data

--name open-webui

--restart always

ghcr.io/open-webui/open-webui:main访问接口 http:// localhost:3000 并选择 deepseek-r1:latest。所有数据保留在您的机器上,以确保隐私。

如何将DeepSeek-R1整合到您的项目中

DeepSeek-R1可以在本地或通过其云API集成:

1。当地部署(隐私优先):

import openai

Connect to your local Ollama instance

client = openai.Client(

base_url="http://localhost:11434/v1",

api_key="ollama" # Authentication-free private access

)

response = client.chat.completions.create(

model="deepseek-r1:XXb ", # change the "XX" by the distilled model you choose

messages=[{"role": "user", "content": "Explain blockchain security"}],

temperature=0.7 # Controls creativity vs precision

)2。使用官方的DeepSeek-R1 Cloud API:

import openai from dotenv import load_dotenv import os

load_dotenv()

client = openai.OpenAI(

base_url="https://api.deepseek.com/v1",

api_key=os.getenv("DEEPSEEK_API_KEY")

)

response = client.chat.completions.create(

model="deepseek-reasoner",

messages=[{"role": "user", "content": "Write web scraping code with error handling"}],

max_tokens=1000 # Limit costs for long responses

)DeepSeek-R1提供了一种以易隐私为中心的openAI-O1的替代品,非常适合寻求节省资金并维护数据安全的开发人员。为了进一步的帮助或分享经验,鼓励用户与社区互动。

特色图片来源: DeepSeek