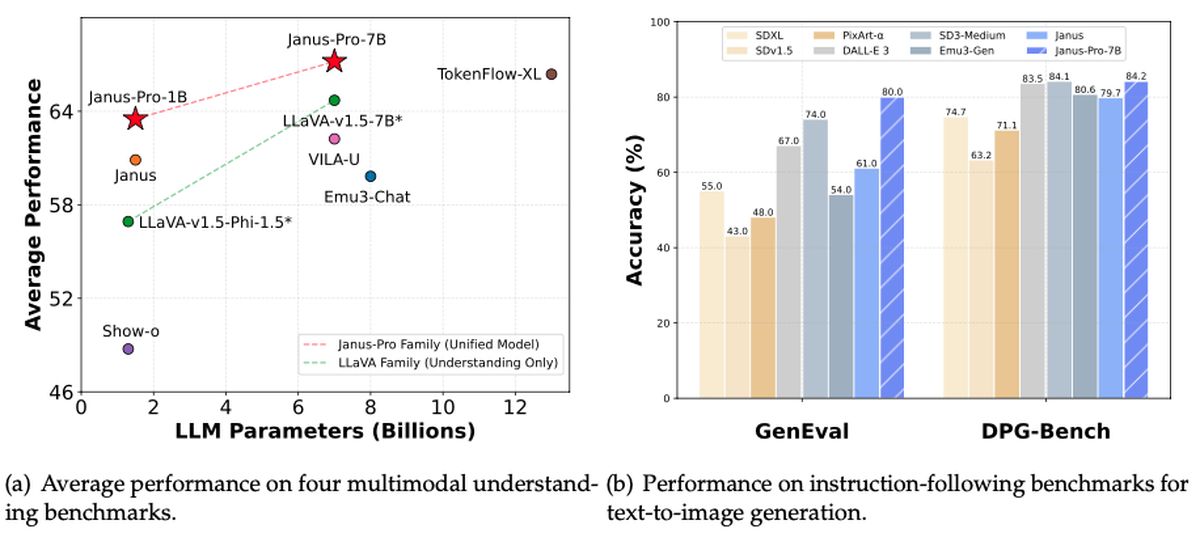

DeepSeek揭开了对开源AI景观的另一个重大贡献。这次是Janus-Pro-7b:一个能够理解和生成图像的多模式强力室。根据 罗恩·张,新的模型不仅黯然失色地在诸如Geneval和DPG基座等基准中稳定的dall-e 3和稳定的扩散,而且还表现出相同的“自由使用”精神,使DeepSeek早期的R1模型成为病毒感。同时,投资者正在争先恐后地理解AI突破的激增,并带有 NVIDIA的股票在中午下降了17%。

Janus-Pro-7b可以成为已经动荡的科技市场中的下一个大颠覆者吗?

什么是DeepSeek Janus-Pro-7b?

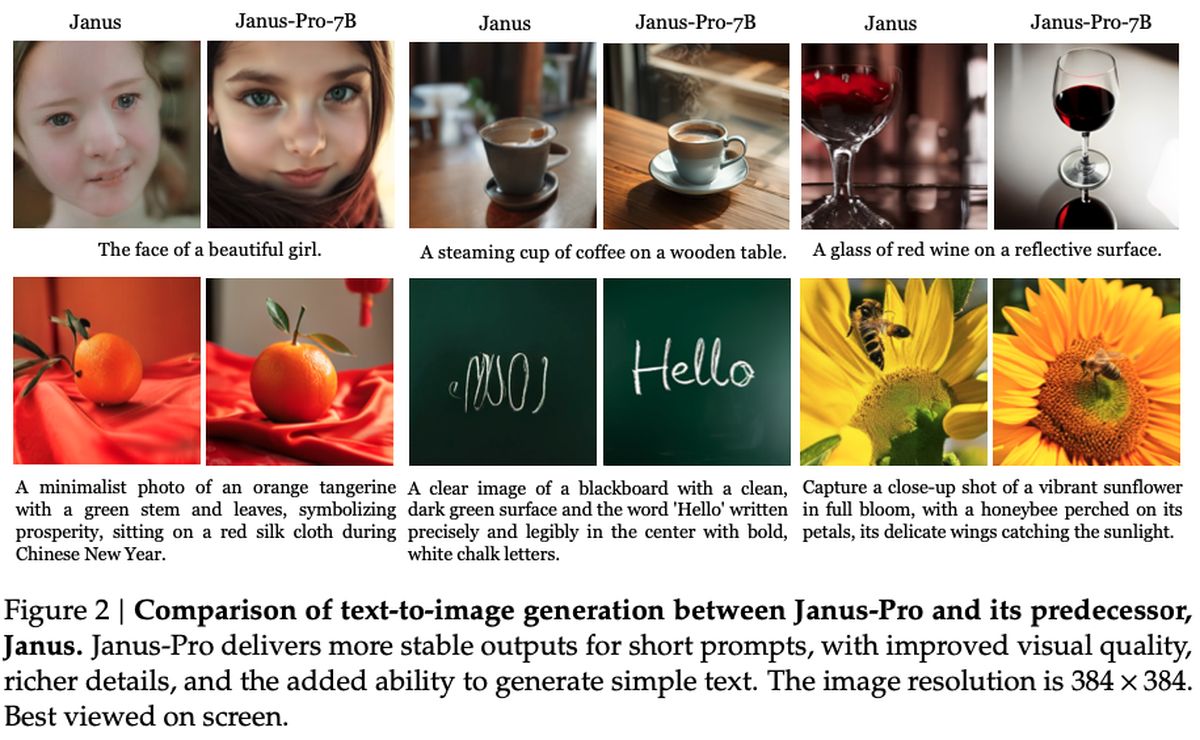

在引擎盖下,Janus-Pro-7b希望弥合强大的视觉处理与快速文本生成之间的差距。从其siglip-l编码器借用一种新颖的解耦方法,该系统可以在跳入创意输出模式之前快速解析384 x 384图像。它匹配了该领域中许多专业模型的匹配,甚至超过了许多专业模型,这一成就尤其引人注目,因为它也很容易自定义和扩展。

分析师指出了DeepSeek一致的理念:保持开放源代码,保持隐私优先和基于订阅的竞争对手。 Janus-Pro-7b似乎在所有三个方面都可以交付,同时保留了吸引粉丝DeepSeek-R1的离线功能的可访问性。

用纯粹的事实术语,Janus-Pro-7B被许可在允许下获得许可 麻省理工学院框架,还有DeepSeek的使用指南。该模型通过GITHUB存储库集成了下游项目,据报道,该模型仅在其图像生成管道中使用16倍下采样。当前的指标表明,Janus-Pro-7b的到来可能会激发AI开发人员之间的新竞争,尽管只有时间才能说明这种最新的免费产品将如何影响AI区域。

它如何工作?

如 研究论文 该模型由DeepSeek发布,采用了siglip-large-patch16-384编码器,该编码器以384×384分辨率将每个图像分解为16×16个补丁。这种方法保留了细粒细节,帮助系统更准确地解释图像。在一代,Janus-Pro使用16,384个代币的代码手册以16×倒数采样的量表表示图像,从而实现了有效的重建,该重建能够与质量相抗衡(如果不超过)传统扩散模型。

两个关键的MLP(多层感知器)适配器连接这些理解和生成组件,以确保两个任务之间的数据流平稳。在培训期间,该模型看到了图像和文本数据的混合,从而可以学习如何解释视觉场景并制作自己的图像。会议通常需要在大规模的GPU群集上(对于1.5B和7B参数版本)进行7至14天,并在GQA(用于视觉理解)和VisualGen(用于图像创建)等基准测试上测试性能。结果是一个多功能框架的多种模式任务,这要归功于其专业化但具有凝聚力的架构。

如何使用DeepSeek Janus-Pro-7b?

开始使用Janus-Pro-7B,就像前往其官方GitHub存储库,克隆或下载代码并安装必要的依赖关系一样简单。该存储库包括一个全面的读数,它可以使您通过设置Python环境,拉动模型权重和运行示例脚本。根据硬件的不同,您可以在仅CPU模式或线束GPU加速度之间进行选择,以更快地性能。无论哪种方式,要归功于有据可查的先决条件和分步说明,安装过程仍然很简单。

一旦所有内容启动并运行,您就可以在提示中进食文本生成,也可以为模型的唯一多模式功能提供图像输入。存储库中的示例笔记本显示了如何生成创意输出,应用高级图像转换或探索“ Visual Q&A”方案。对于更高级的用户,存储库的模块化设计意味着您可以调整基础层,插入自己的数据集,甚至可以与其他DeepSeek版本(如R1)一起堆叠模型。