一种名为S1的新型AI模型 揭开了 在2月2日发表的一篇论文中,由于其具有成本效益的Openai的O1的成本效益,引起了人们的关注,以仅6美元的培训成本获得了重要的能力。

AI Model S1作为Openai O1的具有成本效益的替代品

使用更简单的基础架构,S1模型达到了接近最先进的性能水平。它通过干预措施(例如用“等待”替换终端标签)来扩展“思考时间”,从而增强了大型语言模型(LLM)。

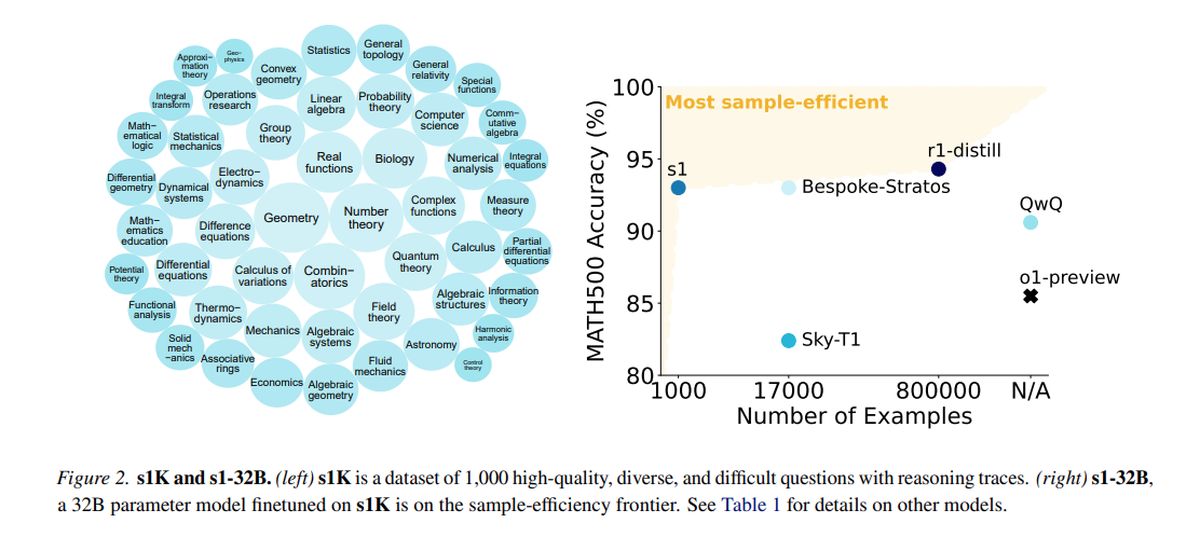

在由QWEN2.5的1,000个高质量示例组成的蒸馏数据集中培训,由阿里巴巴云开发,S1使用16个NVIDIA H100 GPU,单次训练持续约26分钟。总计算成本约为6美元,即使对于资源有限的团队来说,也可以进行更频繁的实验。

尽管OpenAI和Anthropic等较大的组织取决于广泛的基础设施,但S1等创新表明了预算范围内的进展潜力。但是,S1的引入引发了人们对“厌恶”的关注,这种做法是,模型利用来自其他AI系统的蒸馏数据集,提出了引发行业讨论的道德和法律问题。

在测量数学和编码能力的测试中,S1与领先的推理模型相当,例如OpenAI的O1和DeepSeek的R1。 S1模型(包括其数据和培训代码)可在GitHub上访问。

S1背后的团队始于现成的基本模型,并通过蒸馏进行了完善,这是一种使用其答案从现有AI模型中提取推理功能的方法。具体而言,S1从Google的 双子座2.0 Flash Thinking实验,代表伯克利研究人员在上个月开发AI推理模型的类似方法。

较小的研究团队在没有实质性财务支持的情况下在AI领域进行创新的能力既兴奋又带来了挑战。问题是关于在景观中可持续优势的可持续性的问题,在这种景观中,昂贵的模型可以负担得起。

Openai表示不满意,指称DeepSeek为模型蒸馏而从其API中收集了不当的数据。研究人员的目的是设计一种直接的方法,以实现强大的推理性能和“测试时间缩放”,使AI模型能够在响应之前进行更深入的分析。

S1研究表明,可以通过一种称为监督微调(SFT)的方法使用相对较小的数据集蒸馏推理模型,该方法指示AI模型模仿数据集中的某些行为。与DeepSeek为R1模型使用的大规模增强学习方法相比,这种方法往往更经济。

Google可以免费访问Gemini 2.0 Flash Thinking实验,尽管使用情况受每日速率限制,并且其术语禁止反向工程模型创建竞争服务。 S1培训过程涉及策划一个量身定制的问题和答案的数据集以及GEMINI 2.0的推理过程。

经过不到30分钟的训练,S1在特定的AI基准上表现出强劲的性能。参与该项目的斯坦福大学的研究人员尼克拉斯·穆尼基诺夫(Niklas Muennighoff)表示,今天可以租用必要的计算资源,价格约为20美元。

研究人员还通过指示在推理过程中“等待”,从而扩大了思维时间并获得了略有改进的答案,从而实现了一种技术来提高S1的准确性。

特色图片来源: Google DeepMind/Unsplash