人工智能在三个维度上越来越好了解世界,但是一项新研究表明许多 3D大语言模型(LLM)基准可能实际上根本没有测试3D功能。取而代之的是,这些评估可能是研究人员所说的“ 2D作弊”问题的受害者 – 在2D图像上训练的AI模型仅通过将点云渲染到图像中就可以超越专用的3D模型。

一支来自上海若昂大学的团队,包括Jiahe Jin,Yanheng He和Mingyan Yang,在他们的研究中发现了“重新访问3D LLM基准:我们真的测试了3D功能吗? 许多用于评估3D AI的任务可以通过视觉模型(VLM)(VLMS)(主要是在2D图像和文本上训练的AI系统)同样容易解决。这提出了一个至关重要的问题:当前的基准测试是否真正衡量了3D理解,还是只是测试了AI可以处理3D数据的2D渲染的程度?

2d-Cheating:揭示基准弱的快捷方式

该问题源于如何评估3D LLM。许多现有基准依靠 问答和字幕任务,要求AI描述3D对象或回答有关它的问题。假设是 3D训练的AI 应该比仅了解2D图像的表现更好。

但是,研究人员发现 GPT-4O和QWEN2-VL等VLM这不是专门为3D任务设计的,可以 通常超过最先进的3D模型– 通过查看点云的2D图像来简单。这表明这些基准并未实际测试AI是否了解3D结构,而是 从平面图像中推断出3D信息的能力如何。

为了证明这一点,团队发展了 VLM3D,将3D点云转换为渲染的图像之前,将其馈入VLM之前。在主要的3D AI基准测试时(包括) 3D MM-VET,OBJAVERSEXL-LVI,SCANQA和SQA3D– VLM3D在许多任务中始终超过或匹配领先的3D模型。

为什么某些3D任务比其他任务更脆弱

虽然VLM在对象识别和基本场景描述等任务上表现出色,但他们在需要更深入了解的任务上挣扎 空间关系,遮挡和多视图一致性。

- 简单的3D对象基准:3D基准中的许多对象识别任务可能是 使用2D图像轻松解决。研究发现,在这些情况下,VLM可以匹配或超过3D模型,证明基准测试没有有效测试3D理解。

- 复杂的场景基准:要求AI了解完整3D环境的任务,例如 场景级问答,,,, 导航, 和 情境推理,对于VLM而言,很难欺骗。在这里,3D LLM始终表现得更好,表明这些任务确实依赖于真正的3D空间推理。

这意味着 并非所有3D基准都有缺陷– 但其中许多未能区分 真正的3D功能和2D推理技巧。

当2D型号卡住时

VLM在3D任务中最大的弱点之一来自 观点选择– 单个2D图像仅捕获了3D场景的一部分事实。

研究人员测试了 三种不同的渲染方法 评估这对性能有多大影响:

- 单视: 最简单的方法,其中对象或场景是从固定的角度呈现的。 VLM在这里表现最好,因为他们只能从一个图像中提取足够的信息。

- 多视图: 图像是从中捕获的 四个不同的角度,使AI模型更多的上下文。令人惊讶的是,VLM 没有显着改善 与单视模型相比,他们努力将多种观点结合到统一的3D理解中。

- Oracle View: AI被给予 最好的观点 用于回答每个问题。 在这里,VLM的表现要好得多,但仍然没有专用的3D LLM,表明即使给出了完美的图像,它们也缺乏真正的3D推理能力。

这加强了这样的想法 VLM不“理解” 3D– 当给出正确的2D视图时,它们会做得很好。

需要改变什么

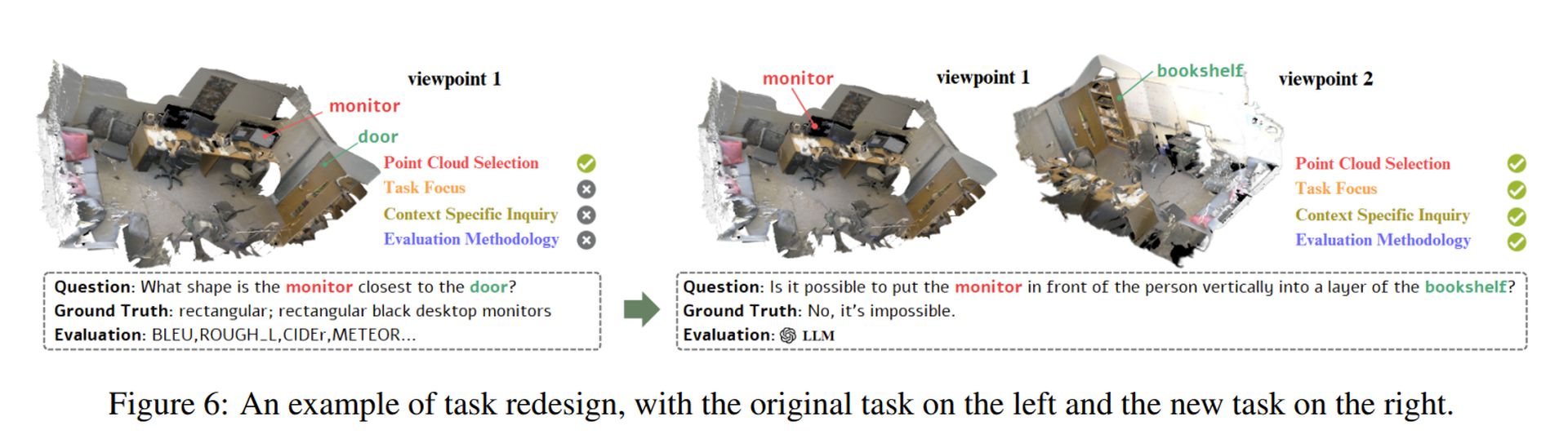

为了真正评估3D AI模型,该研究提出了 四个关键原则 用于设计更好的基准:

- 更复杂的3D数据: 基准应该包括 详细且现实的3D场景 具有结构上的复杂性。

- 需要真正3D推理的任务: 不仅应识别对象,还应在需要的任务上测试AI 空间理解,例如预测隐藏的表面或有关对象相互作用的推理。

- 情境感知挑战: 应该设计问题以关注 唯一的3D属性,确保不能仅使用单个2D图像来回答它们。

- 更好的评估指标: 当前的基准通常依靠 文本相似性得分,未能捕获 真正的3D理解。相反,应根据其模型的能力来评估AI模型 在三维空间中推断深度,结构和对象关系。

研究人员证明了如何应用这些原则 重新设计有缺陷的任务 (请参见上图)。他们的方法可确保AI模型实际上必须 过程3D结构 而不是依靠2D快捷方式。

特色图片来源: Sebastian Svenson/Unsplash