大型语言模型(LLM)变得越来越聪明,但是它们也撞到了墙:处理长文本的文本缓慢且计算昂贵。传统的注意机制(AI如何处理和记住信息的核心)努力努力地扩展规模,使训练和运行的模型成本高昂。

现在,研究人员 Deepseek-ai和北京大学 有 引入 改变游戏规则的方法 本质上稀疏的注意力(NSA)。这种新方法有望使AI模型显着 更快,更便宜,更高效,同时保持与传统方法相同的推理能力水平。

为什么AI的注意力问题需要解决

想象一下阅读一本书,您必须始终牢记每句话 – 完全关注 机制在AI中起作用。他们在长序列上扫描和存储信息,但是随着上下文长度的增长(想想成千上万个单词),这种方法变得非常慢,计算沉重。

为了解决这个问题,研究人员探索了 稀疏的注意力– 选择性地仅处理最重要的信息,而不是所有内容。但是,现有的稀疏方法具有 主要弱点:

- 他们很难从头开始训练,通常要求模型在切换到稀疏的方法之前首先学习。

- 他们没有完全优化现代硬件,这意味着理论上的速度提高并不总是转化为现实世界的效率。

NSA如何改变游戏

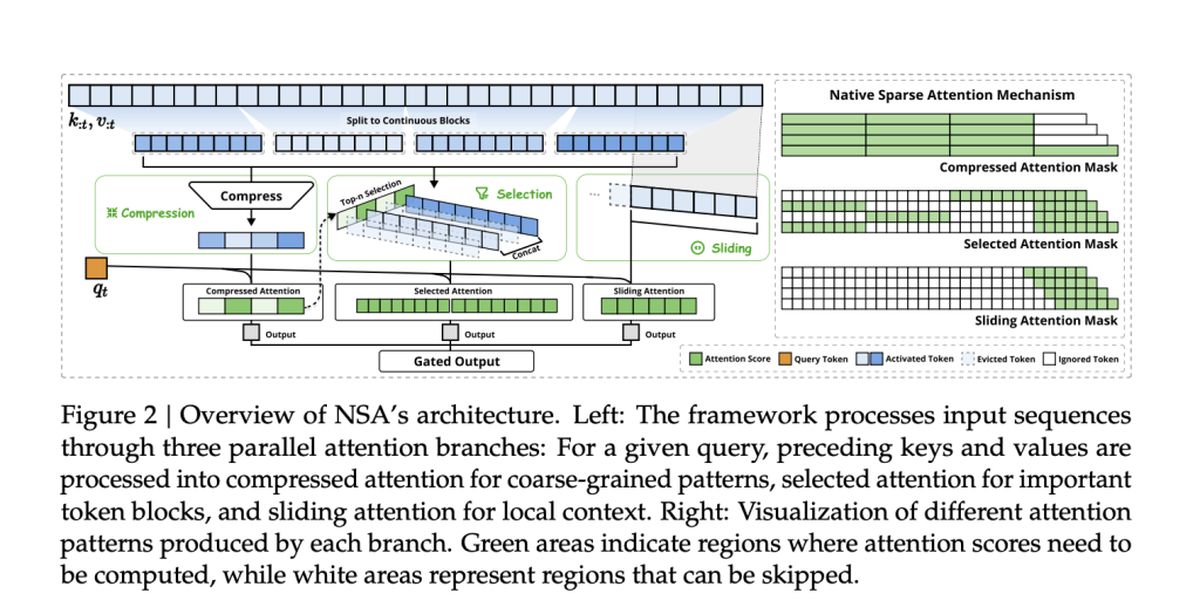

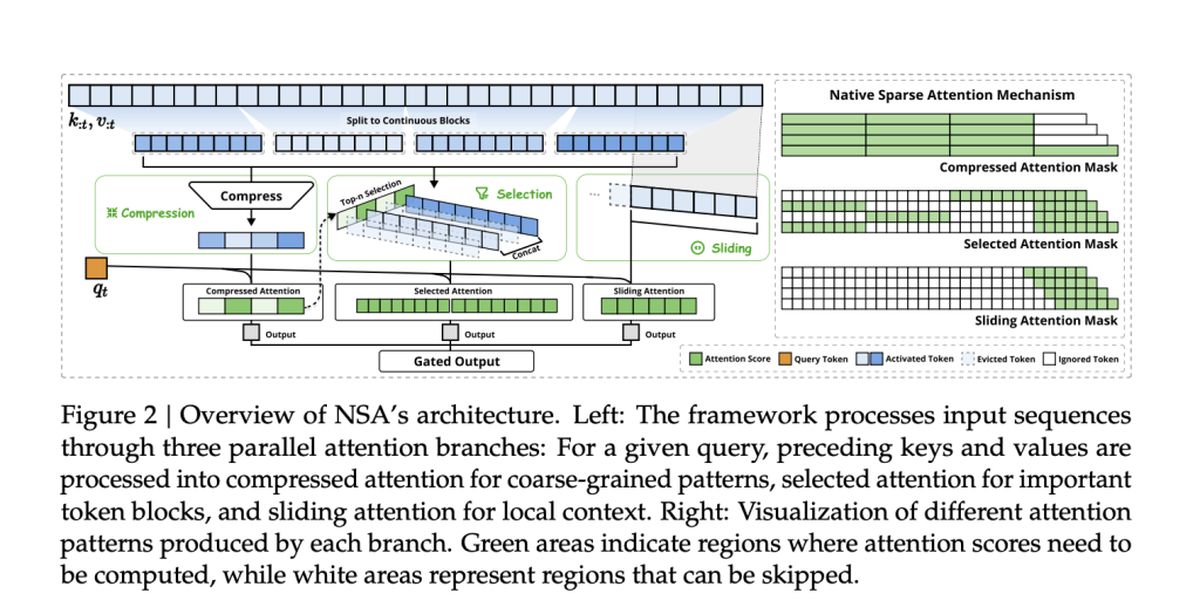

NSA背后的团队,包括Jingyang Yuan,Huazuo Gao,Damai Dai及其同事,采取了新的方法。他们的方法 从一开始就本来就整合稀疏性,而不是将其作为事后想法。

NSA通过 两个关键的创新:

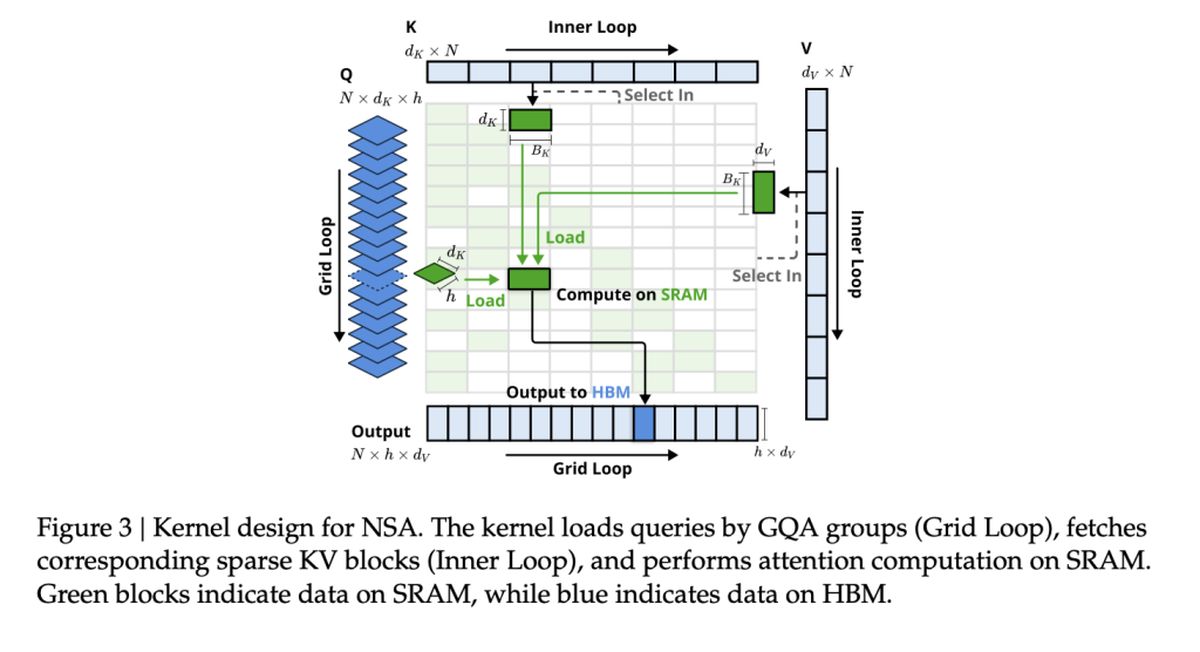

- 硬件一致的效率: NSA的旨在最大程度地提高GPU性能,避免记忆瓶颈并确保现实世界的加速。

- 端到端的训练性: 与以前的稀疏方法不同,NSA可以从头开始训练,从而降低培训成本而不会失去准确性。

速度和准确性:NSA优势

那么,NSA如何与传统的全面关注模型相抵触?根据这项研究, NSA最多可提高11倍速度 尽管仍然对关键基准的关注(甚至超过表现)仍然匹配。

一些最大的胜利包括:

- 更快的处理:NSA加快了AI处理长文档,代码库和多转交谈的能力。

- 更好的推理:尽管是“稀疏”,但NSA模型 匹配或超过 经过想法的推理任务中的全部注意力模型。

- 降低成本:通过减少计算而无需牺牲性能,NSA可以使高级AI负担得起训练和部署。

现有的稀疏注意方法

许多现有的稀疏注意机制试图通过 有选择地修剪令牌 或者 优化内存访问。但是,它们通常在实施实施方面缺乏,要么是因为它们引入了不可鉴定的组件,要么无法与现代GPU架构保持一致。

例如:

- clusterkv和magicpig 依靠离散的聚类或哈希技术,这些技术破坏了梯度流和阻碍模型训练。

- H2O和终结 仅在特定的推理阶段应用稀疏性,从而限制了整个管道的速度提高。

- Quest and Infllm 使用块选择方法,但是他们基于启发式的评分通常会导致召回率较低。

NSA 通过本地整合稀疏性来解决这些限制– 在保留模型准确性的同时,提高训练和推理的效率。这意味着 没有事后近似 或速度和推理能力之间的权衡。

NSA在实际任务上的表现

为了验证NSA的有效性,研究人员在一系列AI任务中对其进行了测试,并将其性能与传统的全部注意模型和最新的稀疏注意方法进行了比较。结果突出了NSA的能力 匹配或超越全部注意模型,同时大大降低计算成本。

一般基准性能

NSA证明了 跨知识,推理和编码基准的高精度, 包括:

- mmlu&cmmlu: 在基于知识的任务中充分关注

- GSM8K和数学: 在复杂的推理中胜过全力以赴

- Humaneval&MBPP: 提供坚实的编码性能

长篇小说的理解

NSA 擅长处理长篇文化序列 在基准中 longbench。在需要深层上下文记忆的任务中,NSA坚持:

- 在检索任务中高度召回 (在 – 干堆中,文件质量检查)

- 多跳推理的稳定精度 (HPQ,2Wiki,Govrpt)

现实世界的速度增长

NSA中的硬件一致性优化导致:

- 9×更快的推理速度 对于64k长度序列

- 6×更快的训练效率 与完全关注的模型相比

- 减少内存带宽消耗,使大规模的AI应用程序更可行