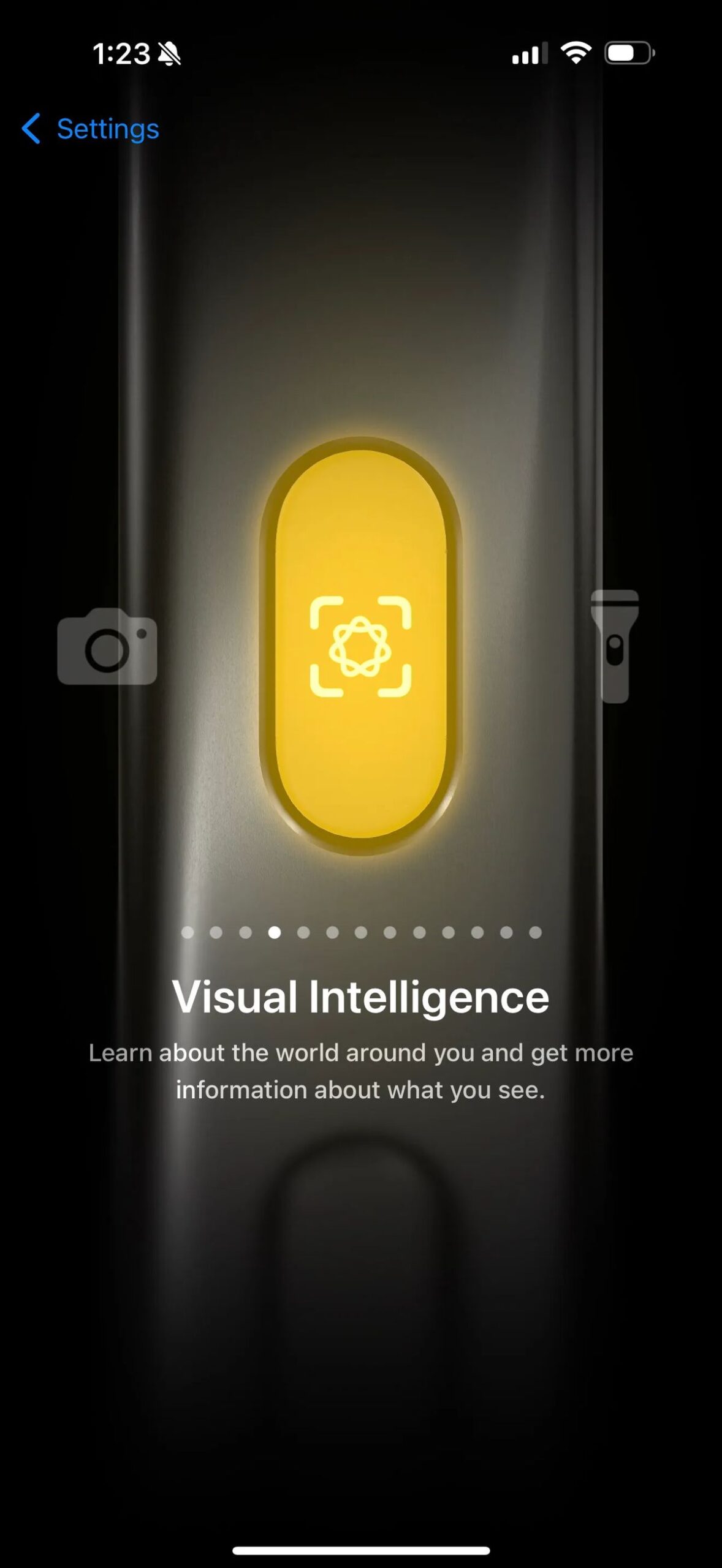

苹果在最新的iOS 18.4开发人员Beta中引入了视觉智能功能,类似于Google Lens,iPhone 15 Pro和iPhone 15 Pro Max的开发人员Beta,正如9to5mac报道的那样。该功能先前已针对这些设备确认,但没有指定的软件更新时间表。

苹果引入了iPhone 15 Pro和Pro Max的视觉智能

预计4月份的iOS 18.4的推出将广泛提供此功能。 iPhone 15 Pro和Pro Max的用户最初于9月为iPhone 16阵容推出,并通过相机控制按钮访问,现在将通过“动作”按钮或控制中心使用视觉智能,类似于iPhone 16E,该iPhone 16E缺少相机控制按钮。

根据 9to5mac,iOS 18.4开发人员Beta 2 Update还增强了整个iPhone 16阵容中视觉智能的动作按钮和控制中心选项。此更新使iPhone 15 Pro和iPhone 15 Pro Max用户可以访问iPhone 16系列外的第一个Google和Chatgpt连接的视觉搜索功能。

iOS 18.3中固定的9个安全缺陷:您现在应该信任苹果情报吗?

在此之前,只有通过在iPhone 16,iPhone 16 Plus,iPhone 16 Pro和iPhone 16 Pro Max上的相机控件的长压才能访问视觉智能。 iPhone 16E的简介促使Apple将视觉智能扩展到动作按钮和控制中心,以方便起见。

从iOS 18.4 Beta 2开始,视觉智能首次对iPhone 15 Pro和iPhone 15 Pro Max用户起作用。尽管这些模型是第一个将Apple Intelligence Support纳入Beta的模型,但他们以前缺乏此特定的AI功能。

苹果证实了iPhone 15 Pro的视觉智能添加,尽管最初没有引用特定的软件更新。值得注意的是,iOS 18.4 Beta 1不包括对iPhone 15 Pro的支持。 9TO5MAC首先报道了Apple开发的选项,以调用无摄像机控制按钮的视觉智能。

除了iPhone 15 Pro和iPhone 16E外,iOS 18.4 Beta 2允许iPhone 16,iPhone 16 Plus,iPhone 16 Pro和iPhone 16 Pro Max通过分配的动作按钮任务或控制中心瓷砖来利用视觉智能。尽管iPad模型的支持与苹果在新设备上的智能兼容,但尚未公告有关iPad模型的支持。

特色图片来源:苹果