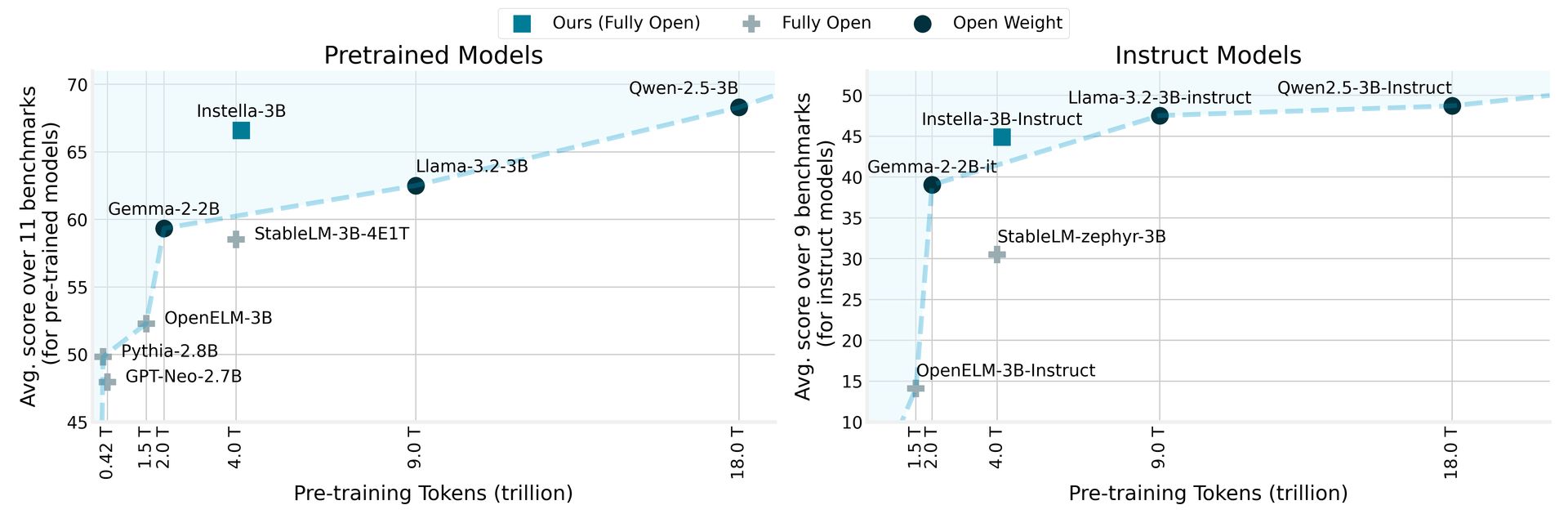

AMD有 揭开了 Instella是一家完全开源的语言模型,其中包含30亿个参数,并在AMD Intinct™MI300X GPU上从头开始训练。 Instella模型的表现优于现有的类似尺寸的开放模型,并有效地与领先的开放权重型号(包括Llama-3.2-3B,Gemma-2-2b和Qwen-2.5-3B)有效竞争,包括其教学版本。

AMD揭幕了Instella:开源语言模型优于竞争对手

Instella采用了一种自回旋变压器体系结构,该结构由36个解码器层和32个注意力头组成,使其能够处理高达4,096个令牌的冗长序列。该模型利用大约50,000个令牌的词汇,由Olmo令牌管理器管理,使其擅长于跨各个域生成和解释文本。

Instella的培训程序突出了AMD的硬件和软件创新之间的合作。这种新模型建立在AMD之前的10亿参数模型建立的基础上,从64 AMD Instinct MI250 GPU的训练过渡到具有1.3万亿代币的64 AMD Instinct MI250 GPU,再到使用128 Instinct MI300X GPU,并使用4.15亿英镑的4.15英寸代币代币,用于目前的30亿参数模型。

通过将Instella与先前的模型进行比较,AMD报告说,它不仅超过了现有的完全开放的模型,而且还可以在最新的开放式体重模型上实现竞争性能,这标志着自然语言处理领域的重要里程碑。该计划与AMD致力于使先进技术更容易获得并促进AI社区中的协作和创新的承诺相吻合。

AMD RX 9000价格可能会让您重新考虑RTX 5090购买

Instella模型阶段和培训数据

该版本包括几个版本的Instella模型,每个版本都代表不同的培训阶段:

| 模型 | 阶段 | 培训数据(令牌) | 描述 |

|---|---|---|---|

| Instella-3B阶段1 | 预训练(第1阶段) | 4.065万亿 | 第一阶段的预训练以发展自然语言的水平。 |

| Instella-3b | 预训练(第2阶段) | 57.575亿 | 第二阶段预训练以增强解决问题的能力。 |

| Instella-3B-SFT | SFT | 89.02亿(X3时代) | 监督微调(SFT),以启用跟随指令的功能。 |

| Instella-3B教学 | DPO | 7.6亿 | 通过直接偏好优化(DPO)对人类偏好和增强聊天功能的一致性。 |

在多阶段培训管道中,第一个预训练阶段使用了来自不同数据集的4.065万亿个令牌,从而建立了基础语言的理解。随后对57.75亿个代币的培训进一步提高了模型在各种任务和域中的性能。

在受监督的微调过程中,Instella-3B-SFT接受了89亿个令牌培训,从而提高了交互式响应能力。最后阶段,Instella-3b-Instruct,使用7.6亿代币进行了直接偏好优化的对齐训练,以确保模型的输出与人类的价值观和偏好保持一致。

AMD使与Instella模型相关的所有工件完全开源,包括模型权重,培训配置,数据集和代码,从而促进了AI社区的协作和创新。这些资源可以通过 拥抱脸 模型卡和 github 存储库。

特色图片来源: AMD