Akamai Technology推出了Akamai Cloud推断,这是一种新的云服务,可提高AI推理任务的效率。与传统的超刻基础设施相比,它提供了改善的吞吐量,延迟减少和成本降低。

Akamai Cloud推断在世界上最分布的平台Akamai Cloud上运行。这项新技术旨在通过更靠近用户和设备处理AI数据来解决集中式云模型的局限性。

Akamai云技术集团首席运营官兼总经理Adam Karon强调了有效分发AI数据的挑战。卡隆说:“使AI数据更接近用户和设备非常困难,这是Legacy Cloud挣扎的地方。”

AKAMAI Cloud的AI推断使平台工程师和开发人员能够更接近最终用户的AI应用程序。该新解决方案可提供3倍更好的吞吐量,并减少2.5倍的延迟。

与传统的超级标准基础架构相比,新工具授权企业在AI推理和代理AI工作量上节省多达86%的工作量。

Akamai Cloud推断的主要特征包括:

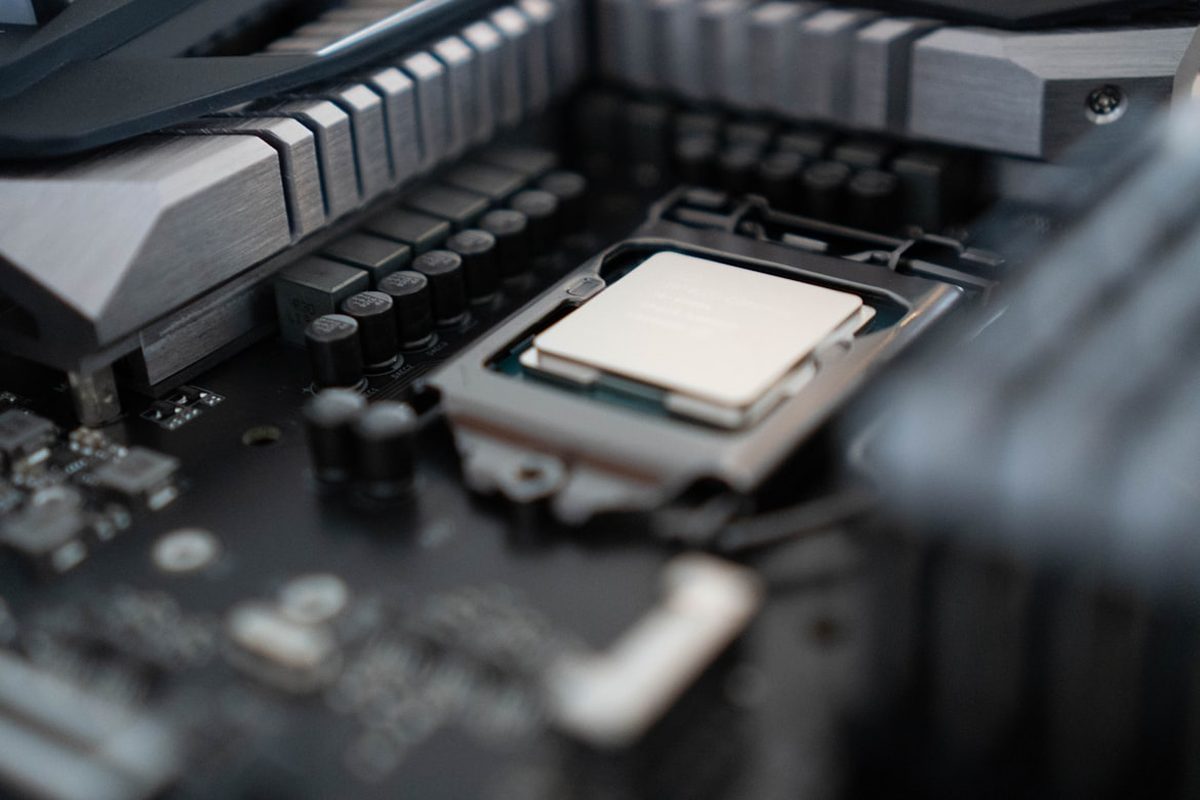

- 计算: Akamai Cloud提供了多功能计算选项,例如用于微调推理的CPU,用于加速计算的GPU和ASIC VPU。等待应对各种AI推理挑战。

- 数据管理: Akamai与大量数据集成以进行实时数据访问,并提供可扩展的对象存储来管理AI数据集。该公司还与诸如Aiven和Milvus之类的矢量数据库供应商合作,以实现检索功能。

- 容器化: Akamai集成了容器化,以提高应用程序的弹性和混合/多云的可移植性。 Akamai提供的AI推断具有kubernetes的速度更快,更便宜且更安全的推论,并由Linode Kubernetes Engine(LKE) – Enterprise支持。新服务可以快速部署AI-Ready平台,包括Kserve,KubeFlow和Spinkube。

- 边缘计算: Akamai AI推论包括WebAssembly(WASM)功能。开发人员在边缘构建了AI驱动的应用程序,从而实现了潜伏期敏感的解决方案。

Akamai Cloud的可扩展和分布式体系结构允许计算资源在全球范围内(从云到边缘)提供,同时加速应用程序性能并提高可扩展性。该平台跨越了130多个国家 /地区的1,200个网络中的4,200点。

Akasm揭示了从大语言模型(LLM)培训到AI推论的转变,强调了对实用AI解决方案的需求。 LLM对通用任务有效,但通常具有高成本和耗时的要求。

企业没有在LLMS上进行大量投资,而是转向更轻的AI模型。这些针对特定业务问题进行了优化,今天提供更好的投资回报。

Akamai Cloud推理支持处理AI数据更接近生成的位置,以解决对更多分布式AI解决方案的需求。

Akamai的新产品代表着朝着分散的AI迈出的显着举措,解决了经典的云计算距离的难题。为什么?因为减少的延迟直接转化为真实的,即时的节省和更好的用户体验,这对于竞争对手来说是一个艰难的组合。

一个特别精明的功能是强调容器化,确保AI应用程序的部署比传统设置更容易和安全。 Linode Kubernetes引擎(LKE) – 企业的使用强调了Akamai致力于为当今技术挑战量身定制的现代,高效工具。