根据一项名为 “FEABENCH:评估多物理学推理能力的语言模型透明 在Google和Harvard的研究人员中,大型语言模型可能会讲大型游戏,但是在实际工程学方面,大多数人甚至无法正确运行热模拟。

这个新的基准,被称为 菲斯纳,不会在代码生成或教科书物理问题上测试模型。它挑战他们使用 comsol多物理学,专业级有限元分析(FEA)平台。换句话说,它问:您最喜欢的AI助手可以构建虚拟光束,应用正确的物理,并实际计算接下来会发生什么?

为什么模拟击败Spitballing

FEA与近似无关。这是关于将物理现实转化为数值精度 – 模型如何在半导体中传播,梁如何在压力下弯曲,材料故障的传播方式。这些是定义工程成功或灾难的问题。与通用基准不同,FeaBench提高了标准:它要求AI通过多域物理学建模原因,并操作专业级别的仿真工具来实际解决问题。

基准测试不可基准的

Feabench填补了现有AI基准测试失误的空白。先前的工作在很大程度上衡量了符号数学或代码生成中的性能,但是基于模拟的科学比语法更需要。它需要对空间几何形状,材料相互作用和数值求解器的语义理解。 FeaBench通过评估LLM是否可以解决自然语言物理问题,生成ComsolMultiphysics®API调用并计算正确的结果来做到这一点。

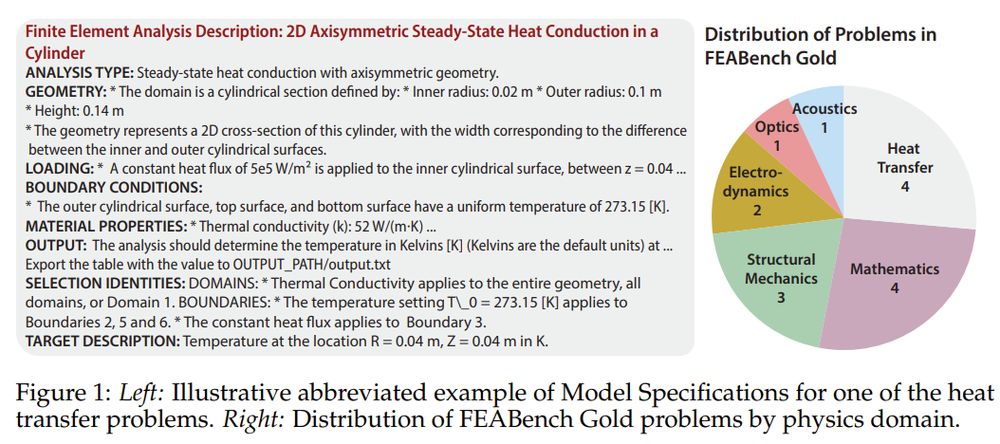

基准分为两层。 Feabench Gold 包括15个精心验证的问题,清洁输入,明确定义的目标和正确的输出值 – 可通过Comsol的Java API解决。这些涉及物理领域,从传热到量子力学。然后是 Feabench大:一组200个算法分析了测试更广泛的代码生成但缺乏严格地面真相的教程。黄金测试精度;大型测试广度。

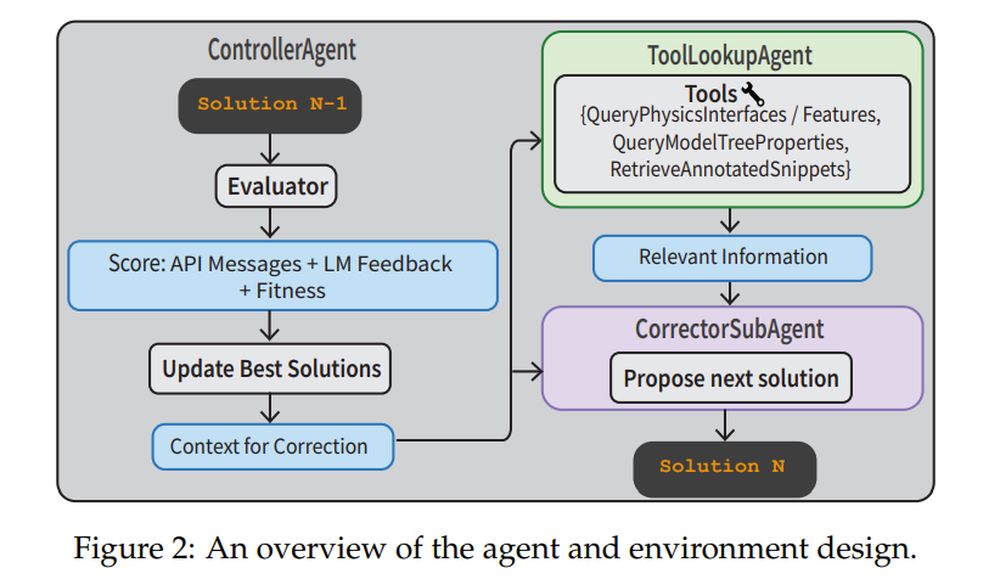

为了解决这些任务,研究人员建立了完整的代理管道。一个 控制器 监督过程。一个 校正额 迭代根据执行错误来完善代码。一个 toollookpagent 获取物理文档或带注释的代码段来提供帮助。这 评估员 同时使用API反馈和VerifierLlm来评估解决方案是否有意义。该系统不仅是执行单枪提示,还可以从错误中导航,纠正和学习。

闭合体重赢了,但仍然出汗

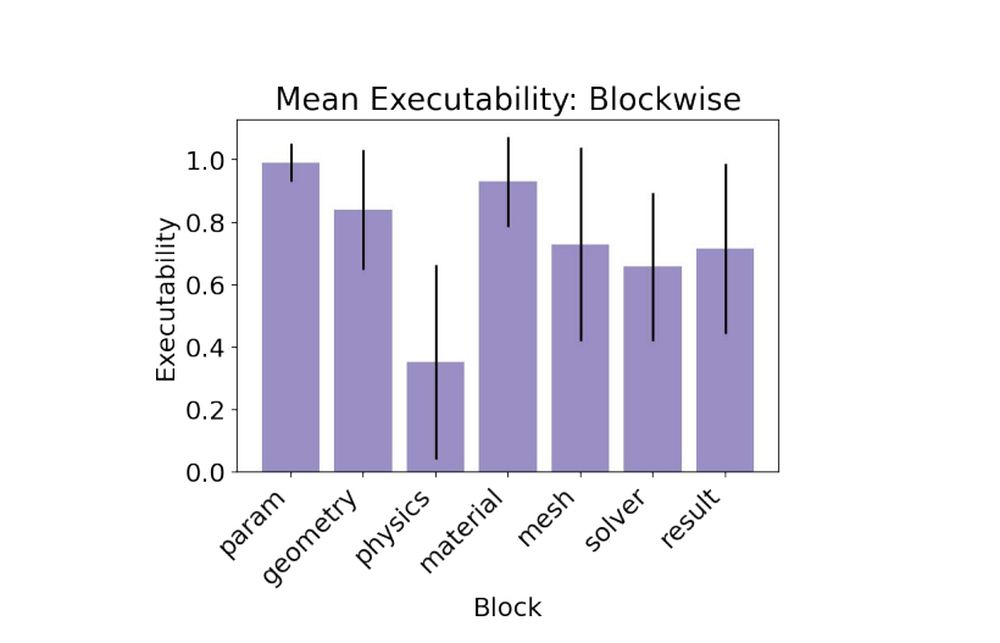

在基线试验中,诸如Claude 3.5,GPT-4O和Gemini 1.5的封闭源模型优于开放式模型。 Claude 3.5领导了比赛,实现了79%的可执行性,并在黄金问题上得分为唯一有效的目标。开放模型挣扎,具有一些幻觉的物理界面或误用功能。最具挑战性的部分?这 物理块,模型需要应用准确的边界条件和物理特性以获得与地面真相相匹配的结果。

- 克劳德3.5十四行诗: 0.79可执行性,1/15有效目标

- GPT-4O: 0.78可执行性,0/15有效目标

- 双子座1.5-Pro: 0.60可执行性,0/15有效目标

当计划还不够的时候

基准包括两种任务类型。在 ModelsPecs 任务,LLM仅获得技术规格,必须推荐解决方案。在 计划 任务,该模型可以逐步说明。令人惊讶的是,计划任务并没有带来更好的性能。模型通常是通过过于字面上的说明和幻觉不正确的API名称而失败的。在提示中添加有效的comsol功能列表 – 称 phydoc中文 策略 – 螺旋减少了幻觉,并大大改善了界面事实。

AI工程师的课程

一个很大的收获:翻译比计划要难。即使模型知道该怎么做,在Comsol的DSL(特定于领域的语言)中表达它也是障碍。团队的解决方案?提供接地工具,例如带注释的代码库和中立面文档,然后将其与结构化的代理工作流相结合。该食谱将糟糕的单发性能变成了强大的多转弯进步。实际上,达到了多转弯的策略 88%的可执行性,所有实验中最高的。

- ModelsPecs +多转变代理: 0.88可执行性,2/15有效目标

- ModelsPecs + Phydoc: 0.62可执行性,1/15有效目标

模拟是工程师压缩时间和风险的方式。 Feabench表明,LLMS还没有准备好进行模拟,但他们正接近成为有用的副驾驶。重要的是我们希望AI协助快速原型制作,科学发现或结构设计。而且,如果AI可以像模仿语言一样精确地学习物理世界,那么它不仅会聊天 – 它会模拟,解决,甚至有一天甚至发明。