野性种子研究人员推出了价值增强近端政策优化(VAPO),这是一个强化学习训练框架,旨在增强大型语言模型对复杂,冗长的任务的推理,从而在AIME24基准上实现了新的最先进的结果。

使用基于价值的强化学习以前面临的重大障碍,培训LLM用于复杂推理。在价值模型偏差方面挣扎的方法,有效地适应了长度变化的响应序列,并管理稀疏的奖励信号,尤其是在基于验证器的任务中,仅提供二进制反馈。

VAPO通过三个核心创新解决了这些挑战:基于详细的价值培训框架,一种基于响应长度的参数调整参数的长度自适应广泛优势估计(GAE)机制,以及先前研究的技术集成。

这种组合创建了一个系统,改进协同工作。使用没有特定SFT数据的QWEN2.5-32B模型,VAPO将基准分数从5到60提高,使以前的最新方法提高了10分。

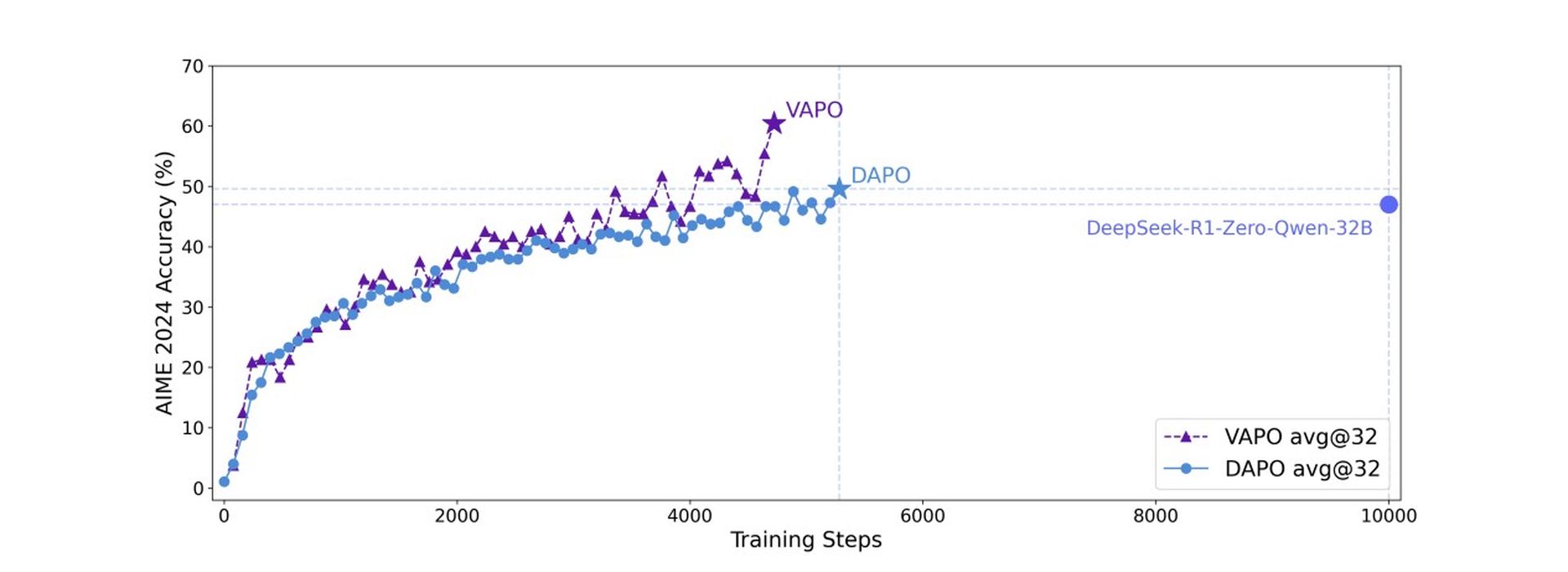

VAPO建立在近端策略优化(PPO)算法的基础上,但结合了关键修改以增强数学推理。训练分析表明,与无价值DAPO方法相比,VAPO表现出更平滑的训练曲线,表明更稳定的优化。

VAPO还显示出更好的长度缩放,以改善概括,归因于其价值模型的颗粒信号的更快得分增长以及在以后的训练阶段的较低熵。虽然减少的熵可以潜在地限制探索,但该方法有效地平衡了这一问题,改善了可重复性和稳定性,并且性能影响最小。

在AIME24基准测试中,DeepSeek R1使用GRPO获得47分,DAPO达到50分。使用QWEN-32B型号VAPO将DAPO的性能匹配,只有60%的更新步骤,并在5,000步中设置了60.4个新的最新分数。相比之下,由于价值模型学习崩溃,香草PPO仅得分仅为5分。

消融研究证实了VAPO内七个不同修改的有效性。价值预言可防止模型崩溃;脱钩的GAE可以完全优化长响应;自适应GAE平衡了短而长的响应优化;剪贴高器鼓励彻底探索;令牌级别的损失增加了长时间反应的加权;合并示例LM损失增加了6分;小组采样为最终得分贡献了5分。

研究人员 强调 利用QWEN2.5-32B模型的VAPO表明,这种基于价值的方法可以果断地超过GRPO和DAPO等无价值的方法,从而为复杂的推理任务建立了新的绩效水平,并解决了长期陷入困境的现场训练价值模型中的基本挑战。