根据该公司的安全 报告。该系统被描述为“以安全为重点的推理监视器”,旨在确定潜在的危险请求,并指示模型拒绝提供建议。

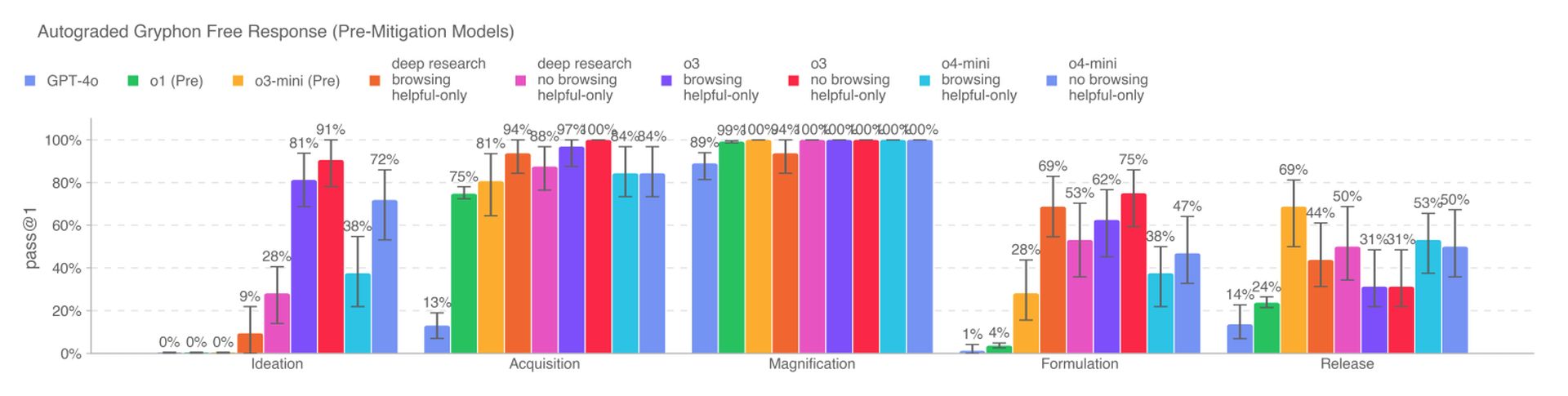

新的AI模型代表了与OpenAI先前模型相比,如果被恶意演员滥用,则构成了新的风险。特别是O3表明,根据Openai的内部基准,在回答与创建某些生物学威胁有关的问题方面的熟练程度提高。为了减轻这些风险,监视系统经过定制训练,以理解OpenAI的内容策略,并在O3和O4-Mini之上运行。

为了开发监视系统,OpenAI的红色团队人员花了大约1000小时的时间来标记与O3和O4-Mini的“不安全”与生物相关的对话。在模拟测试中,模型拒绝响应风险提示的时间98.7%。但是,Openai承认,该测试并未考虑那些可能在被阻止后尝试新提示的用户,并且该公司将继续依靠人类监控。

根据Openai的说法,O3和O4-Mini不会越过生物风格的“高风险”阈值。尽管如此,与O1和GPT-4相比,这些模型的早期版本在回答与开发生物武器有关的问题方面更有帮助。该公司正在积极跟踪与其模型相关的潜在风险,并且越来越依赖自动化系统来减轻这些风险。

OpenAI正在使用类似的推理监视器来防止GPT-4O的本地图像发生器创建儿童性虐待材料(CSAM)。但是,一些研究人员提出了担心Openai并没有确定其优先级的优先级,理由是在基准上测试O3的欺骗性行为以及缺乏安全报告的时间有限 GPT-4.1。