人道首席执行官达里奥·阿莫迪(Dario Amodei) 出版 周四的一篇文章强调了对领先AI模型的内部运作有限的了解,并为人类的目标设定了一个目标,以可靠地在2027年可靠地发现大多数AI模型问题。

Amodei承认了未来的挑战,并指出,尽管人类在追踪模型如何得出答案方面取得了早期突破,但需要进行更多的研究来解码这些系统,因为它们变得更强大。 Amodei写道:“我非常关心在没有更好地处理解释性的情况下部署此类系统。”强调了它们在经济,技术和国家安全中的核心作用。

拟人化是机械解释性的先驱,旨在了解AI模型为何做出某些决定。尽管业绩得到了迅速改善,但该行业仍然对这些系统如何做出决策有限。例如,Openai的新推理AI模型, O3和O4-Mini,在某些任务上的表现更好,但比其他型号更幻觉,而公司不确定为什么。

Amodei指出,AI研究人员改善了模型智能,但不完全理解这些改进为何有效。人类联合创始人克里斯·奥拉(Chris Olah)说,人工智能模型“比建造的更多。” Amodei警告说,在不了解模型如何危险的情况下到达AGI,并且认为我们不再完全了解AI模型,而不是达到AGI,可能是到2026年或2027年。

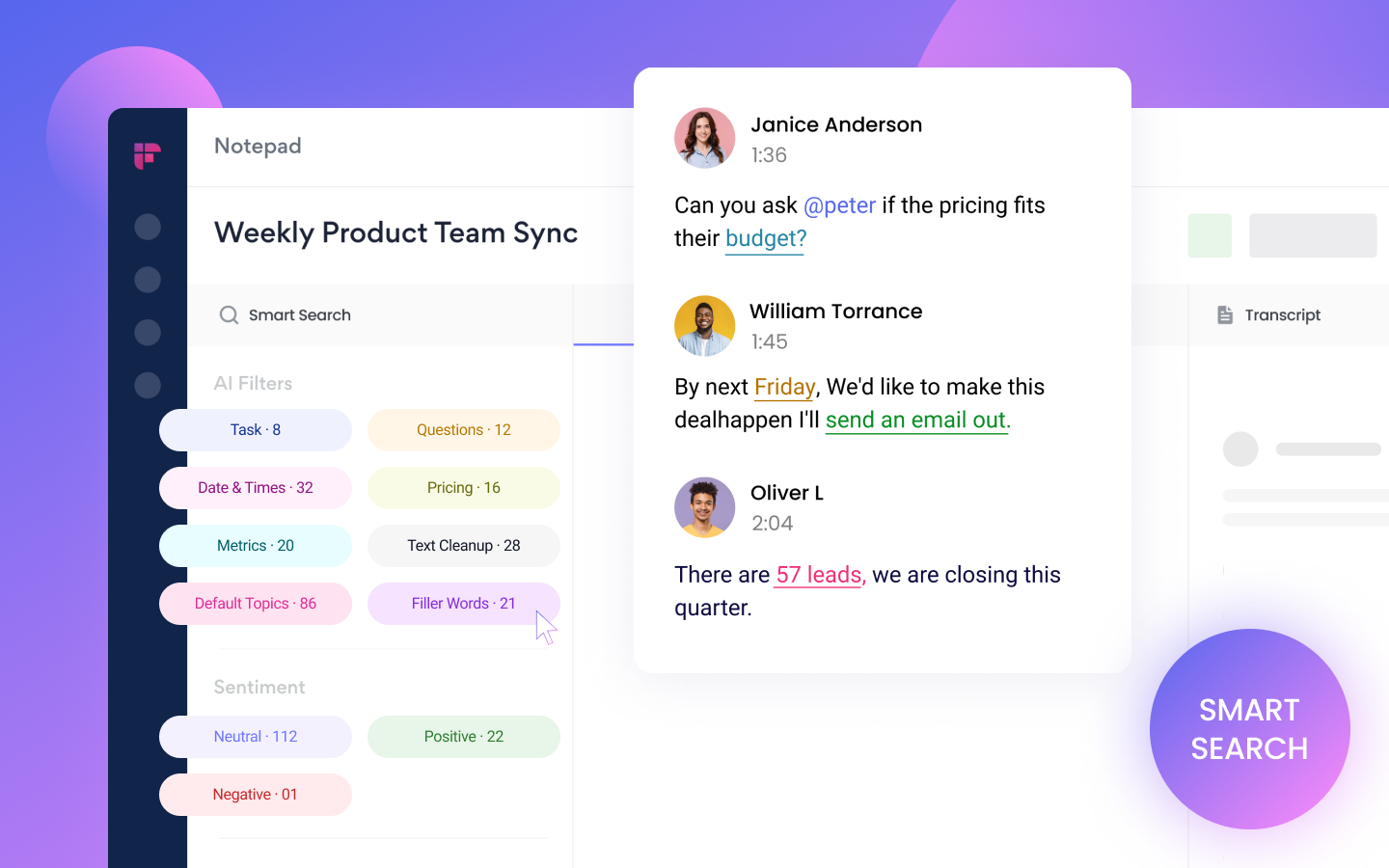

拟人化的目的是进行最先进的AI模型的“脑扫描”或“ MRI”,以识别问题,包括撒谎或寻求权力的趋势。这可能需要五到十年,但对于测试和部署未来模型是必要的。该公司在追踪“电路”的AI模型思维途径方面取得了突破,并确定了一个有助于模型了解美国城市位置的电路。

人类 已投资于可解释性研究,最近在该领域的一家创业公司中进行了首次投资。 Amodei认为,解释AI模型如何获得答案可能会带来商业优势。他呼吁OpenAI和Google DeepMind增加他们的研究工作,并要求政府强加“轻触”法规,以鼓励可解释性研究。

Amodei还建议,美国应对中国筹集出口控制,以限制控制全球AI种族的可能性。 Anthropic专注于安全,对加利福尼亚的AI安全法案(SB 1047)提供了适度的支持,该法案将为Frontier AI模型开发人员设定安全报告标准。

人类正在推动整个行业的努力,以更好地了解AI模型,而不仅仅是提高其功能。该公司的努力和建议强调了对AI安全性和解释性的协作方法的需求。