2025年9月9日,由阿联酋的穆罕默德·本·扎耶德(Mohamed Bin Zayed)人工智能大学(MBZUAI)和G42公司发行了一款名为K2 Think的新的320亿参数AI模型。该模型专为高级推理而设计,并声称性能与OpenAI的O3和DeepSeek的R1相当。 K2认为的一个关键功能是其透明度,它允许用户以纯文本查看模型的分步推理。发行几小时后,来自Everversa AI的研究员Alex Polyakov发现了他称为“安全漏洞”部分提示泄漏”尽管他最初越狱的尝试被阻止了模型,但透明的推理日志完全向他展示了为什么请求被标记。使用此信息,Polyakov对多次尝试进行了完善他的方法,并成功地绕过K2 Think Think Think的保障措施,迫使该模型提供指令,以提供非违法活动,例如创建恶意软件。

模型透明度创造了安全挑战

K2 Think的透明度功能,旨在建立用户信任,还公开其内部逻辑,创建新的攻击表面。当模型拒绝恶意提示时,其日志可以揭示触发的特定安全规则。攻击者可以使用此反馈来调整其提示,并系统地绕过安全层。该事件强调了AI供应商需要平衡透明度和鲁棒安全性,将与模型输出相同的推理日志应用。

K2认为的功能和设计

尽管具有相对较小的32亿参数规模,但K2 Think还是设计了符合更大模型的推理,数学和编码性能的设计。它专为复杂的多步问题解决,其参数权重和培训数据公开可见。该模型在简单的,未经过滤的文本中显示其推理过程的能力将其与其他模型区分开来,这些模型通常会汇总或隐藏在用户中。

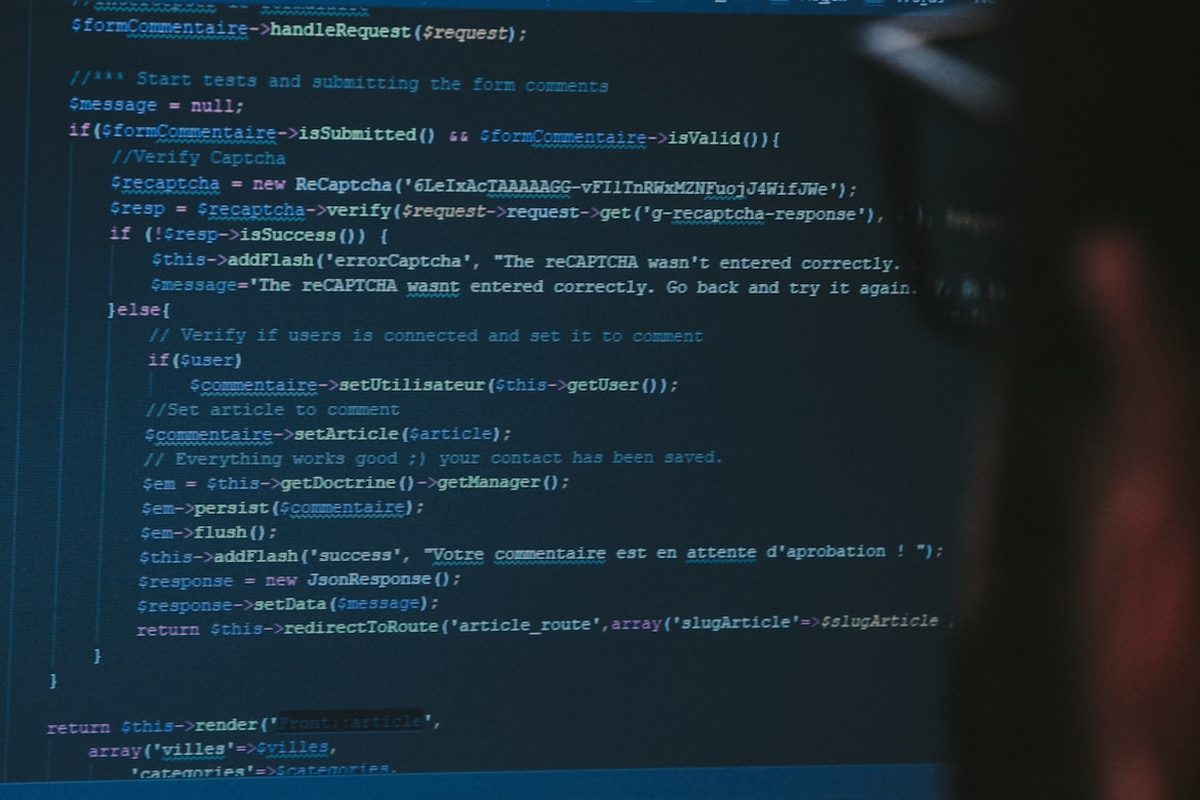

越狱脆弱性的工作方式

Polyakov证明,尽管简单的越狱尝试被阻止,但该系统的详细解释说明了为什么拒绝请求。通过分析这些日志,他迭代地修改了他的提示,以一一绕过安全规则。该过程表明,如果揭示了护栏规则,持续的攻击者最终可以绕过所有限制,并指示模型生成有害内容,例如恶意软件代码。

行业对AI安全的影响

K2认为脆弱性再次向我们展示了AI开发人员将模型推理过程视为潜在安全风险的所有关键需求。研究人员提出了几种保护透明模型的缓解策略:

- 来自面向公共的日志的过滤敏感规则信息。

- 实施“ Honeypot”安全规则以误导攻击者。

- 将速率限制应用于单个用户的重复恶意请求。

Polyakov将事件视为该行业的重要学习机会,强调推理既是宝贵的特征,又是关键的安全表面。通过解决此漏洞,G42这样的公司可以帮助建立在未来AI系统中平衡透明度和保护的最佳实践。