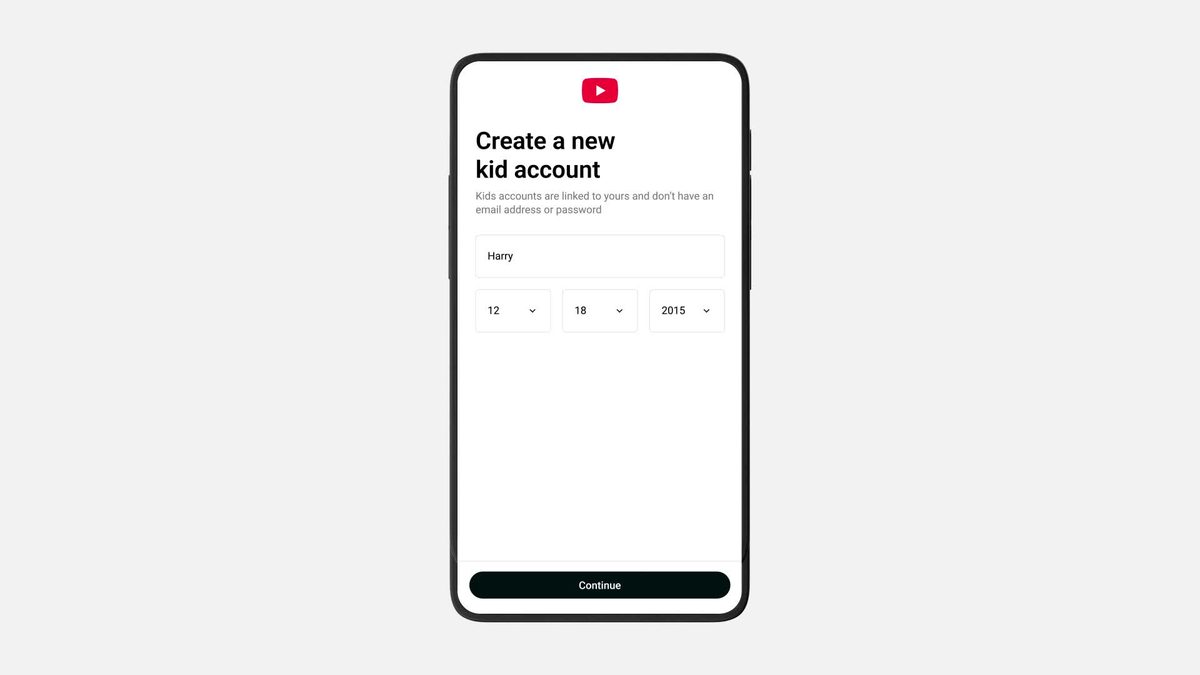

OpenAI 发布了 博客文章 宣布更新 ChatGPT 的模型规范,以提高 13 至 17 岁用户的安全,因为过失死亡诉讼指控该聊天机器人指导青少年自杀或未能适当处理自杀表达。近几个月来,该公司在其面向青少年的旗舰人工智能产品的安全性方面遇到了巨大压力。多项法律诉讼均围绕 ChatGPT 鼓励未成年人结束生命或对自杀意念迹象提供不充分反应的指控。最近的一份公共服务公告通过将聊天机器人描绘成表现出令人毛骨悚然的行为的人物来说明这些互动,这些行为会导致对儿童的伤害。 OpenAI 明确否认了一起涉及 16 岁 Adam Raine 自杀的著名案件中的指控。该博客文章于周四发表,详细介绍了该公司强化的安全措施。其中包括承诺将青少年安全作为重中之重,逐字表述为“将青少年安全放在首位,即使它可能与其他目标相冲突。”模型规范作为一组基本指南,指导 OpenAI 的 AI 模型在各种应用程序中的行为。此特定更新包含一套专门为 18 岁以下用户量身定制的原则。这些原则特别指导模型在高风险互动期间的响应,在这些互动中,伤害的可能性会升级。 OpenAI 将 ChatGPT 修改描述为旨在为 13 至 17 岁之间的个人提供安全、适合年龄的体验。该方法强调三个核心要素:风险预防、运营透明度以及问题讨论的早期干预。根据该帖子,该框架确保敏感主题的结构化处理。对于青少年来说,更新后的系统引入了更强大的护栏,以限制对话中的不安全路径。它提供更安全的替代响应,并在对话转移到高风险领域时提示用户咨询值得信赖的离线支持网络。该帖子通过直接声明详细阐述了这一机制:“这意味着青少年应该遇到更强大的护栏、更安全的替代方案,并鼓励当对话进入高风险领域时寻求值得信赖的线下支持。” ChatGPT 包含协议,可在出现迫在眉睫的风险时引导青少年寻求紧急服务或专用危机资源。这些指令会自动激活,优先考虑立即的人工干预,而不是持续的人工智能参与。登录时表明自己未满 18 岁的用户会触发额外的保护措施。然后,该模型对指定的敏感话题采取高度谨慎的态度,包括自残、自杀、浪漫或性角色扮演,以及隐藏与危险行为相关的秘密。这种分层保护旨在减少青少年用户特有的漏洞。美国心理学协会对 18 岁以下原则的初稿提供了反馈。该协会首席执行官 Arthur C. Evans Jr. 博士在帖子中发表了一份声明:“如果人工智能工具能够与人类互动保持平衡,那么儿童和青少年可能会受益于人工智能工具,而科学表明,人类互动对于社会、心理、行为甚至生物发展至关重要。”他的评论强调了将人工智能与现有的人类支持系统相结合的必要性。 OpenAI 发布了两本新的人工智能素养指南,经过专家审查,针对青少年及其家长。这些资源提供了有关负责任地使用和认识人工智能局限性的指导。另外,该公司正在为 ChatGPT 消费者计划的用户开发年龄预测模型,目前处于早期实施阶段,以加强验证,而不仅仅是依赖自我报告的年龄。

ChatGPT 新规则针对自残和性角色扮演

Please login to join discussion

Recent Comments

您尚未收到任何评论。